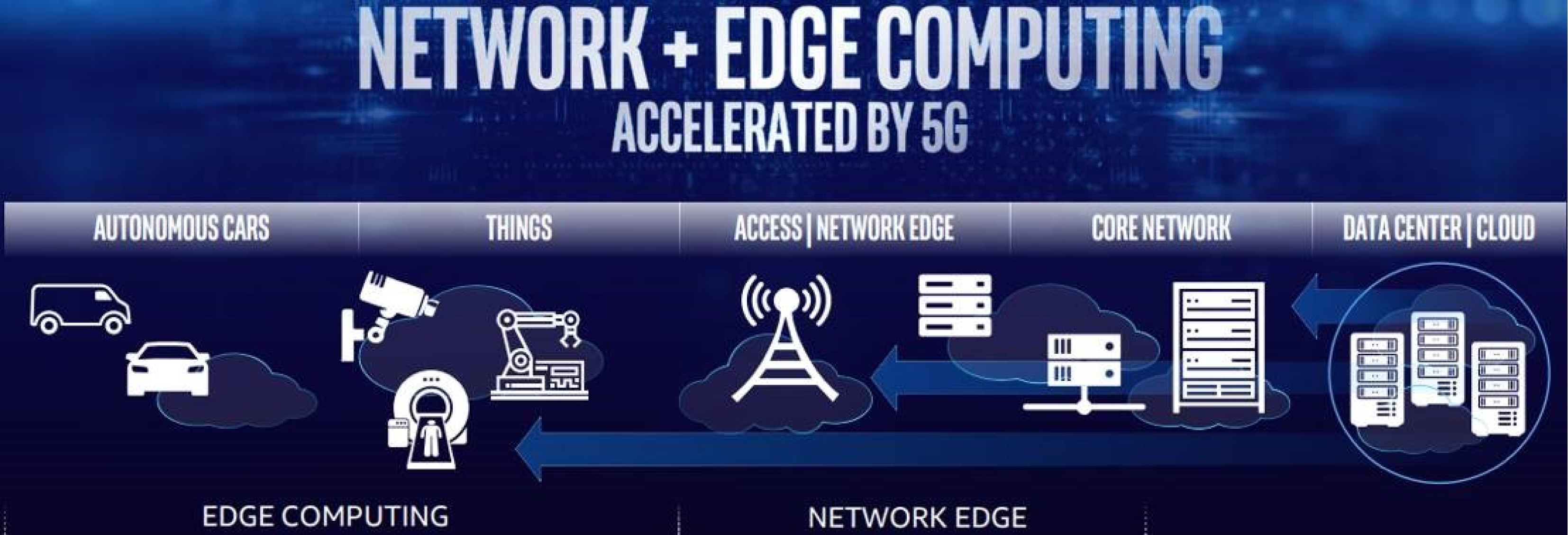

Fig. 1 Architecture of edge computing

图1 边缘计算的总体架构

Fig. 1 Architecture of edge computing

图1 边缘计算的总体架构

2017年,中国信息通信研究院、IDC国际数据集团和英特尔共同发布了《人工智能时代的机器人3.0新生态》白皮书[1],其中把机器人的发展历程划分为3个时代,分别称之为机器人1.0、机器人2.0、机器人3.0.机器人3.0预计将在2020年完成,在此之后,机器人将进入4.0时代[2],机器人将具备更高智能,在更多领域(尤其是服务机器人)中得到普及。但是目前机器人的市场仍以工业机器人为主体,主要以完成重复的、明确的任务为主.而服务机器人虽然发展迅速,但离大规模普及应用还很远.这主要是由于现有机器人系统离机器人4.0提出的自主服务的目标还有相当的距离,尚不能满足用户期望.

机器人系统中还有很多难点亟待解决.本文先介绍有望实现机器人4.0目标的云边端融合的机器人系统架构,再对其中涉及的的3个关键技术:持续学习、时空智能和边缘计算进行整理和讨论,以激发更多研究和思考,共同推动机器人4.0的进步.

机器人的最初设计是在机器人本体中集成了独立的计算系统.2010年提出的云机器人概念引入了云端大脑,实现机器人融合基础设施和共享服务的优点[3].相比于独立的机器人本体,连接云端大脑后的机器人拥有4个核心优势:1)信息和知识共享.很多机器人都通过统一的云端大脑控制,云端大脑可以汇集来自所有连接机器人的视觉、语音和环境信息,经云端大脑智能分析处理后的数据信息又可以被所有连接机器人使用.利用云服务器,各机器人本体获取和处理的信息可以保持最新,并安全备份.2)平衡计算负载.利用云端平衡计算负载可以降低机器人本体的硬件需求,在保证能力的同时,让机器人更轻、更小、更便宜.3)协同合作.通过云端大脑,机器人本体不再独立工作,多机器人可以协同工作.4)独立于本体持续升级.机器人可以独立于本体持续升级.不再受限于本体硬件设备的能力.

IoT应用的快速发展,使得大量数据在网络边缘产生,推动了边缘计算的产生和发展.边缘计算的提出始于4G时代,快速发展于5G时代.如图1所示,边缘计算将计算和存储资源部署到网络边缘,不仅可以减少核心网和互联网上的流量,还可以显著降低传输时延,提高网络可靠性.

随着机器人应用的越发普及,人们对机器人实时响应的需求也越来越多,比如实时进行的推理、场景理解、操控等.而互联网和数据中心的时延,一般情况下由于地理位置分布广和未针对低时延优化,从核心网网关到互联网数据中心可在几十到几百毫秒之间.在5G中,其核心网引入了分布式网关,网关可以下沉到基站附近,边缘服务器可以直接连接到分布式网关上,大大降低网络的端到端时延.因此,机器人4.0将云边端融合的机器人系统架构作为一个关键支撑.边缘计算的引入将增强机器人云端大脑的实时响应能力,同时解决终端能力受限和云计算的实时响应的问题.边缘计算和云计算的结合,将突破终端的计算能力和存储的限制,提高人工智能(AI)算法的训练和推理能力,比如提升精度和降低训练时间.同时将大部分机器人的智能布署在边缘和云端,通过协作和现场训练,持续提升机器人智能水平.

当前绝大多数机器人3.0系统采用以机器人本体计算为主,云端处理非实时、大计算量的任务为辅的系统架构.为了能够精准地感知、理解环境以服务于人机交互,机器人系统通常集成了大量的传感器,因而机器人系统会产生大量的数据.比如采用了高清摄像头、深度摄像头、麦克风阵列以及激光雷达等传感器的机器人,每秒钟可产生超过250 MB数据.如此海量的数据全部传输到云端处理既不现实,也不高效.因此,需要将数据处理合理地分布在云-边-端上.

另一方面,完成感知和理解的AI算法也非常复杂.机器人所使用的AI算法通常需要很强的算力,例如Faster RCNN算法在GPU上可以达到5fps的处理能力,但是GPU的功耗达到200W以上,机器人本体很难承受,从计算成本而言同样也非常昂贵.虽然机器人本体计算平台的计算能力仍在不断提高,但是相对于AI算法的需求依然有限.为了完成机器人的计算需求,需要在云和边缘侧提供算力支持,以实现在大规模机器人应用场景下更有效、更经济的计算力部署.

在通常情况下,云端可以提供高性能的计算以及通用知识的存储,边缘侧可以更有效地处理数据,为终端设备提供算力支持,并在边缘范围内实现设备间协同和共享,机器人终端完成实时地操作和处理等基础功能.然而由于机器人的业务需求多种多样,协同计算的部署也不是一成不变的,机器人4.0系统还要支持动态的任务迁移机制,合理地根据业务需求和现场情况将任务分配到云-边-端,实现云-边-端的无缝协同计算.

云-边-端一体化为机器人提供多样化、规模化的服务(计算、存储)平台.这样的平台可以帮助机器人获得更高的智能,例如持续学习的能力、时空智能等.同时为了更好地支撑这些能力,云边端的系统(尤其是边缘计算技术)也需要不断提高和演进.后续章节将对持续学习、时空智能和边缘计算这3项关键技术进行整理和讨论.

过去的人工智能技术重在算法模型的比拼,如今则更要依赖商业场景的洞察、专家团队的技术积累,将AI和行业实际需求进行结合,产生真正的应用和经济价值.其中,基于特定场景的部署、架构的建设以及其他数字化技术联动的差异,业内已经将AI与IoT结合形成AIoT,例如小米的智能家居产品;将AI与云平台能力结合,例如百度的飞桨、无人驾驶、阿里的云计算驱动的智能城市、腾讯的泛娱乐业务;将AI与边缘计算深入融合,例如英特尔的云-边-端融合的自主系统方案.这些与产业全面联通相结合的AI+产业等发展路径,将会共促人工智能和实体经济的深入融合.

作为人工智能浪潮内最为突出的技术贡献之一,深度神经网络在固定任务的表现已经得到了广泛的认可,其在互联网,泛工业,诸如能源、交通、制造业等领域的应用范围和效果都得到了前所未有的突破.训练好的深度神经网络是一个静态的知识实体,但是在扩展此知识容量的过程中通常会导致已学习任务的灾难性遗忘.比如,在计算机视觉应用中,用神经网络算法去识别日常生活用品,当新的用品需识别时,如果对深度神经网络做出微调(fine-tuning),对旧的、早先训练过的日常物品的识别率就会显著降低[4].目前的业内解决方案主要有2种:1)多模型多任务,也就是每个任务需要存储一个模型.这是在不考虑功耗、计算、存储等资源限制情况下的妥协选择.但是实际的诸如计算机视觉的任务,往往有很多相似可以共享的知识,冗余的模型设计带来的就是计算和存储量、部署成本的陡增.2)用所有需要学习的任务数据来调整神经网络,这种方案对于部署周期短、更新迭代快的落地场景通常是不适用的,因为时间上往往来不及,消耗的人力成本也非常高,很难作为一个长期的商业上可行的解决方案.

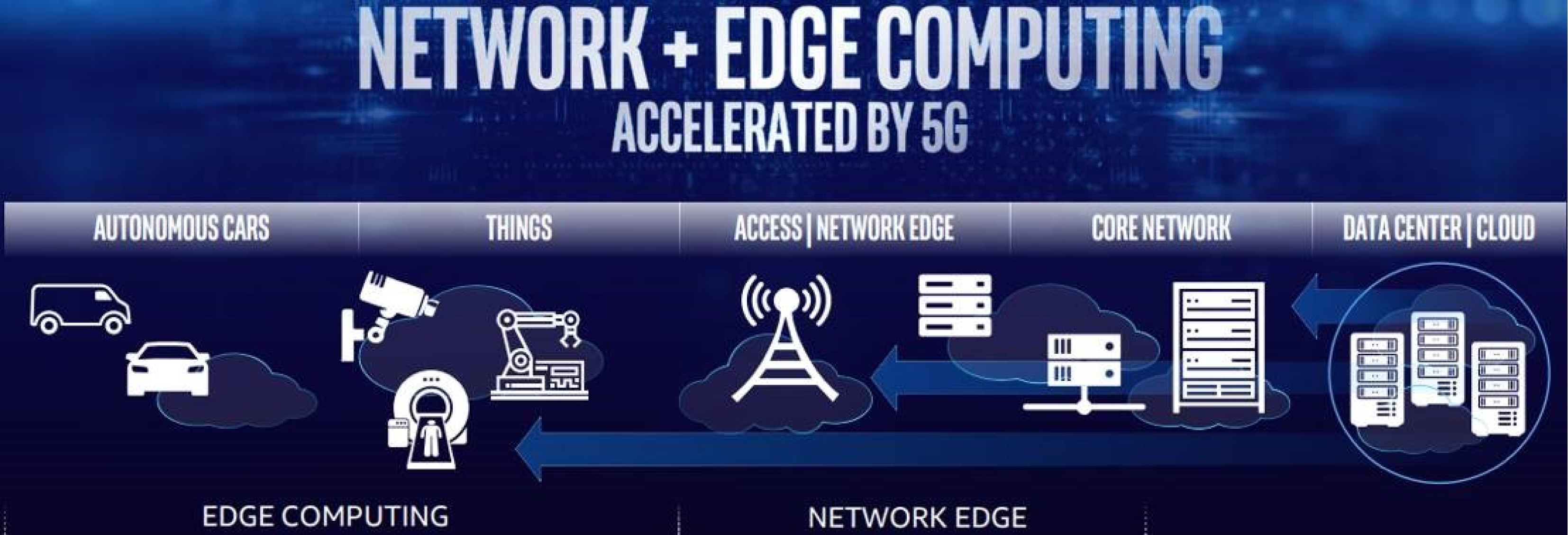

持续学习将主流深度学习的范式转变成动态针对多项任务的过程,通过尽量少的网络模组的协同工作可以不断积累多项任务的知识,而无需从头开始进行再训练,旨在减轻遗忘,快速进行知识的有效迁移.例如,对于计算机视觉问题中的持续学习能力,主要关注如何在多个连续视觉任务中保证算法的稳定性,如何有效克服神经网络中灾难性遗忘的问题,如何将旧任务的知识快速迁移到新的任务中,以及如何在硬件受限情况下优化持续学习的综合表现.图2比较了持续学习与其他机器学习方法的主要区别,持续学习在实用性和生物智能性2个维度上都明显优于其他方法.

Fig. 2 Continual learning: Towards both interpretable and practical learning method

图2 持续学习:通向可解释性和实用性并存的学习方法

边缘计算包括一系列使用机器学习进行推演的嵌入式设备.它们具有数据采集、分析的基本能力.边缘设备采集的数据可以用作训练数据集,在服务器端(例如云服务器)等计算能力强的计算设备中进行模型的训练,随后再将训练好的模型部署到计算能力较弱的边缘设备执行推理.这就好比战场上,前线军官对于一些简单任务可以自主决策,无需上报将军,而对于难度较大或难以综合判断的任务则需要向上汇报.这样,达成部分自主的功能,从而增加系统计算的灵活性.边缘计算不仅能缓解网络宽带和数据中心压力,而且能够保护隐私数据,做到速度、安全、灵活、可靠性合为一体.

随着计算模型的不断优化和边缘计算能力的不断提升,很多深度学习的推理工作已经在边缘计算领域顺利开展,机器学习的第一波浪潮是在云端,我们相信下一个突破点将会在边缘端.目前大规模的深度学习训练过程主要还是在云端,这就大大限制了部署在边缘端模型更新迭代的时间.并且随着数据量的陡增,就算边缘计算的能力有所提升,还是很难满足边缘端进行训练模型的要求,这就自然而然地引领出对持续学习的强烈需求.持续学习,是机器学习领域中新起,关注仅利用当前最新数据和部分历史数据使模型不断快速迭代的有效手段.

边缘计算和深度学习的研究结合点有很多,我们将其大致分为5种,各有不同的侧重点[5].1)边缘端深度学习的应用,包括对技术框架提供的智能服务的分析和应用的探索;2)边缘端深度学习方案的推理,侧重边缘计算架构中深度学习的实际部署和推理,用于满足不同准确性和时延性的要求;3)支撑深度学习框架的边缘计算服务,为深度学习各种模型算法提供给网络结构、硬件和软件的设计;4)在边缘端进行深度学习的训练,侧重于在资源和隐私限制条件下,训练分布式边缘设备中的深度学习模型;5)为深度学习在边缘端进行优化,对边缘缓存、计算卸载、通信、安全保护等方面进行全面优化.

持续学习的方案,主要侧重点在于第2和第4个方向,让边缘端具备持续学习、理解、推理的能力.由于边缘端计算能力的受限,无法大规模地进行模型的重新训练,首先我们想到的就是利用诸如知识蒸馏[6-7]等迁移学习、领域自适应的方案,通过在云端训练的“教师模型”去传授边缘端“学生模型”的大部分知识,然后“学生模型”通过各个场景特有的传感器数据进行少量数据的重新训练.再者,持续学习的边缘计算需要将部分隐私性很强、比较敏感关键的数据留在边缘端,此时深度生成模型是一个关键的技术.通过诸如对抗生成网络(GAN)[8-9]、变分自动编码器(VAE)的近期研究[10-11],生成的样本质量和多样性已经有了很大的突破.这样只需在边缘端存储生成模型,而云端或客户端给予输入的随机变量便可以生成某个任务的样本数据用于rehearsal的边缘训练,进行持续学习.第3个可以借助的力量是联邦学习,其本质上是一种分布式的机器学习技术框架,目标在于在保证数据隐私安全及合法的基础上实现共享建模,其起源是谷歌在2016年提出用于解决安卓手机终端用户在本地更新模型的问题[12].联邦学习的引入会产生的主要优势包括:1)对用户各自数据的相对隔离,满足用户隐私保护和数据安全的要求;2)模型质量的无损,尽量减少学习的负迁移;3)能够在保证各个参与端相互独立的情况下,进行信息与模型参数的加密交换.

许多机器人需要在以人为中心的环境中工作,发挥机器人的优势,自动执行某些任务,帮助人类解决某些问题,真正成为人类的助手.这要求机器人可以像人类一样学习、理解和执行任务.这对机器人提出了非常高的要求,要机器人像人一样感知周围环境(目标、障碍和导航);像人一样去了解每个人的类型和属性;像人一样规划和实施行动;像人一样执行操作;最终再像人一样进行总结和修正.从人工智能发展的历史看,单一方法很难彻底解决这些问题,未来需要多种方法结合的AI系统[13].从最近几年的研究进展看,这也是未来人工智能取得进一步突破的必经之路.所以设计一个统一的框架,把这些方法和问题统一起来,显得尤为重要.我们认为时空智能是一个关键性概念.时空智能是人工智能向外感知的重要组成部分,让机器对周围环境进行多层次、多角度的时空感知,从而进行自主决策.时空智能具备3个核心功能:

1) 时空记忆.整理和记录时空中所发现的物体、行为、属性等.

2) 时空推理.发现和预测一些不能直接观测到的事件、属性等.

3) 时空学习.探索和总结一些规律性的知识,并在应用中不断泛化和修正.

为了实现这些功能,时空智能通常需要集成从高到低多个层次的知识表示以方便高效地进行推理.这里,越高层的知识与人对环境的理解越接近,侧重于语义和关系的表示;越低层的知识表示越接近于机器人的感知和控制系统,没有结构或符号,多为原始的数据.

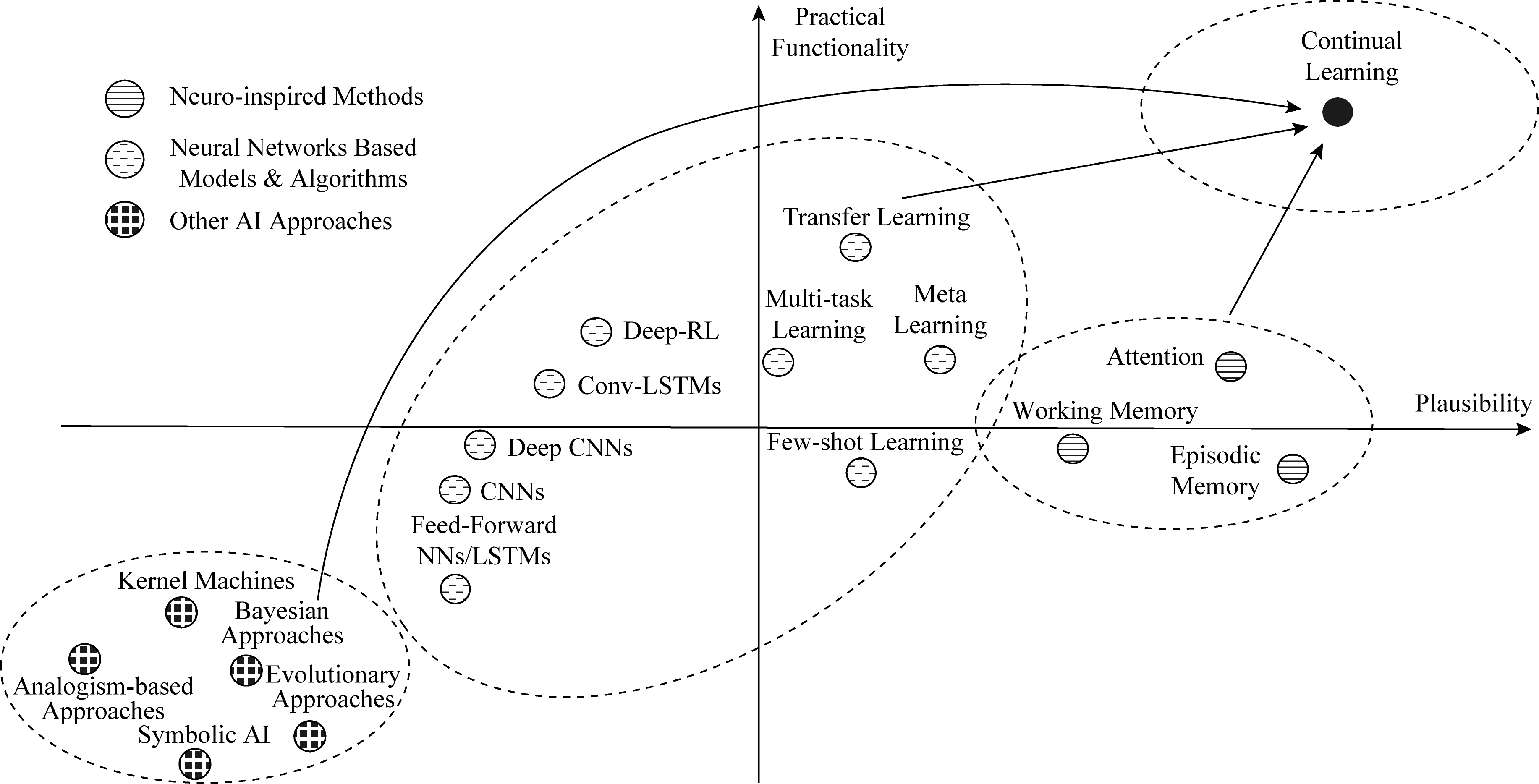

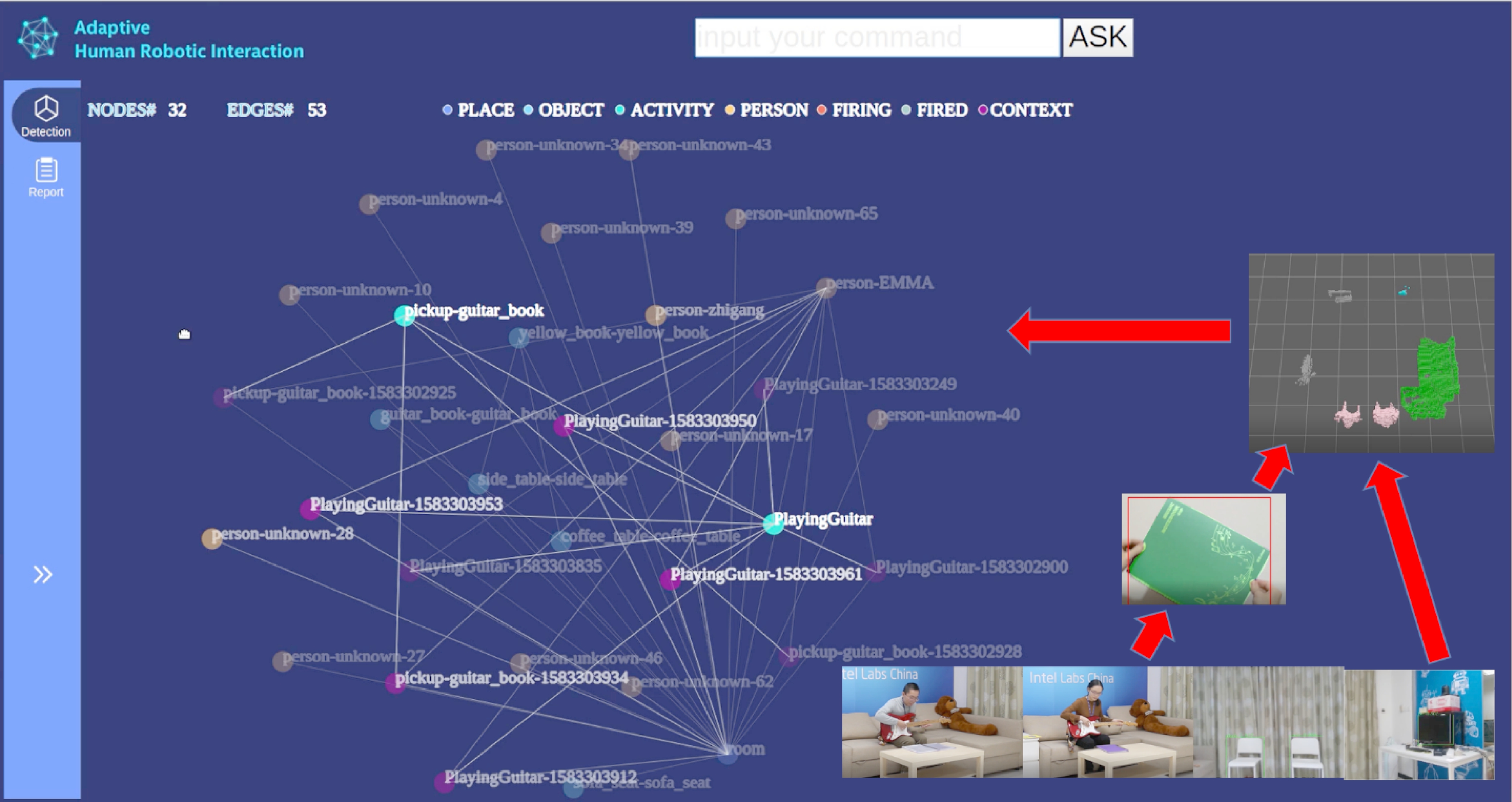

英特尔中国研究院研发的自适应机器人交互能力库2.0[14],在为服务机器人提供的时空智能的方向上迈出了坚实的一步.如图3所示,该库向用户提供丰富的多层次的知识表示和对应的推理能力.最底层是传感器层的知识表示(图3右下角的图片流).传感器的原始数据被完整高效地保存下来.传感器层的上一层是感知层的数据和模型.利用机器人同时定位与建图(SLAM)技术,地图层将感知层的数据转换为一个三维语义地图.最后,地图中的语义信息被整理分析后,汇总至一个动态的、实时变化的知识图谱.各个层次的信息,通过时间戳(时间信息)和位置(空间)映射到一起,换言之,任意层次的任何一个信息都可利用其中的时空属性找到它在其他层次上的对应表示.这不仅使得机器人可以在不同的层次中进行推理和学习,更让不同层次的推理结果可以相互促进,推动机器人自主地、持续地学习,不断提高机器人的能力.具体来说,这样的时空智能,赋予了机器人的4种能力.

1) 几何关系的推理.几何关系既可以是非常精确的深度和位置信息,例如图3中沙发的精确位置和尺寸;也可以是粗略的相对关系,例如图3中的沙发可以坐2个人.这与人对世界的几何关系的理解是一致的.机器人可以根据任务的不同,查询不同精度的信息.

2) 物体的稳定性和安全性的关系的推理.在建立了三维地图后,机器人可以分析出物体在空间中的关系.而随着时间的推进,这些信息会在机器人的时空记忆中不断积累,这对于机器人自主移动和操纵物体是非常有帮助的.通过引入物理关系的仿真分析,机器人甚至可以理解物体间的支撑关系,这可以为机器人确保环境的安全性提供支持.

3) 物体和行为关联关系的推理.随着时间的推移,在知识图谱中很容易发现一些一起出现或者先后出现的关系,这些关系能为机器人提供很多指导性的信息.例如,图3所示的例子中,机器人发现弹琴和拿某个文件夹经常一起发生,据此机器人可以猜测该文件夹和琴相关,经询问用户,机器人确认该文件夹是琴谱.利用回溯历史的原始数据,机器人可以通过少样本学习和持续学习技术更新感知层中的模型[15],以后即可准确识别该琴谱.另外,此类信息也可以帮助机器人在未来提供更好的服务,比如主动将书架上的琴谱拿给正在弹琴的客人.

4) 异常关系检测.时空智能的语义层以语义的方式汇总了各个时刻从不同的感知模块获取的信息.通过引入本体信息,可以在语义层面发现现有知识图谱中的异常,进而告知出现错误的感知模块,让该模块进行自我修正,从而帮助底层模块的自我进化.在图3的实验过程中,机器人就曾经上报过一个异常,真实情况如图4所示,底层的感知模块把一个日常生活中不常见的展示台误认为马桶.仅靠感知模块是无法修正错误的,但有了时空智能后,通过高层的分析,很容易发现在书架和沙发旁出现马桶这一异常事件,进而进行修正.

Fig. 3 Multi-level spatial-temporal intelligence

图3 多层次的时空智能

Fig. 4 Anomaly detection

图4 异常检测

把时空智能根据计算、隐私等需求分布到在从云到端的各个地方,充分利用云边端的计算资源去提供更高性价比的服务,把要完成任务的记忆场景的知识和常识很好地组合起来,是实现规模化部署的一大助力.云边端的解决方案将让时空智能在3个方面受益.

1) 有了云和边缘服务器的支持,使得在时空智能框架中引入更准确的、更细粒度的、也更复杂的感知模块成为可能.比如,我们可以将现有系统中的物体检测变成物体分割,这样物体间的几何关系的推理也会变得更准确.

2) 加速训练过程.时空智能中的知识是多层次表示的,在高层经常会推理产生一些新的知识.得益于持续学习,低层次的模型也可以利用这些知识不断地提高自己的能力.但模型的更新和训练是一个耗时的过程,这在一定程度上影响了时空智能的效果.例如3.2节琴谱的例子,若在端上进行训练,需要一天时间,而如果在一天时间里发生关于琴谱的交互,将会影响用户体验.遑论有些训练根本无法在端上完成,云边端融合的方案可以帮助时空智能走出这个困境.

3) 推进知识共享学习.基于单一机器人的知识积累是一个比较缓慢的过程.但是时空智能,尤其是高层的知识是完全可以共享的.在云侧和边缘侧,把一些知识汇总起来,并有效泛化后,再把新的智能模型分发到端上,将会快速提高机器人的时空智能,让机器人更好地服务于人.

未来超过70%的数据需要在边缘侧分析、处理和存储,边缘计算领域的多样性计算架构、产品与解决方案越发重要.边缘计算是在靠近物或数据源头的网络边缘侧,融合网络、计算、存储、应用核心能力的分布式开放平台(架构),就近提供边缘智能服务,满足行业数字化在敏捷联接、实时业务、数据优化、应用智能、安全与隐私保护等方面的关键需求.边缘计算软件平台采用云原生架构与关键技术,硬件平台支持超异构计算能力,以边云协同和边缘智能为关键特征,形态上主要包括云边缘、边缘云、边缘网关.

1) 云边缘作为公有云的延伸,将云的部分服务或者能力扩展到边缘基础设施之上.中心云和云边缘相互配合,实现全网资源共享、全网统一管控等能力.

2) 边缘云基于云计算技术与架构构建的边缘分布式开放平台,可提供集中管理和调度的能力,边缘云内及边缘云之间可以进行资源共享.

3) 边缘网关是企业 行业数据的接入节点,是网关设备基于云计算技术的演进,可实现网关内资源共享.

行业数据的接入节点,是网关设备基于云计算技术的演进,可实现网关内资源共享.

随着云游戏、VR AR与自动驾驶等应用的兴起,以及物联网、移动应用、短视频、个人娱乐、人工智能的爆炸式增长,应用越来越场景化和多样化,带来数据的多样性(如语音、文本、图片、视频等)以及用户对应用体验要求的不断提高.计算密集型应用需要计算平台执行逻辑复杂的调度任务,而数据密集型应用则需要高效率地完成海量数据并发处理,使得单一计算平台难以适应业务场景化与多样化要求.异构计算可以满足边缘业务对多样性计算的需求.通过异构计算可以满足新一代“连接+计算”的基础设施的构建,可以满足碎片化产业和差异化应用的需求,可以提升计算资源利用率,可以支持算力的灵活部署和调度.在各类边缘计算场景中,不同的计算任务对于硬件资源的需求是不同的,从计算模式、并发数、迭代深度等多方面考虑,可能需要CPU,GPU,NPU,FPGA等多种类型的芯片支持.传统的异构计算并不能满足现在计算的要求,而超异构计算已逐渐成为业界思考的一个趋势.具体来说,超异构计算整合先进计算单元有3个关键点:1)与板级设计一样,用多功能、多架构的芯片处理和加速不同的运算负载;2)把计算单元封装在一个芯片里,但这与板级层面的连接不同,是在封装层设计先进的技术,把带宽放大,同时功耗降低、体积减小,是一种封装集成技术;3)使用这种复杂的超异构模式,不能给软件开发人员增加难度,因此超异构计算还需要统一的异构计算软件[16].

AR与自动驾驶等应用的兴起,以及物联网、移动应用、短视频、个人娱乐、人工智能的爆炸式增长,应用越来越场景化和多样化,带来数据的多样性(如语音、文本、图片、视频等)以及用户对应用体验要求的不断提高.计算密集型应用需要计算平台执行逻辑复杂的调度任务,而数据密集型应用则需要高效率地完成海量数据并发处理,使得单一计算平台难以适应业务场景化与多样化要求.异构计算可以满足边缘业务对多样性计算的需求.通过异构计算可以满足新一代“连接+计算”的基础设施的构建,可以满足碎片化产业和差异化应用的需求,可以提升计算资源利用率,可以支持算力的灵活部署和调度.在各类边缘计算场景中,不同的计算任务对于硬件资源的需求是不同的,从计算模式、并发数、迭代深度等多方面考虑,可能需要CPU,GPU,NPU,FPGA等多种类型的芯片支持.传统的异构计算并不能满足现在计算的要求,而超异构计算已逐渐成为业界思考的一个趋势.具体来说,超异构计算整合先进计算单元有3个关键点:1)与板级设计一样,用多功能、多架构的芯片处理和加速不同的运算负载;2)把计算单元封装在一个芯片里,但这与板级层面的连接不同,是在封装层设计先进的技术,把带宽放大,同时功耗降低、体积减小,是一种封装集成技术;3)使用这种复杂的超异构模式,不能给软件开发人员增加难度,因此超异构计算还需要统一的异构计算软件[16].

边缘计算催生超异构计算架构的另一个背景是AI和5G在近年都达到了可用性(5G在2019年试商用,在2020年正式商用),AI×5G的聚变效应以后,计算就将进入超异构时代.目前这种AI×5G的聚变效应在某些边缘计算场景上,例如智能交通中已经有所体现:AI算法可以对视频数据进行实时分析,但这种分析不能全在云端上,还需要利用5G的能力在前端、边缘端做一些分析筛选的配合;而数据到了云端之后,需要利用云端的全场景模拟,例如数字孪生,去实现与真实场景的同步性,而“同步”依靠的正是5G.未来随着更多更复杂的边缘计算场景的落地,对上述流程还会提出更高的要求,AI×5G的聚变可能比我们想象得还要猛烈,将激发对数据传输、存储、计算、分析等方面的需求增长,而超异构计算,是这些需求反应中的一个被触发的技术点,这种技术发展的背后,是整体的计算机技术趋势走向更加深度的整合协同.

在云边缘、边缘云、边缘网关的系统架构中,针对业务类型和所处边缘位置的不同,边缘计算硬件选型设计往往也会不同.相对硬件架构设计,系统软件架构的确存在着一定的共同特性,比如与设备无关的微服务、容器及虚拟化技术、资源调度和编排等.以上软件技术统一了云端、边缘甚至是物(机器人)端的服务运行环境,并提供了统一的部署和运维接口,这些技术背后的支撑从云原生软件架构在边缘的演化可窥一斑.典型的边缘系统软件架构如图5所示.

Fig. 5 Software architecture of edge computing

图5 边缘系统软件架构

在云计算领域,传统IT软件的微服务化已经得到了充分的演化而日趋成熟.而边缘计算是传统的工业领域的OT(operational technology)、通信领域的CT(communications technology)和IT的融合.考虑到仍有相当一部分的CT和OT的软件实现是基于整体式架构并根据定制的需求开发的,因此传统CT和OT的微服务化是边缘计算软件演化的重要课题.

在一些复杂的边缘计算的应用场景中可以看到边缘计算平台并不是传统意义上的只负责数据收集转发的网关,更重要的是,边缘计算平台需要提供智能化的运算能力,而且能产生可操作的决策反馈,用来反向控制设备端.过去,这些运算只能在云端完成.现在需要从云边议题的角度考虑将云端的计算框架通过裁剪、合并等简化手段迁移至边缘计算平台,使得能在边缘计算平台上运行云端训练后的智能分析算法.边缘软件架构需求通常是单台计算机或者少数几台计算机组成的小规模集群环境中隔离主机资源,实现分布式计算框架的资源调度.同时,边缘计算所需的开发工具和编程语言具有多样性.目前,计算机编程技术呈百花齐放势,开发人员运用不同的编程语言解决不同场景的问题已经成为常态,所以在边缘计算需要支持多种开发工具和多种编程语言的运行时环境.而随着容器技术和容器编排技术逐渐成熟,通过容器技术进行资源的隔离、调度和编排将是边缘软件架构的演进方向.

1) 安全容器

在传统的云计算方案中,虚拟机是主流的解决方案,相比于传统的物理实体机,具有启动快、部署简单、低成本等显著优势.但是随着技术的演进,和目前急剧增长的数据带宽和计算需求相比,虚拟机已经无法满足在目前已有的边缘计算中的低成本、低时延、高并发等特性,因此符合上述要求的容器技术成为了新趋势.容器技术相比于传统的虚拟机而言具有更快的启动速度、更低的单位成本、更轻量级的资源切分等显著优势,很好地满足了云计算场景对技术演进的实际需求.

在此大背景之下,边缘网络计算也会采用主流的容器技术作为通用的解决方案.容器虽然可以对宿主机的资源按需求进行隔离和分配,但是运行在同一个宿主机上的所有容器是共享宿主机内核的.在这种情况下,容器与容器之间的数据安全性得不到充足的保证,容器内的数据对于宿主机而言也是内部可见的.在对数据安全和算法私密性日趋严格的情况下,基于虚拟机的安全容器技术,如Kata Containers既具有可以媲美容器的启动速度和低资源消耗,又具有虚拟机对数据安全和数据私密性的保护,很好地结合了虚拟机的安全性和容器的轻量级优点.因此,在边缘计算场景中,Kata Containers已经受到业界越来越多的关注和实际应用[17].

2) 神经网络模型部署

边缘计算的初衷在于提供高能效、低延时的数据处理能力,而机器人往往又需要同时利用多种神经网络模型实时处理多路传感器数据,因此模型的运行效率至关重要.常见的神经网络模型压缩技术,如剪枝、量化等,自然可以应用于边缘端部署,这方面已经有成熟的自动化工具Distiller[18].在针对特定架构的性能加速层面,工业界也提供了相应的模型优化和部署工具,如英特尔OpenVINO工具包,能够自动优化训练好的神经网络模型并高效执行.而针对机器人4.0的需求,更多系统层面的优化技术仍处于研究的早期阶段,我们将其归纳为3个方向.

① 计算层次之间的协同处理.例如,early-exit技术能够通过在浅层网络给出部分样本的推理结果而降低对这部分样本的计算量[19].若将该技术与云-边-端架构相融合,不仅能够实现数据的“多级分诊”(即仅当前一端无法以高置信度取得结果的数据才发送给后一端做进一步判断),取得计算、通信开销与模型准确度之间的更好均衡,还能辅助实现多设备间的协同推理[20].

② 多路数据之间的协同处理.例如通过缓存模型推理结果,可以在来自不同设备的相似数据之间实现结果复用,从而极大降低边缘服务器计算负载并缩减响应时间[21].

③ 多个模型之间的协同处理.通过优化模型之间的资源调度,以及实现模型复杂度和精度之间的在线折衷等方式,在资源受限情况下优化整体性能.这方面的代表性工作包括DeepEye[22],NestDNN[23]和HiveMind[24]等.

以上所举研究并非专门针对机器人系统开展,但我们认为相关技术必定可使未来的机器人4.0系统从中受益,且广泛部署的机器人应用也将为相关研究提供更多案例和数据支持.

边缘计算与智能机器人研究看似不相关,实为通向机器人4.0所需智能的关键支撑.其支撑作用有3个层面.

首先,边缘计算可为机器人4.0所需智能提供强大灵活的计算和存储能力.机器人本体受限于功耗和成本考虑,其自身计算和存储资源往往不足以支撑实现高层次人工智能,边缘服务器则能够在满足时延要求的前提下提供高效的处理能力.另外,在机器人智能演进过程中,所需处理能力也经常有所提升,但对已部署的机器人执行硬件升级成本较高,而将处理置于边缘服务器更易于灵活升级.

进而,边缘计算可帮助实现多设备间的协作能力.在实际机器人应用中,同一空间内往往需要若干甚至几十上百台机器人同时执行工作,而其中至关重要的场景建模、路径规划、任务调度等算法均需要多设备协作执行,相比于依靠机器人之间通信的分布式计算,若将这些算法统一部署于该空间的边缘服务器上,可显著降低实现协作的复杂度.

最终,边缘计算将支撑机器人的持续学习和时空智能,为机器人4.0的实现提供坚实基础.

本文基于云边端融合的机器人系统,就机器人4.0的3项关键技术:持续学习、时空智能和边缘计算进行了初步的探讨,特别是边缘计算如何支持持续学习和时空智能.这些技术本身也在持续地提高中,所以它们并不一定是最终的解决方案,我们期望更多的研究人员加入我们,共同思考和探索如何实现机器人4.0,推动机器人和人工智能产业的发展.

[1] IDC, CAICT. Robot 3.0 new ecology in the age of artificial intelligence[EB/OL]. (2017-08-08)[2020-04-01]. http://www.caict.ac.cn/sytj/201708/t20170809_172905.htm (in Chinese)

(IDC, CAICT. 人工智能时代的机器人3.0新生态[EB/OL]. (2017-08-08)[2020-04-01]. http://www.caict.ac.cn/sytj/201708/t20170809_172905.htm)

[2] Intel, CloudMind, Siasun, Ecovacs. Robot 4.0 White Paper—Cloud-edge-end converged robotic systems and architecture[EB/OL]. (2019-06-27)[2020-04-01]. http://www.robotplaces.com/banner/3678.jhtml (in Chinese)

(英特尔, 达闼科技, 新松机器人, 科沃斯商用机器人. 机器人4.0白皮书——云-边-端融合的机器人系统和架构[EB/OL]. (2019-06-27)[2020-04-01]. http://www.robotplaces.com/banner/3678.jhtml)

[3] China Mobile, Huawei, Softbank, CloudMind, Skymind. GTI 5G and cloud robotics white paper[EB/OL]. (2017-06-21)[2020-04-01]. https://www.huawei.com/cn/industry-insights/outlook/mobile-broadband/xlabs/insights-whitepapers/GTI-5G-and-Cloud-Robotics-White-Paper (in Chinese)

(中国移动, 华为, 软银, 达闼科技, Skymind. GTI 5G与云化机器人白皮书[EB/OL]. (2017-06-21) [2020-04-01]. https://www.huawei.com/cn/industry-insights/outlook/mobile-broadband/xlabs/insights-whitepapers/GTI-5G-and-Cloud-Robotics-White-Paper)

[4] Feng Fan, Chan R H M, Shi Xuesong, et al. Challenges in task incremental learning for assistive robotics[J]. IEEE Access, 2019, 8: 3434-3441

[5] Wang Xiaofei, Han Yiwen, Leung V C M, et al. Convergence of edge computing and deep learning: A comprehensive survey[J]. IEEE Communications Surveys & Tutorials, 2020, 22(2): 869-904

[6] Hinton G,Vinyals O, Dean J. Distilling the knowledge in a neural network[C] //Proc of NIPS Deep Learning and Representation Learning Workshop. Cambridge, MA: MIT Press, 2015. arXiv:1503.02531, 2015

[7] She Qi, Feng Fan, Hao Xinyue, et al. OpenLORIS-Object: A robotic vision dataset and benchmark for lifelong deep learning[J]. ArXiv preprint: arXiv: 1911.06487, 2019

[8] Wang Zhengwei, She Qi, Ward T E. Generative adversarial networks in computer vision: A survey and taxonomy[J]. arXiv preprint arXiv:1906.01529, 2019

[9] Wang Zhengwei, She Qi, Smeaton A F, et al. Synthetic-neuroscore: Using a neuro-AI interface for evaluating generative adversarial networks[J]. Neurocomputing, 2020, 405: 26-36

[10] She Qi, Gao Yuan, Xu Kai, et al. Reduced-Rank linear dynamical systems[C] //Proc of the 32nd AAAI Conf on Artificial Intelligence (AAAI). Menlo Park, CA: AAAI Press, 2018: 4050-4057

[11] She Qi, Wu Anqi. Neural dynamics discovery via Gaussian process recurrent neural networks[C] //Proc of the 35th Conf on Uncertainty in Artificial Intelligence (UAI). Tel Aviv, Israel: AUAI Press, 2019: 159-170

[12] Kone![]()

![]() J, McMahan H B, Yu F X, et al. Federated learning: Strategies for improving communication efficiency[J]. arXiv preprint arXiv:1610.05492, 2016

J, McMahan H B, Yu F X, et al. Federated learning: Strategies for improving communication efficiency[J]. arXiv preprint arXiv:1610.05492, 2016

[13] Marvin L M. The emotion machine: Commonsense thinking, artificial intelligence, and the future of the human mind paperback[J/OL]. The Journal of Personal Cyberconsciousness, 2008, 3(3). [2020-04-01]. https://www.terasemjournals.com/PCJournal/PC0303/mm1.html

[14] Intel Labs China. Adaptive Human Robot Interaction (AHRI) SDK 2.0[EB/OL]. (2019-06-29) [2020-04-01]. http://www.robotplaces.com/banner/3679.jhtml

[15] Guo Ping, Zhang Lidan, Cao Lu, et al. Customized object recognition and segmentation by one shot learning with human robot interaction[C] //Proc of 2019 Int Conf on Robotics and Automation (ICRA). Montreal, QC, Canada, 2019: 4356-4361

[16] Shi Xuesong, Cao Lu, Wang Dawei, et al. HERO: Accelerating autonomous robotic tasks with FPGA[C] //Proc of 2018 IEEE/RSJ Int Conf on Intelligent Robots and Systems (IROS). Piscataway, NJ: IEEE, 2018: 7766-7772

[17] The Operstack Foundation. Kata Containers-The speed of containers, the security of VMs[EB/OL]. 2017 [2020-04-01]. https://katacontainers.io/

[18] Neta Z, Jacob G, Zlotnik L, et al. Neural network Distiller: A Python package for DNN compression research[J]. arXiv preprint arXiv:1910.12232, 2019

[19] Surat T, McDanel B, Kung H T. BranchyNet: Fast inference via early exiting from deep neural networks[C] //Proc of the 23rd Int Conf on Pattern Recognition (ICPR 2016). Cancún, Mexico: IEEE, 2016: 2464-2469

[20] Teerapittayanon S, McDanel B, Kung H T. Distributed deep neural networks over the cloud, the edge and end devices[C] //Proc of the 37th Int Conf on Distributed Computing Systems (ICDCS 2017). Atlanta, GA: IEEE, 2017: 328-339

[21] Guo Peizhen, Hu Bo, Li Rui, et al FoggyCache: Cross-device approximate computation reuse[C] //Proc of the 24th Annual Int Conf on Mobile Computing and Networking 2018 (MobiCom’18). New York: ACM, 2018: 19-34

[22] Mathur A, Lane N D, Bhattacharya S, et al. DeepEye: Resource efficient local execution of multiple deep vision models using wearable commodity hardware[C] //Proc of ACM Mobisys. New York: ACM, 2017: 68-81

[23] Fang Biyi, Zeng Xiao, Zhang Mi. NestDNN: Resource-aware multi-tenant on-device deep learning for continuous mobile vision[C] //Proc of the 24th Annual Int Conf on Mobile Computing and Networking 2018 (MobiCom’18). New York: ACM, 2018: 115-127

[24] Narayanan D, Santhanam K, Phanishayee A, et al. Accelerating deep learning workloads through efficient multi-model execution[C] //Proc of Workshop on Systems for Machine Learning. Cambridge, MA: MIT Press, 2018 [2020-04-01]. https://cs.stanford.edu/~matei/papers/2018/mlsys_hivemind.pdf

Wang Zhigang, born in 1978. PhD, research scientist of Intel Labs China. Member of CCF. His main research interests include spatial-temporal intelligence for robotics, hybrid AI systems based on statistical symbolic methods and system optimization.

symbolic methods and system optimization.

Wang Haitao, born in 1978. Master, cloud software engineer of Intel Asia Pacific R&D. Member of CCF. His main research interests include edge computing, hardware software codesign and workload characterization and optimization on edge.

She Qi, research scientist of Intel Labs China. He obtained his PhD degree in machine learning and neural computation at the City University of Hong Kong. His main research interests include statistical machine learning, deep learning with applications in computer robotic vision.

robotic vision.

Shi Xuesong, PhD, research scientist of Intel Labs China. Member of CCF. His main research interests include robotic vision, 3D scene understanding and heterogeneous computing.

Zhang Yimin, born in 1972. PhD, chief scientist principal engineer of Intel Labs China. Distinguished member of CCF. His main research interests include continual

principal engineer of Intel Labs China. Distinguished member of CCF. His main research interests include continual lifelong learning for robotics, computer vision, hybrid AI systems based on statistical

lifelong learning for robotics, computer vision, hybrid AI systems based on statistical symbolic methods and workload characterization on computer architecture.

symbolic methods and workload characterization on computer architecture.