虽同样采用了服务器端与客户端配合的训练模式,作为近年来研究热点的联邦学习(federated learning)[1-2]与分布式学习还是存在较大不同,这些不同主要包括4个方面:1)参数服务器收集客户端的本地模型来训练全局模型,而不是直接训练每个客户端的数据;2)客户端训练数据分布是异构的;3)参数服务器无法控制客户端的训练过程;4)客户端参与训练存在不确定性.随着隐私法规——通用数据保护条例(GDPR)的颁布以及社会各界对信息安全的重视,联邦学习因为它出色的隐私保护能力而受到人们越来越多的关注、信任和应用.

联邦学习最早的聚合算法是由谷歌提出的FedAvg[2],而如果训练过程中存在拜占庭客户端时,基础算法FedAvg容易受到攻击.在联邦学习领域,拜占庭客户机主要有2个目的:1)破坏训练过程从而防止全局模型收敛,这称为阻碍收敛攻击[3](即非定向攻击);2)在保证全局模型收敛的基础上,诱使全局模型对攻击者选择的子任务进行错误分类,这称为后门攻击[3](即定向攻击).拜占庭式客户端可以使用数据投毒攻击来破坏客户端的本地训练数据,或者使用模型投毒来篡改客户端的更新模型.比如文献[4]提出的PGD-edge攻击首先使用数据投毒攻击将原本的客户端数据集与其他数据集混合,然后在本地训练后利用模型投毒攻击将模型参数压缩到隐蔽的区域.

目前研究提出的拜占庭鲁棒聚合算法大多数都关注于模型的参数上.例如,Krum[5]每轮计算客户端模型之间的欧几里得距离,并选择与其他模型距离最小者作为全局模型,如果攻击者使用隐藏技术将异常模型的参数压缩至正常范围时,防御机制将无法检测.FLTrust[6]能够有效抵御更大比例的攻击,但是它需要参数服务器拥有一小批训练数据,这一要求在金融和医疗[7]等领域是难以实现的.

与之前检测模型参数的拜占庭鲁棒聚合算法不同,本文算法关注Softmax层的输出.实验证明,当拜占庭客户端使用PGD(projected gradient descent)攻击时,Softmax层的输出能更有效识别出拜占庭客户端模型,由于参数服务器在许多应用场景中都没有数据集,因此实验生成一个元素值为1的矩阵(本文算法只需要利用一个相同的数据来获取客户端模型的Softmax层概率分布,因此对数据本身没有要求,为了操作简单,本文实验使用一个全1矩阵作为数据)用于检测联邦学习中的异常模型.在收集客户端的模型后,参数服务器通过矩阵映射模型的更新部分来获取模型的Softmax层概率分布,在每轮更新中,参数服务器将聚合分布彼此接近的客户端模型.本文选择top-k个相互距离小于均值的模型进行聚合,其中k是一个不固定的参数.

本文实验部分通过CIFAR-10[8],EMNIST[9]两个数据集证明本文聚合算法能抵御全部最新的攻击.随后与先前研究提出的拜占庭鲁棒聚合算法进行比较,即Krum,Multi-Krum[5],NDC[10],RFA[11]和RSA[12],并实施多种阻碍收敛攻击和后门攻击(包括符号翻转攻击(sign-flipping attacks)[12]、同值攻击(same-value attacks)[12]、黑盒边缘攻击(black-box edge-case attacks)[4]、PGD边缘攻击(PGD edge-case attacks)[4]和PGDMR边缘攻击(PGD edge-case attacks with model replacement)[4].实验结果表明:在上面介绍的各类攻击下,本文提出的算法其准确率接近FedAvg*(即不受攻击时的FedAvg模型),并且在保真性、鲁棒性方面比目前最先进的聚合算法更优.最后本文在文献[6,13]提出的自适应攻击框架基础上提出针对本文算法的自适应攻击并进行相应测试,结果表明本文算法在EMNIST数据集上可以防御30%的拜占庭客户端,在CIFAR-10数据集上可以防御45%的拜占庭客户端.

本文的主要贡献包括3个方面:

1) 提出了一种基于矩阵映射的抗攻击算法,通过检查Softmax层概率分布来判断客户端模型是否异常,实验表明,与检查模型参数相比,本文算法更有效;

2) 对于拜占庭攻击,本文算法提高了拜占庭客户端容忍率,且保持全局模型准确率与FedAvg*接近;

3) 根据文献[13]的自适应攻击框架设计了针对本文算法的自适应攻击,并实验验证了本文算法在自适应攻击下具备一定的防御能力.

1 研究背景

1.1 联邦学习

在联邦学习中,多个客户端通过非独立同分布的本地数据集共同训练全局模型,理想情况下优化模型为

(1)

其中,N是客户数量, ψi是客户的权重,并且![]() 客户端目标函数Fi(·)定义为

客户端目标函数Fi(·)定义为

Fi(w)

![]()

(2)

其中,ζ(·,·)是用户指定的损失函数,且客户端i持有|Di|个数据xi,1,xi,2,…,xi,|Di|.

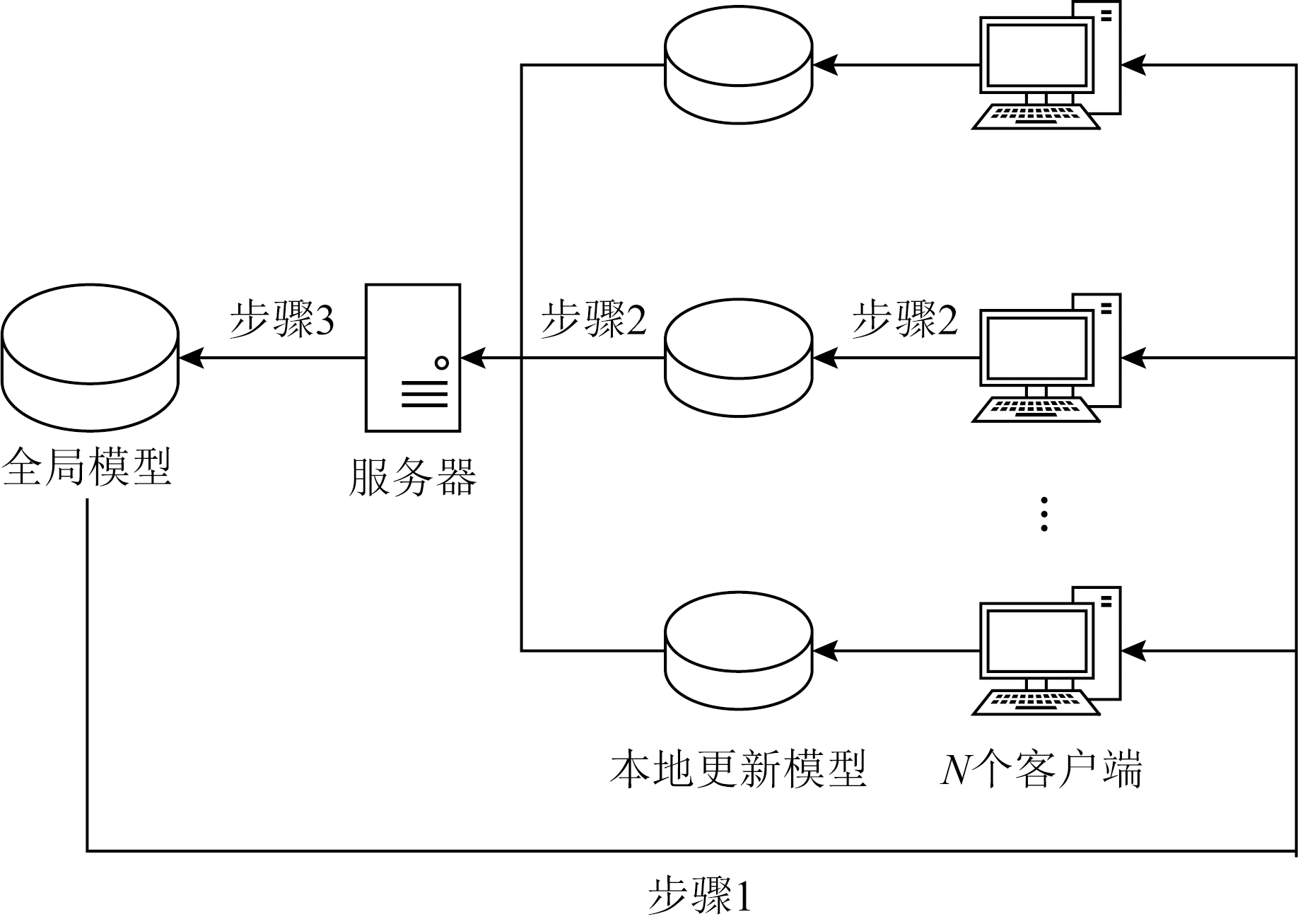

在一轮更新中,联邦学习可以大致分为3个步骤(如图1所示):

1) 参数服务器将聚合的全局模型(第一次迭代时为初始模型)发送给客户端;

2) 客户端通过本地训练更新模型,并将新模型返回给参数服务器;

3) 参数服务器收集部分客户端模型,并将其聚合为下一次迭代的全局模型.

从图1中不难发现,步骤3在进行数据交互时有被其他客户端攻击的风险,因此,以下所有关于方法的定义都针对步骤3.

Fig.1 Illustration of three steps in one iteration of federated learning

图1 联邦学习的一轮更新中的3个步骤

图1中有N个客户端(例如智能手机或边缘设备)和参数服务器(例如Google或Amazon之类的服务提供商),每个客户端具有不同的数据类别和数量.

常见的6种聚合方式为:

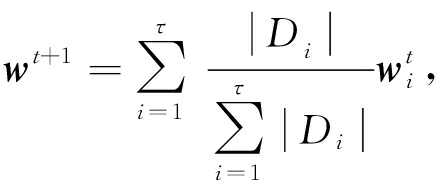

1) FedAvg. FedAvg根据权重聚合收集到的客户端模型,而不考虑拜占庭客户端.通常情况下,客户在本地训练中使用的数据越多,更新后的模型质量越高,聚合时权重就越大,全局模型的更新定义为

(3)

其中,|Di|表示客户i的训练数据数量,![]() 表示第t迭代中客户端i更新后的模型.

表示第t迭代中客户端i更新后的模型.

2) Krum[5]. Krum假设参数服务器在每次迭代中掌握拜占庭客户端的数量信息,聚合时仅选择一个客户端模型的更新u*,作为全局模型的更新.u*的选择策略为

(4)

(5)

其中,Ωj,τ-f-2是τ-f-2个距离模型j最近的模型更新的集合,其中距离使用欧几里德距离.

3) Multi-Krum[5]. Multi-Krum是Krum的变体,它收集τ-f-2个距离最近的客户端的模型更新,并将它们聚合进行全局模型的更新.

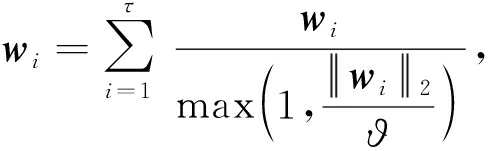

4) NDC[10]. NDC裁剪掉模型参数中大于阈值的部分,从而削弱拜占庭攻击的效果.客户端模型的裁剪策略为

(6)

与文献[4]中实验一致,本文实验设置ϑ=2.

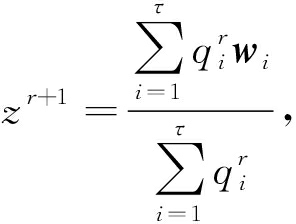

5) RFA[11]. RFA使用平滑的Weiszfeld算法计算收集到的客户端模型参数的加权几何中值,作为全局模型的参数,Weiszfeld算法的某一轮次计算为

(7)

式(7)中,a∪b表示:当b≤a时,![]() 当b>a时,a∪b=b.

当b>a时,a∪b=b.

(8)

其中,![]() 是第r轮迭代中的几何中心,与文献[14]保持一致,本次实验设置平滑因子v=0.1,容错阈值ε=10-5,最大迭代次数R=500.

是第r轮迭代中的几何中心,与文献[14]保持一致,本次实验设置平滑因子v=0.1,容错阈值ε=10-5,最大迭代次数R=500.

6) RSA[12].为了削弱拜占庭攻击的效果,RSA在收集客户端模型之后,仅采用模型参数的方向,而不采用模型参数的大小.因此客户端模型的所有参数都被限制在一个边界内,某一轮全局模型的更新策略为

(9)

其中,当x>0时Sign(x)=1;当x<0时Sign(x)=-1;当x=0时Sign(x)为[-1,1]内的任意值.设置RSA的学习率βr=5×10-5×0.998t.

1.2 联邦学习的投毒攻击

投毒攻击是指在训练数据中掺入毒数据或篡改模型参数,从而破坏机器学习的训练结果.在集中式学习中,典型的投毒攻击是数据投毒攻击[14-27].例如,Shafahi等人[23]篡改CIFAR-10中一部分青蛙图像的标签来训练模型,使得最终模型无法正确地对这些图像进行分类.除了数据投毒攻击外,联邦学习还遭受模型投毒攻击[4,12,28-31],这种投毒攻击相比于前者对机器学习的破坏性更强.

从攻击目的分析,可以将投毒攻击分为阻碍收敛攻击[3,6,12,30-31]和后门攻击[4,28-29,32].目前最先进的具有普适性的阻碍收敛攻击是符号翻转攻击和同值攻击,这2种攻击的核心都是将模型参数篡改为非正常值,从而破坏全局模型的最终精度.联邦学习中的第1种后门攻击是语义后门攻击[13],它篡改一些数据的标签,并将训练好的后门模型参数扩大特定的倍数来达到覆盖其他模型的效果.由于被放大的毒模型很容易被检测到,目前大多数的拜占庭鲁棒聚合算法可以减轻这种威胁.最先进的后门攻击是边缘后门攻击[4],它诱导模型对本能够正确分类但在训练数据中很少出现的数据进行错误分类.

本文1.1节中介绍了6种先进的拜占庭鲁棒聚合算法,可以分为2类:有副作用算法和无副作用算法.有副作用算法(例如NDC)通过对客户端模型进行裁剪、压缩或在毒模型与正常模型之间寻找折中模型来削弱毒模型的效果.尽管有副作用算法减轻了毒模型的负面影响,但正常模型也受到惩罚.无副作用算法(例如Multi-Krum)试图找到毒模型并排除它们,因此它们没有副作用.

2 模型假设

1) 威胁模型.本文参考文献[6,13]对拜占庭客户做出5方面假设:①拜占庭客户可以获得上一轮的全局模型;②拜占庭客户可以任意篡改本地数据和本地更新的模型;③拜占庭客户可以自由设置本地训练过程中的超参数,例如学习率和本地训练轮数;④拜占庭客户可以选择性地参与每一轮全局模型的更新;⑤参数服务器端每轮选择的客户中,拜占庭客户数量少于50%.

2) 防御目标.本文从保真性、鲁棒性和高效性3个方面来评估本文聚合算法.

① 保真性.在没有拜占庭攻击时,本文提出的聚合算法相比于FedAvg*不会牺牲性能.

② 鲁棒性.在拜占庭攻击下,本文聚合算法具有与FedAvg*接近的性能.

③ 高效性.相比于先前的聚合算法,本文聚合算法将检测毒模型的计算成本大幅度降低.

3) 防御方的能力.假设参数服务器是唯一的防御方,有3方面假设:①参数服务器无权访问客户端本地训练数据;②在每次迭代中,参数服务器都可以访问收集到的客户端的本地模型[6,13];③每轮参数服务器对拜占庭客户的数量不可知[6,10-12].

3 本文聚合算法

3.1 算法概述

本文通过矩阵对客户端模型进行检测以获取模型“可视化图像”.通常,正常模型们将显示出相似的“图像”,而毒模型将显示出异常的“图像”,算法通过比较模型“可视化图像”的相似性来判断客户端模型是否异常.

3.2 算法详细步骤

本模型的聚合方式包括4个部分:拆分(通过式(10)拆分收集的模型以获取模型更新部分)、映射(通过矩阵映射模型的更新部分来获取模型的概率分布)、检测(通过l2-范数计算每个概率分布的距离,从而得到模型的异常程度,并标记异常模型)和聚合(排除标记的异常模型,聚合剩余的正常模型).

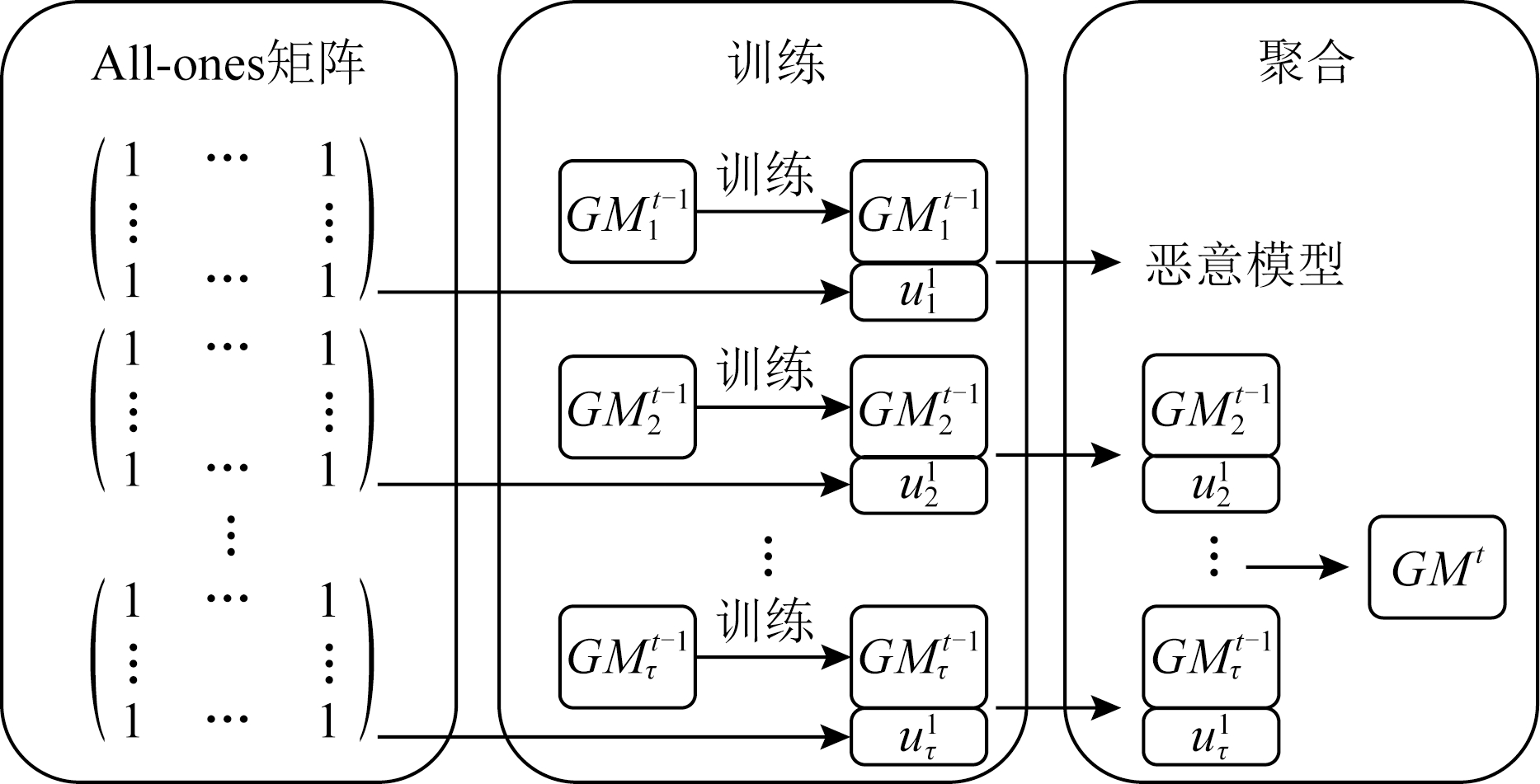

图2描述了本文聚合算法的具体流程:

Fig.2 The procedure of our aggregation algorithm

图2 本文聚合算法流程

如图2所示,收到第t-1轮的全局模型![]() 之后,τ个客户端(其中f个是拜占庭客户端.这里,我们设置f=1)共同训练全局模型 GMt. 其中

之后,τ个客户端(其中f个是拜占庭客户端.这里,我们设置f=1)共同训练全局模型 GMt. 其中![]() 表示客户端i在第t轮本地模型的更新部分.对于每个

表示客户端i在第t轮本地模型的更新部分.对于每个![]() 参数服务器通过矩阵将其映射以获得概率分布. 然后,参数服务器排除概率分布异常的客户端模型并聚合剩余的模型.

参数服务器通过矩阵将其映射以获得概率分布. 然后,参数服务器排除概率分布异常的客户端模型并聚合剩余的模型.

1) 拆分.在每一轮全局模型的更新中,客户端以前一轮的全局模型作为初始模型训练自己的本地模型.然后,参数服务器收集一定数量的客户端模型用于更新全局模型.考虑到在拜占庭攻击下,模型的异常集中在其更新的部分;并且随着模型学习轮数的增加,更新的部分将在模型中占据越来越小的比例.所以,如果直接检测收集的客户端模型,将难以检测到异常.因此,参数服务器拆分收集到的客户端模型,从而获取用于映射和检测的更新部分.

2) 映射.考虑到参数服务器没有数据集,本文算法根据训练数据的大小生成一个矩阵,该矩阵用于提取模型特征.在每一轮全局模型的更新中,参数服务器将矩阵注入到每一个拆分后的客户端模型中(即以模型更新部分为权重的网络),以映射模型的特征.图3显示了在投毒攻击下某一轮中毒模型与正常模型之间的特征差异.映射过程定义为

(10)

其中,![]() 表示第t轮时客户端i模型的概率分布,dao是元素值为1的矩阵.而函数Network(·,·)表示输入数据并获得输出层概率分布.

表示第t轮时客户端i模型的概率分布,dao是元素值为1的矩阵.而函数Network(·,·)表示输入数据并获得输出层概率分布.

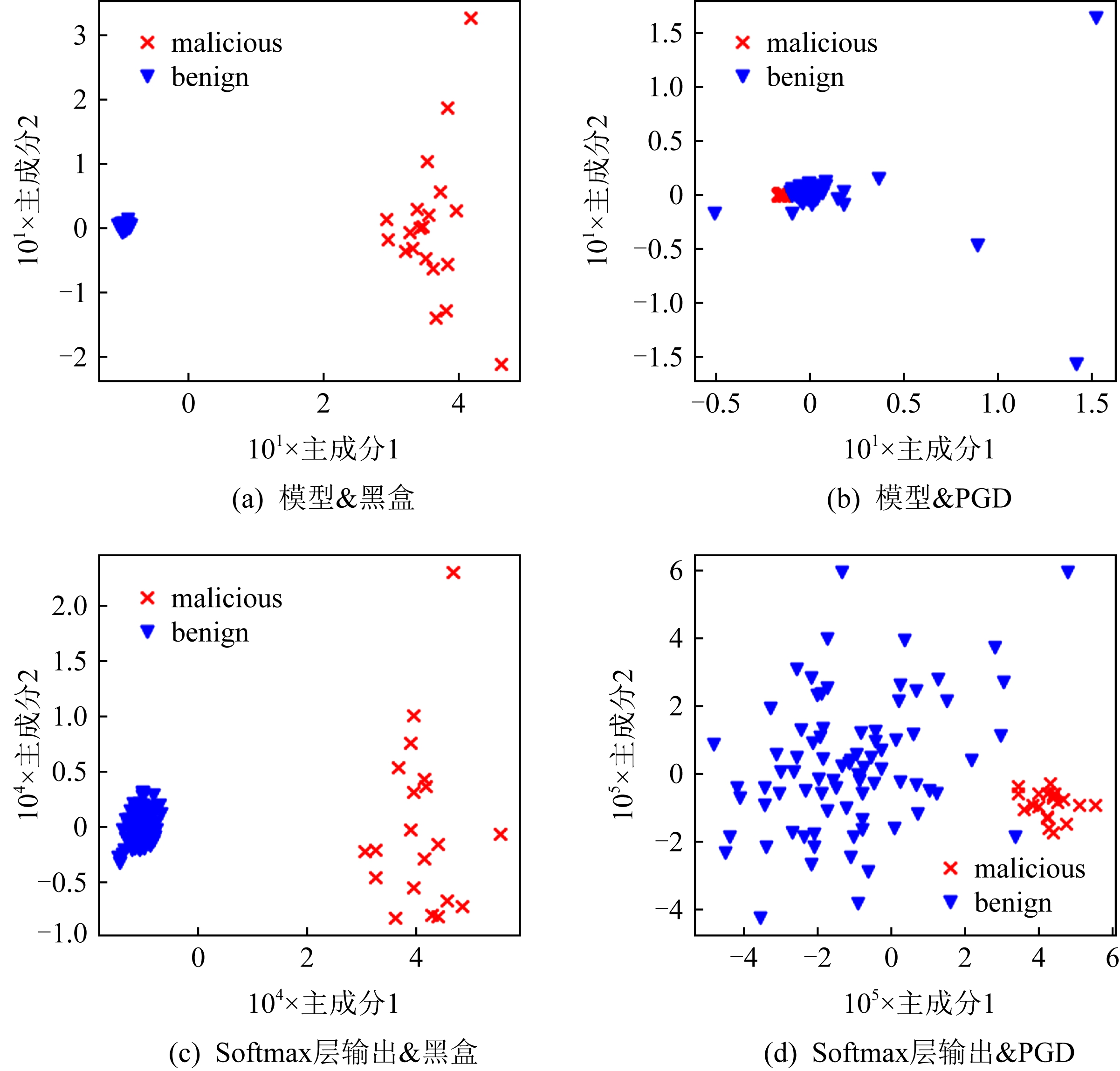

相比于观察模型,观察Softmax层概率分布能更有效区分拜占庭客户端的模型和正常客户端的模型,如图3(a)(c)所示,在黑盒攻击下,观察模型和观察Softmax层概率分布都能有效区分拜占庭客户端模型和正常客户端模型,而在PGD攻击下(相对黑盒攻击更隐蔽的一种攻击),拜占庭客户端模型和正常客户端模型在空间中已经难以区分(图3(b)),即通过计算客户端模型之间的距离已无法发现异常,而此时拜占庭客户端模型的Softmax层概率分布和正常客户端模型的Softmax层概率分布在空间中仍然有较为清晰的分界(图3(d)),从而通过计算距离,本文算法仍可以有效区分拜占庭客户端模型和正常客户端模型.

3) 检测.矩阵映射之后,参数服务器首先排除概率分布值明显异常(例如值为inf和nan,inf表示无穷大,nan表示非数字)的客户端模型.然后,参数服务器通过计算剩余模型相互之间的欧几里得距离求得哪些模型为异常模型.出于经验,我们保留异常分数低于均值的客户端模型作为最终聚合所用的模型,该过程定义为

Preserve{w1|ASi<Thr(AS1,AS2,…,ASτ′)}τ″,

(11)

其中,ASi表示客户端i的模型异常分数,τ″表示第2轮筛选后剩余模型的数量,阈值函数Thr(AS1,AS2,…,ASτ′)在本文中定义为![]()

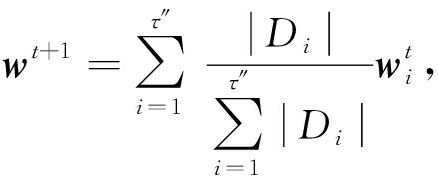

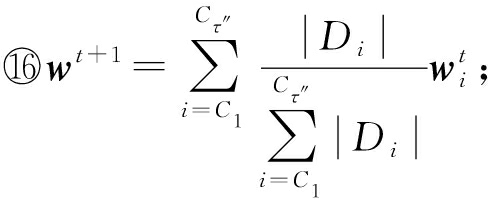

4) 聚合.参数服务器通过重新计算的权重来聚合保留的τ″个模型:

Fig.3 Dimension reduction analysis of Softmax layer output under different attacks

图3 在不同攻击下Softmax层输出的降维分析

(12)

其中,wt+1是第t+1次迭代聚合的全局模型,|Di|是客户端i的数据量.

算法1、算法2分别介绍了正常客户端和拜占庭客户端的训练算法,算法3介绍了在本文聚合算法下联邦学习其中一轮全局模型的更新过程.具体地,算法3分为4个步骤:1)在收到一定数量的客户端模型之后,参数服务器端拆分收集到的模型以获取更新部分,并注入矩阵得到模型的Softmax概率分布;2)根据客户端模型的概率分布,参数服务器端计算其异常分数AS;3)参数服务器端剔除AS超出平均值的客户端模型;4)重新计算权重,并聚合剩余的客户端模型.

算法1. BenignUpdate(w,D,b,ηt,Tl).

输入:初始模型w、 数据集D、批数量b、本地训练学习率ηt、 本地训练轮数Tl;

输出:正常模型wTl,B.

① w0,0=w;

② for i=1,2,…,Tldo

③ for j=1,2,…,B do /*假设数据集D有B个batch*/

④ wr,j=wr,j-1-ηt![]()

![]()

⑤ end for

⑥ end for

⑦ return wTl,B.

算法1中,wTl,B表示以Tl×B次迭代的客户端模型,Tl是本地训练轮数,B是本地数据集的批量.

算法2. MaliciousUpdate(w,Dpoi,b,ηt,Tl).

输入:初始模型w、毒数据集Dpoi、批数量b、 本地训练学习率ηt、 本地训练轮数Tl;

输出:毒模型![]()

① w0,0=w;

② if 使用数据投毒攻击

③ ![]()

④ else if 使用模型投毒攻击

⑤ wTl,B=BenignUpdate(w,Dpoi,b,ηt,Tl);

⑥![]() =Manipulate(wTl,B);

=Manipulate(wTl,B);

/*函数Manipulate( )表示拜占庭客户端对模型参数的操作*/

⑦ else /*一些拜占庭客户端同时利用数据投毒攻击和模型投毒攻击(例如PGD-edge攻击)*/

⑧ ![]()

⑨![]()

⑩ end if

end if

end if

算法2中,![]() 是指以Tl×B次迭代后生成的毒模型.

是指以Tl×B次迭代后生成的毒模型.

算法3. AggregationAlg(w,D,b,ηt,Tl,dao).

输入:初始模型w、 数据集D、批数量b、本地训练学习率ηt、 本地训练轮数Tl、元素值为1的矩阵dao;

输出:最终全局模型wT.

1) 客户端:

/*接收上一轮的全局模型wt-1*/

① for i=C1,C2,…,Cτ并行处理

② if C1是正常客户端

③ ![]()

④ else

⑤ ![]()

⑥ 发送![]() 至参数服务器端;

至参数服务器端;

⑦ end if

⑧ end for

2) 参数服务器端:

/*步骤1.通过矩阵映射模型的更新模型,获得Softmax层的输出值Oi,i=1,2,…,τ.Network(·,·)函数返回Softmax层的输出值.*/

① for i=C1,C2,…,Cτdo

②![]()

③![]()

④ if 向量Oi存在异常值

⑤ 在本轮中弃用客户端Ci的模型;

⑥ end if

⑦ end for

/*步骤2.计算客户端模型的异常分数ASCτ*/

⑧ for i=C1,C2,…,Cτ′ do

⑨![]()

⑩ end for

/*步骤3.移除ASs超过阈值的客户端模型*/

for i=C1,C2,…,Cτ′ do

for i=C1,C2,…,Cτ′ do

if ASCi>Thr(ASC1,ASC2,…,ASCτ′)

if ASCi>Thr(ASC1,ASC2,…,ASCτ′)

在本轮中弃用客户端Ci的模型;

在本轮中弃用客户端Ci的模型;

end if

end if

end for

end for

/*步骤4.聚合得到全局模型*/

发送wt+1到客户端.

发送wt+1到客户端.

4 自适应攻击

当拜占庭式客户端掌握联邦学习系统使用的聚合算法的信息时,攻击者可以设计一种针对此聚合算法的攻击手段绕过防御措施,此类攻击称为自适应攻击.与通用攻击(例如标志翻转和黑盒边缘)相比,自适应攻击(例如针对NDC的PGD-edge攻击)在面对其对应的聚合算法时攻击效果更强.因为自适应攻击是假设拜占庭客户端知道参数服务器使用的聚合算法,并针对此聚合算法的弱点做出的专门攻击.要设计出自适应攻击,则需要掌握更多关于系统的信息.为了进一步测试本文聚合算法的鲁棒性,我们根据文献[6,13]提出的通用框架设计了一种针对本文聚合算法的自适应攻击,该框架曾成功运用于攻击Krum,Trimmed Mean和Median[33].

4.1 通用自适应攻击框架

文献[6,13]提出的自适应攻击框架适用于所有聚合算法.在自适应攻击中,拜占庭式客户端之间相互勾结,在聚合算法检测不到的范围内,使得全局模型出现偏离.在模型的方向上,达到这一目的最有效的办法是找到全局模型更新的相反方向,然后将本地模型的更新修改为这个方向.除了方向,还需要考虑的是更新的幅度,因此,如何在检测范围外找到尽可能大的更新幅度至关重要,通常自适应攻击框架定义为:

(13)

其中,![]() 表示f个毒模型;s是全局模型的更新方向通过Sign(·)函数得到的结果向量;λ是使自适应攻击效果最大化的度量;A为聚合算法.

表示f个毒模型;s是全局模型的更新方向通过Sign(·)函数得到的结果向量;λ是使自适应攻击效果最大化的度量;A为聚合算法.

4.2 自适应攻击的威胁模型

假设所有拜占庭客户端都是相互合谋的,它们的“领导者”可以获取其他拜占庭客户端的模型并任意篡改.在收到全局模型后,这些拜占庭客户端通过本地数据对其进行训练,然后根据这些客户端模型形成的分布,“领导者”计算出一个合适的度量λ,使得篡改后的模型在能绕过检测的基础上最大化攻击效果.接着,“领导者”统一其他拜占庭客户端篡改模型为此模型,该威胁模型与文献[13]的不完全信息假设一致.

4.3 针对本文的自适应攻击算法

我们设置0≤λ<200,与文献[13]相同,我们使用二进制搜索来求解λ.f个拜占庭客户端首先用干净的本地数据训练出干净的模型,用矩阵映射以获得干净的Softmax概率分布.然后,以此分布为“真实”分布,基于上述自适应攻击框架修改模型参数.假设wf+1是拜占庭客户端模型的“领导者”,其他f-1个拜占庭客户端模型与其保持一致.修改前的f个模型的概率分布和修改后f个模型的概率分布形成新的分布.如果wf+1的AS小于2f个模型AS的均值,那么λ减少一半,否则增加一倍,直到ASf+1小于本文算法检测阈值为止.

4.4 关于对抗自适应攻击的经验分析

本节从经验角度分析本文聚合算法具有一定程度的防御自适应攻击能力的原因.

首先,当客户端本地数据分布是独立同分布时,模型间的参数分布是服从高斯分布的,此时假设一部分本地模型的分布可以代表所有客户端模型的分布是合理的.但当客户端本地数据分布是非独立同分布时,模型的分布是不规则的,此时再以拜占庭客户端的模型分布模拟真实分布是有偏差的,篡改后的模型是不能保证其隐蔽性的.

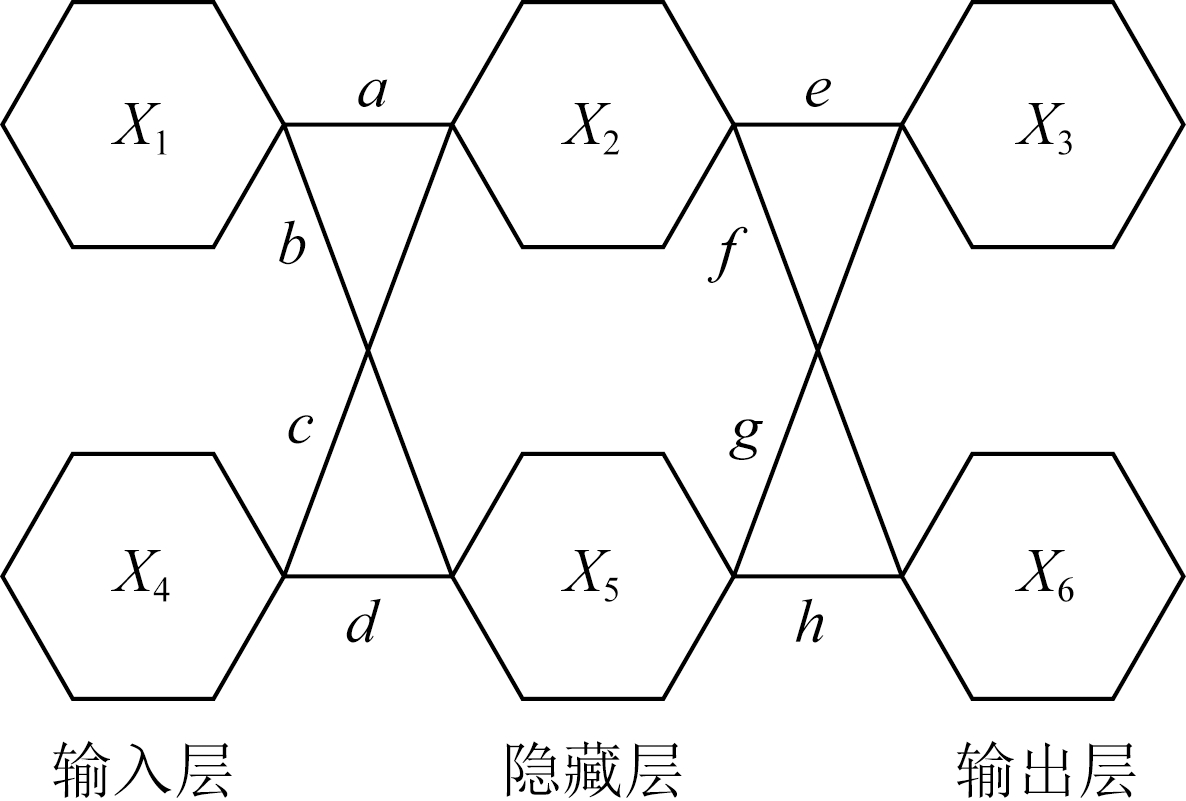

其次,在无副作用算法中,本文聚合算法对模型参数的约束比Krum和Multi-Krum更严格.如图4所示,我们举出一个如图4所示的抽象的神经网络来证明上述观点.神经网络包括一个输入层、一个隐藏层和一个输出层,每层包含2个神经元,不考虑每层中的偏置参数,a到h表示神经网络权重(更新部分),X1到X6表示输入数据后节点的输出值.对于计算模型之间欧氏距离的Krum和Multi-Krum,只要模型的欧氏距离不超过检测阈值,就可以灵活修改模型参数.在满足(a-a′)2+(b-b′)2+…+(h-h′)2≤φ的前提下,攻击者可以任意地修改网络参数a,b,…,h为a′,b′,…,h′.在本文聚合算法中,当X1=X2=1时,攻击者修改a,b,…,h为a′,b′,…,h′时,需要确保输出层![]() 由于传导至输出层之前,每个网络参数都是相互牵连的,所以攻击者无法大幅度修改一组参数来实现其目标.因此,尽管参数服务器端有时会聚合攻击者的模型,但是这些负面影响是可以被正常模型覆盖的.

由于传导至输出层之前,每个网络参数都是相互牵连的,所以攻击者无法大幅度修改一组参数来实现其目标.因此,尽管参数服务器端有时会聚合攻击者的模型,但是这些负面影响是可以被正常模型覆盖的.

Fig.4 A simple neural network

图4 一个简单的神经网络

5 实验评估

实验首先评估本文聚合算法的保真性和鲁棒性.我们将它与先前的6种聚合算法进行对比来证明本文聚合算法在真实联邦学习环境中,能够更好地防御各类投毒攻击;然后,我们对本文设计的自适应攻击进行评估来验证本文聚合算法具有对抗自适应攻击的能力;最后,我们理论分析了本文提到的6种聚合算法的时间复杂度并作对比,对比显示本文提出的聚合算法是效率最高的.

5.1 实验设置

1) 数据集

本文使用2个计算机视觉领域的数据集.对于每个数据集,我们通过Dirichlet分布[34]将训练数据不均等地分发给客户端,以模拟真实的联邦学习系统,分布χ~Dir(γ,N)中的参数γ越小,客户端本地数据的非独立同分布程度越高.

① CIFAR-10. CIFAR-10是一个彩色图像分类数据集,其中包含预定义的50 000个训练数据和10 000个测试数据.在CIFAR-10中,我们通过Dirichlet分布对数据进行分发.具体而言,CIFAR-10中,每个类有5 000个训练数据,通过分布χ~Dir(1.0,N)我们得到M个N维的Dirichlet分布.根据这M个分布,我们按数据类依次向N个客户分发训练数据.数据量达到平均值的客户端将停止接收数据.因此除了数据类别比例不同之外,客户端的数据量也可能不同.

② EMNIST. EMNIST数据集是从NIST数据库派生的一组手写字符数据,由6个子数据集组成,分别是By_Class,By_Merge,Balanced,Digits,Letters和MNIST.在EMNIST中,本实验选择Digits数据集,其中包含240 000个训练数据和40 000个测试数据.与CIFAR-10的处理一致,EMNIST根据分布χ~Dir(1.0,N)分发数据给客户端.

2) 投毒攻击

实验进行2类投毒攻击,包括阻碍收敛攻击(无针对性)和后门攻击(有针对性).对于阻碍收敛攻击,本实验使用符号翻转攻击和同值攻击;对于后门攻击,本实验使用黑盒边缘攻击、PGD边缘攻击和PGDMR边缘攻击.边缘攻击的设置与文献[4]相同,对于CIFAR-10,本实验收集西南航空公司飞机图像并将其标记为“卡车”作为毒数据供拜占庭客户端训练;对于EMNIST,本实验将Ardis的手写图像 “7”的标签改为“1”作为毒数据供拜占庭客户端训练.

① 符号翻转攻击.在符号翻转攻击中,拜占庭式客户端i首先训练出真实的本地模型wi,然后将其翻转为wi=-4×wi后提交给参数服务器.

② 同值攻击.在同值攻击中,拜占庭客户端将模型参数都修改为100并提交给参数服务器.

③ 黑盒边缘攻击.边缘后门攻击是联邦学习目前面临的未能应对的威胁.黑盒边缘攻击只添加毒数据至客户端的本地训练数据,而不篡改模型参数.攻击者篡改稀有数据的标签制作毒数据,并在混有干净数据和毒数据的数据集中训练出毒模型.对于黑盒设置,我们将20%的干净数据和80%的毒数据混合在一起作为拜占庭客户端的数据集.根据文献[4]的实验证明,这一混合比例下攻击效果最强.为了最大化边缘后门攻击的效果,本实验假设拜占庭客户参与每轮联邦学习的更新.

④ PGD边缘攻击.PGD是一种模型隐藏技术,它压缩毒模型的参数使得毒模型与正常模型有着相似的范数,以便攻击者可以成功绕过当前的鲁棒聚合算法.PGD边缘攻击将模型投影到以上一轮全局模型为球心、半径为δ的超球面上.与文献[4]一致,对于CIFAR-10,我们设置δ=2;对于EMNIST,我们设置δ=1.5.

⑤ PGDMR边缘攻击.模型替换技术(MR)由文献[13]首次提出.拜占庭客户端i以比例|D|/|Di|放大毒模型,再将其发送到参数服务器.参数服务器聚合之后的全局模型即为毒模型.但是这种简单的攻击方式很容易被一般的鲁棒聚合算法检测到.在PGDMR边缘攻击中,拜占庭客户端i首先基于黑盒边缘攻击进行PGD边缘攻击,然后计算替换

后模型![]() 最后将

最后将![]() 缩放到范数不大于δ,提交至参数服务器.

缩放到范数不大于δ,提交至参数服务器.

⑥ 自适应攻击.实验使用第4节中设计的自适应攻击.设置参数服务器在每轮更新中收集20个客户端模型,且分别假设其中5%~50%是拜占庭客户端模型.

3) 评估指标

对于阻碍收敛攻击,攻击者旨在降低模型在测试集上的整体准确率,所以本文使用全局模型的测试准确率来评估聚合算法的性能.如果某一聚合算法得到的全局模型测试准确率更高,则这一聚合算法在对抗阻碍收敛攻击时的鲁棒性更强.对于后门攻击,考虑2个指标来评估全局模型:主任务的测试准确率和后门任务的测试准确率.具体地,主任务的测试准确率是在整个测试集上的准确率,后门任务的测试准确率是在攻击者选择或制作的目标测试集上的准确率.如果某一聚合算法得到的全局模型在主任务上实现较高的测试准确率,而在后门任务上实现较低的测试准确率,则说明这一聚合算法在对抗后门攻击时的鲁棒性更强.

4) 系统设置

与文献[4]的设置一致.后门攻击中,对于CIFAR-10,我们总共设置200个客户端,每轮选取10个客户端模型用作全局模型的更新.对于EMNIST,我们总共设置3 383个客户端,每轮选取30个客户端模型用作全局模型的更新.对于阻碍收敛攻击,客户端总数不变,每轮选取20个客户端模型参与更新.

Fig.5 The performance of aggregation algorithms under no attack

图5 无攻击情况下各聚合算法的表现

全局模型:通过在不同的数据集上训练不同的网络以显示本文聚合算法的普适性.具体来说,本文分别针对CIFAR-10和EMNIST训练了VGG-9和LeNet.对于阻碍收敛攻击,实验从初始模型开始训练800轮;对于后门攻击,实验从预训练模型开始训练100轮.

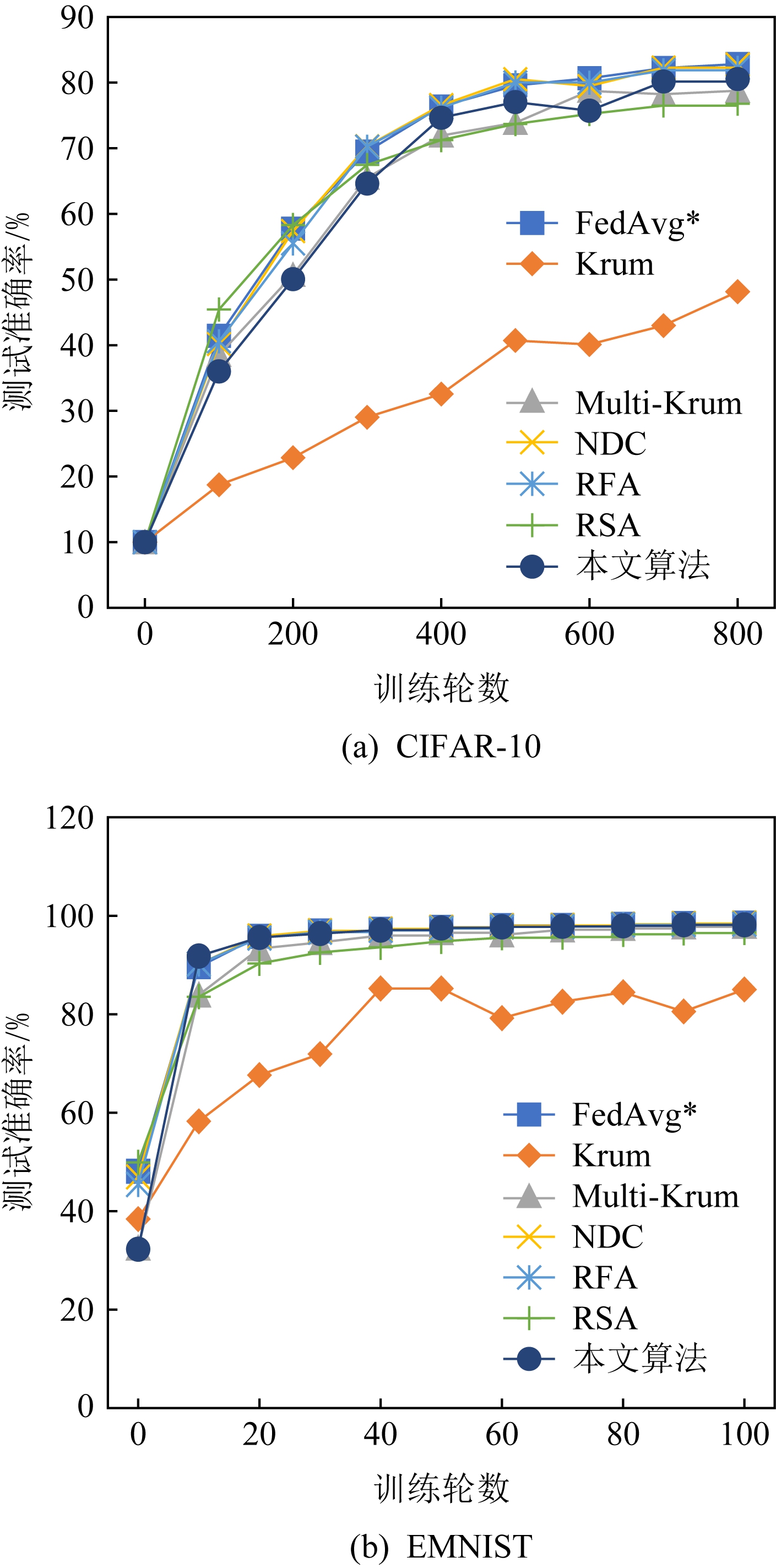

5.2 实验结果

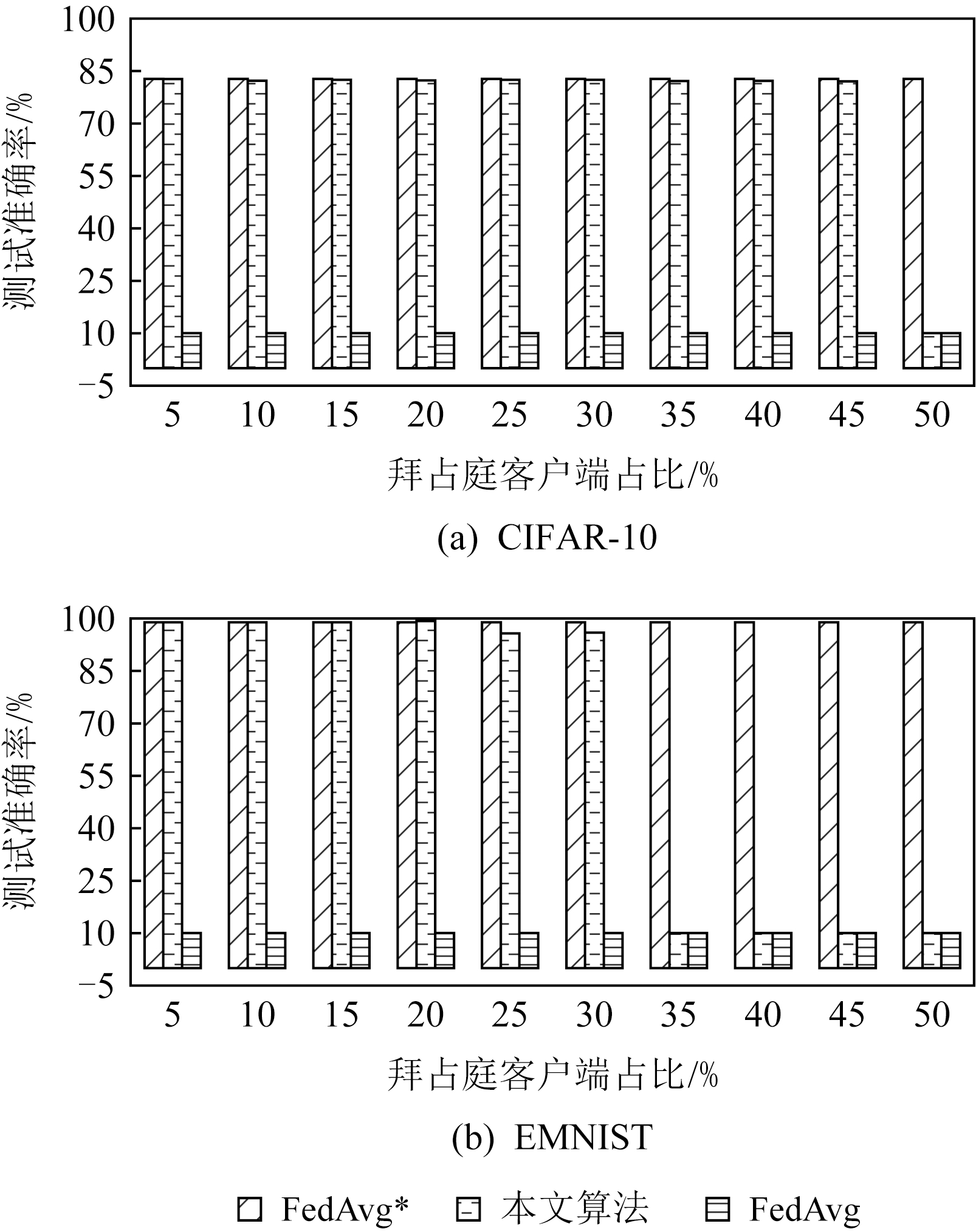

① 保真性.如图5所示,对于阻碍收敛攻击,本文聚合算法、Multi-Krum、NDC和RFA在没有拜占庭攻击的情况下都具有与基准算法FedAvg相近的性能.尽管RSA具有很快的收敛速度,但它只能收敛到模型的次优解.

对于后门攻击,不难看出除Krum之外的其他聚合算法的性能都可与FedAvg*接近.在没有攻击的情况下,训练过程可能会牺牲全局模型对数据中某些类的判别准确性来确保模型的整体准确性.(在文献[4]的实验设置下,EMNIST上的图像“7”具有较高的错误率).总而言之,本文提出的聚合算法在实验中所有场景下都具有较强的保真性.

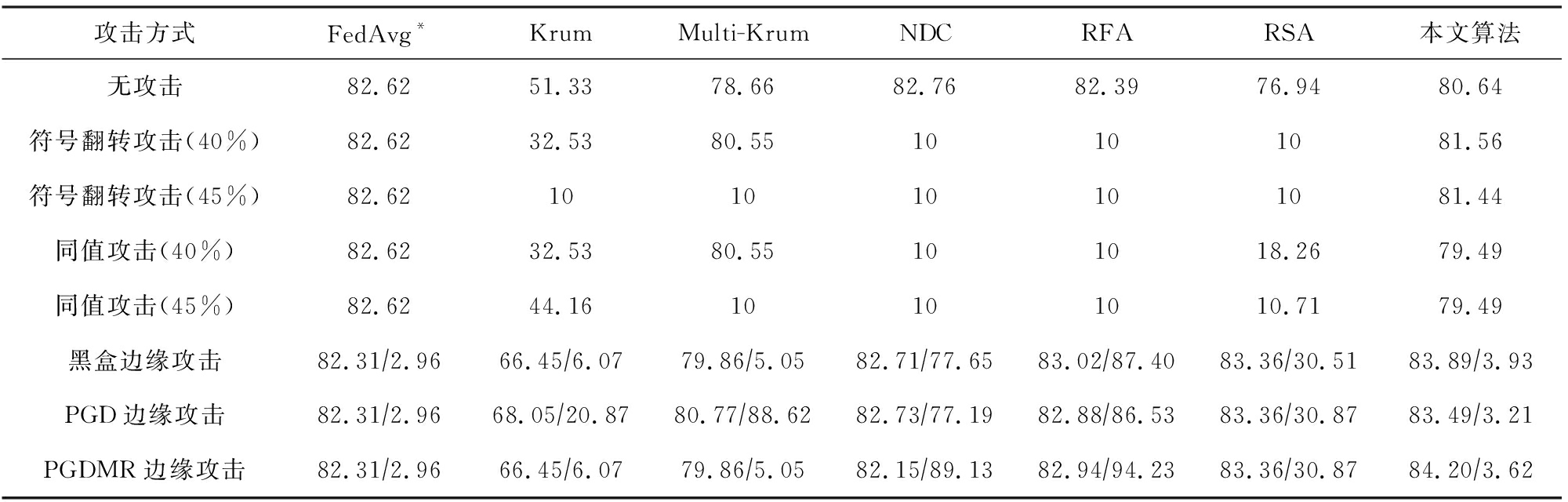

② 鲁棒性.对于阻碍收敛攻击,无论攻击类型和数据集如何,NDC和RFA都会防守失败.RSA在CIFAR-10上效果不佳,但在EMNIST上具有一定的防守能力,由此可推知RSA能够有效地处理简单的数据集和网络,但在复杂的数据集和网络中存在不足.Krum具有一定程度的鲁棒性,但是以牺牲FedAvg*的性能为前提.当拜占庭客户端占比40%时,只有Multi-Krum和本文聚合算法性能接近于FedAvg*.

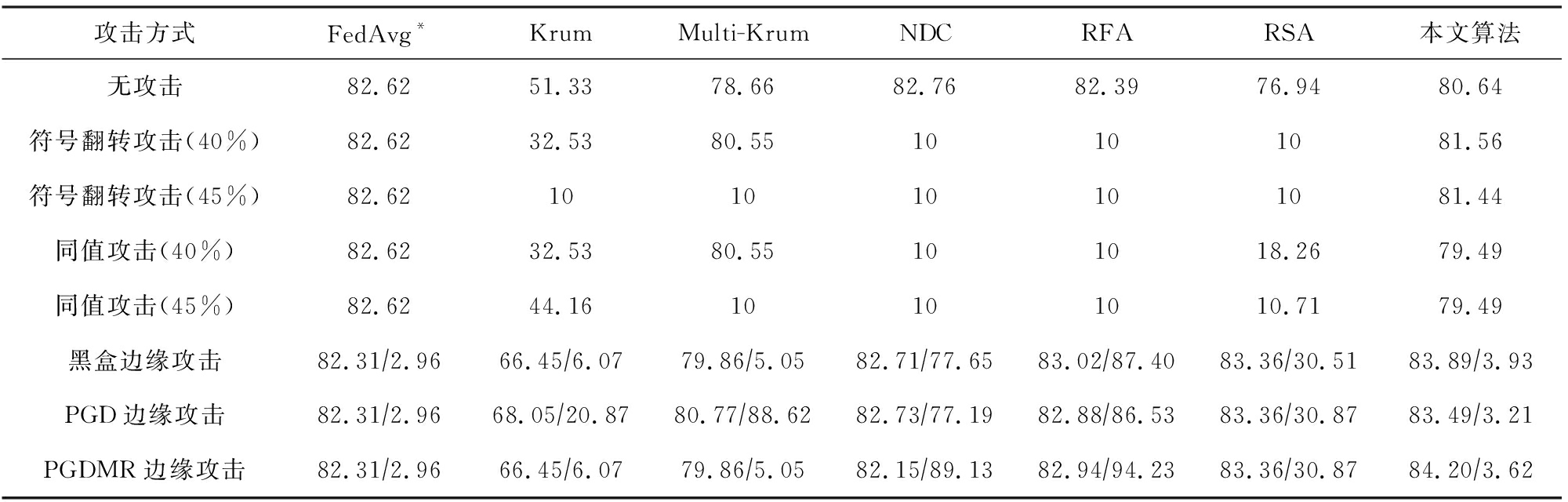

为了进一步比较Multi-Krum和本文聚合算法的鲁棒性,我们进行了渐进实验.从开始设置的拜占庭客户端占比40%提升至45%,这一占比更接近于威胁模型中假设的极端情况.表1和表2中数据显示,Multi-Krum在此极端攻击下失去了防御能力.而本文聚合算法仍然可以保持和FedAvg*相近的性能.后门攻击中.对于主任务,不论是在CIFAR-10,还是在EMNIST下,除了Krum的其他聚合算法都维持了主任务的测试准确率.

Table 1 Test Results of Aggregation Algorithms Under CIFAR-10

表1 CIFAR-10下各聚合算法测试结果

攻击方式FedAvg*KrumMulti-KrumNDCRFARSA本文算法无攻击82.6251.3378.6682.7682.3976.9480.64符号翻转攻击(40%)82.6232.5380.5510101081.56符号翻转攻击(45%)82.62101010101081.44同值攻击(40%)82.6232.5380.55101018.2679.49同值攻击(45%)82.6244.1610101010.7179.49黑盒边缘攻击82.31∕2.9666.45∕6.0779.86∕5.0582.71∕77.6583.02∕87.4083.36∕30.5183.89∕3.93PGD边缘攻击82.31∕2.9668.05∕20.8780.77∕88.6282.73∕77.1982.88∕86.5383.36∕30.8783.49∕3.21PGDMR边缘攻击82.31∕2.9666.45∕6.0779.86∕5.0582.15∕89.1382.94∕94.2383.36∕30.8784.20∕3.62

注:符号“/”前后数字表示主任务准确率和后门任务准确率.

Table 2 Test Results of Aggregation Algorithms Under EMNIST

表2 EMNIST下各聚合算法测试结果

攻击方式FedAvg*KrumMulti-KrumNDCRFARSA本文算法无攻击82.6251.3378.6682.7682.3976.9480.64符号翻转攻击(40%)82.6232.5380.5510101081.56符号翻转攻击(45%)82.62101010101081.44同值攻击(40%)82.6232.5380.55101018.2679.49同值攻击(45%)82.6244.1610101010.7179.49黑盒边缘攻击82.31∕2.9666.45∕6.0779.86∕5.0582.71∕77.6583.02∕87.4083.36∕30.5183.89∕3.93PGD边缘攻击82.31∕2.9668.05∕20.8780.77∕88.6282.73∕77.1982.88∕86.5383.36∕30.8783.49∕3.21PGDMR边缘攻击82.31∕2.9666.45∕6.0779.86∕5.0582.15∕89.1382.94∕94.2383.36∕30.8784.20∕3.62

注:符号“/”前后数字表示主任务准确率和后门任务准确率.

对于后门任务,不论是在CIFAR-10,还是在EMNIST下,只有本文聚合算法能够始终防守3种边缘后门攻击,使全局模型的性能始终接近FedAvg*.于是我们可以得出结论,本文聚合算法是目前唯一可以做到防守边缘后门攻击的鲁棒算法.

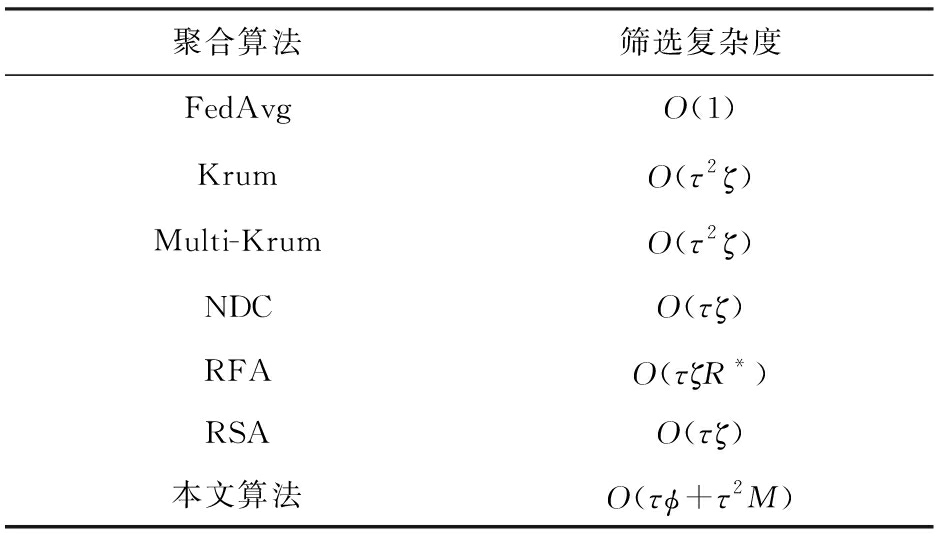

③ 高效性.如表3所示,其中ζ表示模型参数的数量,M表示标签类别的数量,τ表示每次迭代中收集的模型的数量,φ表示训练矩阵的时间.我们比较各个聚合算法的时间复杂度.参数服务器端使用FedAvg时不需要筛选收集的客户端模型,因此其筛选模型的时间复杂度为O(1),Krum和Multi-Krum计算τ个客户模型参数的相互距离,NDC和RSA对τ个模型的参数进行裁剪或正则化操作,RFA通过考虑客户模型的参数来找到多个模型的几何中心.总之,以上这些算法都需要计算ζ个模型参数.目前先进的深度学习模型具有成百上千万个参数(例如VGG-16具有1.38×108个参数),所以考虑模型参数的聚合算法面临较大的计算量.本次聚合算法的检测避开了模型参数的计算,而是考虑Softmax层概率分布,即M个输出值.并且,训练矩阵的时间φ以忽略不计,所以本文聚合算法筛选模型的时间复杂度O(τφ+τ2M)≈O(τ2M).在联邦学习中,参数服务器不会在一轮更新中收集太多的客户端模型(通常为50~5 000[35])以确保效率.由此可以得出结论,与其他方法,如Krum,Multi-Krum,NDC,RFA和RSA算法相比,本文聚合算法的效率提高了成百上千万倍.

Table 3 Time Complexity of Aggregation Algorithms

表3 聚合算法的时间复杂度

聚合算法筛选复杂度FedAvgO(1)KrumO(τ2ζ)Multi-KrumO(τ2ζ)NDCO(τζ)RFAO(τζR*)RSAO(τζ)本文算法O(τϕ+τ2M)

注:ζ表示模型参数的数量,M表示标签类别的数量,τ表示每次迭代中收集的模型的数量,φ表示训练矩阵的时间.

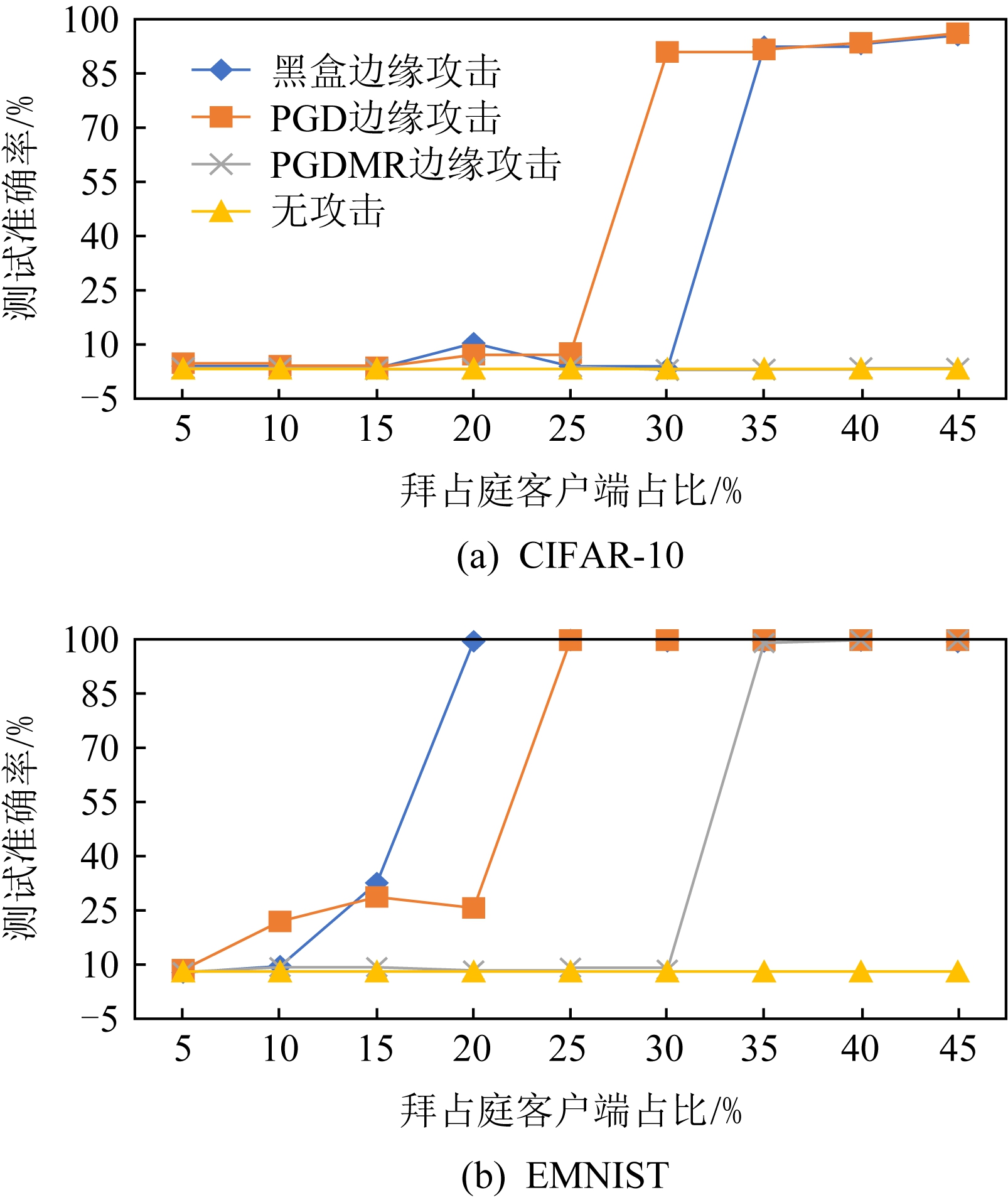

⑤ 自适应攻击下的防御能力.图6是本文聚合算法与其他聚合算法在不同比例的拜占庭客户端下的表现.在自适应攻击下,分别在CIFAR-10上运行800轮,在EMNIST上运行100轮.由图6发现,对于数据集CIFAR-10和网络VGG-9,拜占庭客户端占比不超过45%时,本文聚合算法的性能接近FedAvg*.对于数据集EMNIST和网络LeNet,拜占庭客户端占比不超过30%时,本文聚合算法的性能接近FedAvg*.所以,我们可以得出结论,本文聚合算法具有一定程度的防御自适应攻击的能力.

Fig.6 Test results of our aggregation algorithm under the adaptive attack

图6 自适应攻击下本文聚合算法的测试结果

6 相关工作

1) 检测层.本文聚合算法选择使用Softmax层输出的概率分布来判断模型的质量.我们认为这可能不是最佳的检测层.我们推测以全连接层的输出作为检测层可能效果更好,因为这一层具有更多参数.Huang等人[36]使用可解释性技术设计一个热力图来解释DNN的输出,从而判断模型参数是否异常.但Huang等人的方法的模型假设与本文不同,它要求防守方拥有一批包含所有类的干净数据集,这一要求在联邦学习中是难以实现的.总之,我们认为检测特定的网络层而不是整个网络更为有效.

2) 矩阵.本文聚合算法的矩阵由元素1填充,我们认为这可能不是矩阵的最佳填充方式.Kolouri等人[37]提出一组可以训练更新的“石蕊试纸”(ULPs)来检测后门模型.然而,它需要数百个预先训练的干净模型和后门模型来训练一个分类器和这组“石蕊试纸”,这一要求在联邦学习中是不切实际的.不过,如何联合客户端更新更有效的矩阵可能是一个值得研究的方向.Huang等人[38]提出了用于后门检测的单像素图像(one-pixel signature),与Kolouri等人的方法一样,单像素图像的使用也需要预先训练好的干净模型和后门模型.但是,运用单像素图像的思路,可能有利于改进本文聚合算法.

3) 其他聚合算法.最近,有研究者提出一些专门针对阻碍收敛攻击或后门攻击的聚合算法,例如,文献[39]提出一个针对阻碍收敛攻击的聚合算法:参数服务器观察每一轮中各用户模型与历史状态的一致性,从而判断哪些用户节点为恶意节点.文献[40]提出一个针对后门攻击的聚合算法:参数服务器观察用户提交的模型更新中的每一个维度的方向,方向一致性高的维度,其值予以采纳,方向一致性低的维度,将其值作负数处理,从而增大全局模型在测试数据集中的损失,迫使模型重新训练,这些聚合算法都具有启发性,但只能防守其中一种攻击,不同于这些聚合算法,本文聚合算法适应范围更广.

4) 局限性.虽然本文聚合算法首次实现了对边缘后门攻击的防守,但它对拜占庭客户端占比的容忍能力不强.如图7所示,在CIFAR-10中,对于3种边缘后门攻击,本文聚合算法对拜占庭客户端的容忍率(容忍率为聚合算法能抵抗攻击的最大客户端占比)为25%~45%;在EMNIST中,对拜占庭客户端的容忍率为10%~30%.对此,我们将深入探究其中的原因,并在将来的工作中进一步提高本文聚合算法防御后门攻击的能力.

Fig.7 Test poisoned dataset accuracy in our aggregation algorithm under three attacks and no attacks

图7 3种攻击和无攻击下本文聚合方式在毒数据集中的测试准确率

本文聚合算法未考虑联邦学习中的隐私保护问题,客户端提交的梯度对参数服务器端是透明的,当参数服务器端被恶意操控时,梯度的信息可以被一定程度反演出来,从而造成客户端隐私泄露.所以,实现秘密分享[41]对于联邦学习系统至关重要.此外,客户端提交模型存在异步性,如何在这种场景下提升通信效率也是联邦学习中的一大挑战[42],本文聚合算法在未来的工作中仍需克服这些挑战.

8 总 结

本文提出了一种基于矩阵映射的新型拜占庭鲁棒聚合算法.参数服务器首先通过矩阵映射客户端模型的更新部分以获得Softmax层概率分布,然后根据模型的概率分布异常程度决定是否保留此模型.本文对阻碍收敛攻击和后门攻击进行了评估.与基础的联邦学习聚合算法FedAvg相比,本文提出的算法在不遭受任何攻击的情况下性能与FedAvg相近,并且在防御目前先进的投毒攻击方面表现优于其他现有的先进聚合算法,而且,我们的算法在计算量上相比于之前的聚合算法降低了几千至几百万倍.此外,实验还表明:当每轮更新中拜占庭客户端不超过30%时,本文聚合算法可以有效抵御自适应攻击.

作者贡献声明:刘飚负责论文算法提出、映射模型设计;张方佼负责论文算法提出、实验设计、论文撰写;王文鑫负责实验验证、论文撰写;谢康负责实验实现与验证;张健毅负责论文算法提出、论文撰写.第一作者和第二作者对本文的贡献相同.

[1]Kone![]() n

n J, McMahan H B, Yu F X, et al. Federated learning: Strategies for improving communication efficiency[J]. arXiv preprint, arXiv:1610.05492, 2017.

J, McMahan H B, Yu F X, et al. Federated learning: Strategies for improving communication efficiency[J]. arXiv preprint, arXiv:1610.05492, 2017.

[2]McMahan B, Moore E, Ramage D, et al. Communication-efficient learning of deep networks from decentralized data[J]. arXiv preprint, arXiv:1602.05629, 2017.

[3]Baruch M, Baruch G, Goldberg Y. A little is enough: Circumventing defenses for distributed learning[J].arXiv preprint, arXiv:1902.06156, 2019. .

[4]Wang Hongyi, Sreenivasan K, Rajput S, et al. Attack of the tails: Yes, you really can backdoor federated learning[J]. arXiv preprint, arXiv:2007.05084, 2020.

[5]Blanchard P, ElMhamdi E M, Guerraoui R, et al. Machine learning with adversaries: Byzantine tolerant gradient descent[C] //Proc of the 31st Int Conf on Neural Information Processing Systems. Cambridge, MA: MIT Press, 2017: 118-128 .

[6]Cao Xiaoyu, Fang Minghong, Liu Jia, et al. FLTrust: Byzantine-robust federated learning via trust bootstrapping[J]. arXiv preprint, arXiv:2012.13995, 2020.

[7]Rieke N, Hancox J, Li Wenqi, et al. The future of digital health with federated learning[J]. NPJ Digital Medicine, 2020, 3(1): 1-7.

[8]Krizhevsky A, Hinton G. Learning multiple layers of features from tiny images[D/OL]. New York: University of Tront, 2009 [2020-10-03]. https://ci.nii.ac.jp/naid/20001706980/en/.

[9]Cohen G, Afshar S, Tapson J, et al. EMNIST: Extending MNIST to handwritten letters[C] //Proc of 2017 Int Joint Conf on Neural Networks (IJCNN). Piscataway, NJ: IEEE, 2017: 2921-2926 .

[10]Sun Ziteng, Kairouz P, Suresh A T, et al. Can you really backdoor federated learning?[J]. arXiv preprint, arXiv:1911.07963, 2019.

[11]Pillutla K, Kakade S M, Harchaoui Z. Robust aggregation for federated learning[J]. arXiv preprint, arXiv:1912.13445, 2019.

[12]Li Liping, Xu Wei, Chen Tianyi, et al. RSA: Byzantine-robust stochastic aggregation methods for distributed learning from heterogeneous datasets[C] //Proc of the AAAI Conf on Artificial Intelligence. Menlo Park, CA: AAAI, 2019, 33(1): 1544-1551.

[13]Fang Minghong, Cao Xiaoyu, Jia Jinyuan, et al. Local model poisoning attacks to Byzantine-robust federated learning[C] //Proc of the 29th USENIX Security Symp (USENIX Security’20). Berkeley, CA: USENIX Association, 2020: 1605-1622.

[14]Biggio B, Nelson B, Laskov P. Poisoning attacks against support vector machines[J]. arXiv preprint, arXiv:1206.6389, 2012.

[15]Chen Xinyun, Liu Chang, Li Bo, et al. Targeted backdoor attacks on deep learning systems using data poisoning[J]. arXiv preprint, arXiv:1712.05526, 2017.

[16]Fang Minghong, Yang Guolei, Gong N Z, et al. Poisoning attacks to graph-based recommender systems[C] //Proc of the 34th Annual Computer Security Applications Conf. New York: ACM, 2018: 381-392.

[17]Gu T, Dolan-Gavitt B, Garg S. Badnets: Identifying vulnerabilities in the machine learning model supply chain[J]. arXiv preprint, arXiv:1708.06733, 2017.

[18]Jagielski M, Oprea A, Biggio B, et al. Manipulating machine learning: Poisoning attacks and countermeasures for regression learning[C] //Proc of 2018 IEEE Symp on Security and Privacy (SP). Piscataway, NJ: IEEE, 2018: 19-35.

[19]Li Bo, Wang Yining, Singh A, et al. Data poisoning attacks on factorization-based collaborative filtering[J]. Advances in Neural Information Processing Systems, 2016, 29: 1885-1893.

[20]Mu oz-González L, Biggio B, Demontis A, et al. Towards poisoning of deep learning algorithms with back-gradient optimization[C] //Proc of the 10th ACM Workshop on Artificial Intelligence and Security. New York: ACM, 2017: 27-38.

oz-González L, Biggio B, Demontis A, et al. Towards poisoning of deep learning algorithms with back-gradient optimization[C] //Proc of the 10th ACM Workshop on Artificial Intelligence and Security. New York: ACM, 2017: 27-38.

[21] Nelson B, Barreno M, Chi F J, et al. Exploiting machine learning to subvert your spam filter[J]. LEET, 2008, 8: 1-9.

[22]Rubinstein B I P, Nelson B, Huang Ling, et al. Antidote: Understanding and defending against poisoning of anomaly detectors[C] //Proc of the 9th ACM SIGCOMM Conf on Internet Measurement. New York: ACM, 2009: 1-14.

[23]Shafahi A, Huang W R, Najibi M, et al. Poison frogs! targeted clean-label poisoning attacks on neural networks[J]. arXiv preprint, arXiv:1804.00792, 2018.

[24]Suciu O, Marginean R, Kaya Y, et al. When does machine learning FAIL? generalized transferability for evasion and poisoning attacks[C] //Proc of the 27th USENIX Security Symp (USENIX Security’18). Berkeley, CA: USENIX Association, 2018: 1299-1316.

[25]Wang Binghui, Gong N Z. Attacking graph-based classification via manipulating the graph structure[C] //Proc of the 2019 ACM SIGSAC Conf on Computer and Communications Security. New York: ACM, 2019: 2023-2040.

[26]Xiao Huang, Biggio B, Brown G, et al. Is feature selection secure against training data poisoning?[C] //Proc of the 32nd Int Conf on Machine Learning(ICML’15). Cambridge, MA: MIT Press, 2015: 1689-1698.

[27]Yang Guolei, Gong Zhenqiang, Cai Ying. Fake co-visitation injection attacks to recommender systems[C/OL] //Proc of the Network and Distributed System Symp (NDSS). 2017 [2020-05-23]. https://www.ndss-symposium.org/ndss2017/ndss-2017-programme/fake-co-visitation-injection-attacks-recommender-systems.

[28]Bagdasaryan E, Veit A, Hua Yiqing, et al. How to backdoor federated learning[J]. arXiv preprint, arXiv:1807.00459, 2018.

[29]Bhagoji A N, Chakraborty S, Mittal P, et al. Analyzing federated learning through an adversarial lens[J]. arXiv preprint, arXiv:1811.12470, 2018.

[30]He Lie, Karimireddy S P, Jaggi M. Byzantine-robust learning on heterogeneous datasets via resampling[J]. arXiv preprint, arXiv:2006.09365, 2020.

[31]Xie Cong, Koyejo O, Gupta I. Fall of empires: Breaking Byzantine-tolerant SGD by inner product manipulation[J]. arXiv preprint, arXiv:1903.03936, 2019.

[32]Xie Chulin, Huang Keli, Chen Pingyu, et al. Dba: Distributed backdoor attacks against federated learning[C/OL] //Proc of Int Conf on Learning Representations. 2019 [2020-01-16]. https://openreview.net/forum?id=rkgyS0VFvr.

[33]Yin Dong, Chen Yudong, Kannan R, et al. Byzantine-robust distributed learning: Towards optimal statistical rates[J]. arXiv preprint, arXiv:1803.01498, 2018.

[34]Hsu T M H, Qi Hang, Brown M. Measuring the effects of non-identical data distribution for federated visual classification[J]. arXiv preprint, arXiv:1909.06335, 2019.

[35]Kairouz P, McMahan H B, Avent B, et al. Advances and open problems in federated learning[J]. arXiv preprint, arXiv:1912.04977, 2019.

[36]Huang Xijie, Alzantot M, Srivastava M. Neuroninspect: Detecting backdoors in neural networks via output explanations[J]. arXiv preprint, arXiv:1911.07399, 2019.

[37]Kolouri S, Saha A, Pirsiavash H, et al. Universal litmus patterns: Revealing backdoor attacks in CNNs[C] //Proc of the IEEE/CVF Conf on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2020: 301-310.

[38]Huang Shanjiaoyang, Peng Weiqi, Jia Zhiwei, et al. One-pixel signature: Characterizing CNN models for backdoor detection[C] //Proc of European Conf on Computer Vision. Berlin: Springer, 2020: 326-341.

[39]Mallah R A, Lopez D, Farooq B. Untargeted poisoning attack detection in federated learning via behavior attestation[J]. arXiv preprint, arXiv:2101.10904, 2021.

[40]Ozdayi M S, Kantarcioglu M, Gel Y R. Defending against backdoors in federated learning with robust learning rate[J]. arXiv preprint, arXiv:2007.03767, 2020.

[41]Dong Ye, Hou Wei, Chen Xiaojun, et al. Efficient and secure federated learning based on secret sharing and gradients selection[J]. Journal of Computer Research and Development, 2020, 57(10): 2241-2250 (in Chinese)(董业, 侯炜, 陈小军, 等. 基于秘密分享和梯度选择的高效安全联邦学习[J]. 计算机研究与发展, 2020, 57(10): 2241-2250).

[42]Lu Xiaofeng, Liao Yuying, Lio P, et al. An asynchronous federated learning mechanism for edge network computing[J]. Journal of Computer Research and Development, 2020, 57(12): 2571-2582 (in Chinese)

(芦效峰, 廖钰盈, Lio P, 等. 一种面向边缘计算的高效异步联邦学习机制[J]. 计算机研究与发展, 2020, 57(12): 2571-2582)