近年来,基于大规模监督的深度神经网络在计算机视觉领域取得突飞猛进的发展.然而,在现实世界中,视觉数据的分布呈现显著的长尾效应,即很多视觉类仅包含少量的样本可供训练,这为计算机视觉的持续发展带来挑战[1].不同于深度神经网络,人总是可以从极少的样本中学习到这类样本的特点[2].例如,我们在只见过几次斑马后,就能认识到“斑马是一种身上有斑纹的马”.受此启发,小样本学习(few-shot learning, FSL)被提出用以完成仅有几个标注样本的视觉分类任务[3-4].

当前的小样本学习方法都基于统一假设:方法是在学习了一些视觉类的大量数据后,对于新的类别,才具有从少量样本中学习的能力[5].因此,在模拟小样本学习的过程中,将数据集分为源数据集(base dataset)和目标数据集(novel dataset)两部分.其中,源数据集中的每类都包含大量标记样本,且其涵盖的类别与目标数据集中的类别完全不重叠.小样本学习旨在源数据集上训练方法的小样本学习能力,然后将方法迁移到目标数据集上进行小样本学习能力的测试.根据小样本在源数据集上的学习模式,研究方法主要分为3类:基于数据增强的方法、基于度量学习的方法以及基于优化的方法.其中,数据增强方法旨在利用一些转换规则或生成理论合成一些虚假图像,达到扩充数据集的目的[6];度量学习方法将小样本分类转化为学习样本间语义距离的问题,根据无标记样本与其他所有标记样本的距离来进行分类[7];基于优化的方法尝试为小样本任务学习参数初始化函数,使得训练从好的初始点开始并只迭代几次就达到不错的分类效果[8-9].

传统的小样本学习方法缺乏过程的可解释性,属于黑盒方法,即对于方法如何完成样本识别的过程仍不清晰.换言之,如何通过构建无标记样本以及标记样本之间的关联关系进行样本分类的这一过程仍不明晰.因此,为小样本分类提供可解释的推理过程是一个值得研究的方向.不同于一般的黑盒方法,人类在识别现实世界中的对象时往往有明确的证据支撑.人类在做出决策前,会先分析无标记图像的一些关键部位,然后在大脑中搜索与这些关键部位相关的记忆.例如,人类可以对“啄木鸟”的图像进行分类,是因为“啄木鸟”的喙与他们之前见过的“啄木鸟”样本高度相似.

受此启发,我们模拟人脑做出决策的过程,提出基于对比约束的可解释小样本学习(interpretable few-shot learning, INT-FSL)方法.INT-FSL方法采用元学习思想生成多个小样本分类元任务,每个元任务有极少的标记样本作为支持集,通过挖掘无标记样本与标记样本间的关联关系达到分类目标.当设定每个元任务中包含M个类且每类有K个标记样本时,称为M-way K-shot小样本分类任务.如图1是3-way 2-shot小样本学习任务描述图.INT-FSL方法包括3个模块:特征映射模块、可解释小样本分类模块和对比学习模块.其中,特征映射模块用于提取样本的深度特征,将单个图像样本表示为多个局部描述子的集合;可解释小样本分类模块一方面用标记样本的局部特征描述子重构图像类别的描述子空间,另一方面挖掘无标记样本的关键部位,并通过度量这些关键部位与所有类别描述子空间的语义距离来对它进行分类,以便提供可解释的分类过程;对比学习模块旨在对比元任务中目标无标记图像与其他样本的局部和全局特征,以达到强化样本局部表征的能力.在训练过程中,INT-FSL方法联合交叉熵分类损失与对比损失,在优化训练数据上小样本分类性能的同时,保证方法在测试数据上保持良好的泛化能力.本文的主要贡献有3个方面:

1)提出可解释性的小样本分类模块,采用注意力机制提取无标记样本的关键局部特征,通过学习这些关键特征与其他标记样本局部特征的关联关系,达到小样本分类的目标,以便回答“方法对哪些区域感兴趣,无标记样本的这些区域与支持样本的哪些区域相似”问题,满足用户的可解释性需求;

2)将特征对比学习模块融入小样本分类模块,通过对比元任务中目标无标记样本与其他样本的局部和全局语义特征,达到利用样本自身信息增强特征映射模块有效性的目标,进而缓解小样本分类中监督信息不足的问题.

3)在3个真实数据集上进行了大量小样本图像分类的实验.实验结果证明,INT-FSL方法不仅能有效提高当前主流小样本学习方法的分类准确度,而且能提供有效的可解释性决策过程.

Fig.1 3-way 2-shot few-shot learning with meta-learning training pattern

图1 基于元学习的3-way 2-shot小样本学习任务描述图

1 相关工作

1.1 小样本学习

小样本学习旨在从极少甚至仅仅一个标记样本中学习这类图像的特性.人脑具有先天的小样本学习能力,比如小孩只去过几次动物园后,就能准确分辨狮子和斑马等动物.受此启发,小样本学习涌入了机器学习领域,并引起了很多研究者的关注.近年来,随着深度学习技术的迅猛发展,很多基于卷积神经网络的方法在小样本分类上取得了优异的性能.这些方法主要分为3类:基于数据增强的方法、基于度量学习的方法以及基于优化的方法.

基于数据增强的方法强调利用图像转换规则,如裁剪、映射、翻转等方式扩充有限的小样本数据集.例如,Alfassy等人[6]提出将给定的样例映射到特征空间,采用特征向量合成方法生成对应标签集中的样例,例如交、并、差等操作;由于人工制定的转换规则是有限的,导致扩充的新样本与原始样本差别不大;为此,Edraki等人[10]提出基于图像生成的数据增强方法,将文本或标签输入生成对抗网络[11],生成与其对应的图像样本;Schwartz等人[12]设计了一种创新的自动编码器结构,该编码器有效捕获同类训练实例对间的类内变形信息,并将这些信息迁移到只有少数样本的新类别,以便有效合成新类别的样本;Zhang等人[13]提出一种通用的小样本框架MetaGNN学习特定任务中数据分布的流形结构,由此生成一些虚假数据来辅助小样本分类器学习更清晰的决策边界;另外,Zhang等人[14]利用显著性目标检测算法分割图像,将不同图像的前景和背景组合生成很多虚假图像,以此实现数据集的扩充.

基于度量的方法将小样本分类问题转化为样本间的相似度度量问题.这类方法往往对特征空间中样本间距离分布进行建模,使得在该空间中同类样本靠近且异类样本远离.例如,Koch等人[15]通过构建一个孪生网络(siamese network)来挖掘2张图像高层语义特征的相似性,进而判断其是否来自同一个图像类;Vinyals等人[7]将度量学习与记忆增强网络[16]结合,提出一种端到端的深度匹配网络(matching network),实现了在少量样本的条件下对无标记样本的标签预测;Snell等人[17]提出一种小样本原型网络(prototypical network),将每类样本的特征中心点作为原型,通过度量测试样本到所有类别原型的欧氏距离来预测样本标签;Sung等人[18]考虑将基于深度的特征映射函数和非线性距离函数联合学习,通过构建一种端到端的关系网络(relation network)实现小样本图像识别.另外,还有很多研究者利用图卷积神经网络(graph convolution neural network)来学习样本间的关联关系,从而实现小样本分类的目标[19-21].

基于优化的方法认为:当只有少量标注样本时,梯度优化算法如momentum[22],ADAM[23]等无法使深度网络中的大量参数在几步内快速收敛;为此,对于小样本任务,尝试系统的学习一个参数初始化函数,使得训练从一个好的初始点开始并只迭代几次就达到不错的分类效果,例如,Finn等人[8]提出一种与方法无关(model-agnostic)的元学习方法,该方法能快速且高效地适应多个小样本分类任务;Ravi等人[24]提出,对于一个规模较大的小样本分类器,其可以使用一个参数量较少的长短时记忆网络(long short-term memory, LSTM)元学习器来优化学习;另外,Li等人[25]提出一种更容易实现、效率更高的Meta-SGD方法,该方法不仅可以学习小样本分类器的初始化参数,还可以学习其更新方向和学习率.

1.2 对比学习

对比学习旨在通过大量正负样本进行对比的方式学习一个语义嵌入空间,使得相似样本在该空间距离接近,而不相似样本间距离较远.对比学习是一种有效的自监督学习方式,其主要利用数据本身作为监督信息来学习样本的特征表达.根据构造正负样本对的粒度可将当前的对比学习框架分为2类:情境-实例对比与实例-实例对比,这2类框架在下游任务中都表现出很好的性能.

情境-实例对比也称为全局-局部对比,该学习模式主要针对图像样本的局部特征与全局上下文间的归属关系进行建模.也就是说,样本的某一局部表征与其对应的全局语义间应具有较高的关联度,例如“条纹状身体”(图像局部)的语义应在“斑马”(图像全局)的语义表征中有所体现.例如,DIM(Deep InfoMax)[26]方法通过最大化图像局部特征与全局上下文间的互信息来学习无监督表示,其采用对抗匹配先验分布的方式来实现统计特征约束.另外,DeepMind团队提出一种创新的对比预测编码(contrastive predictive coding, CPC)[27]方法,其通过编码器将高维数据嵌入到低维空间,然后结合自回归建模与噪声对比估计来预测未来时刻样本序列的语义表示.不同于DIM方法,AMDIM(Augmented Multiscale Deep InfoMax)[28]方法一方面添加了多种扩充图像数据的方法,包括随机裁剪、颜色变换、灰度图转换等,另一方面对图像的不同尺度特征进行互信息的最大化,以达到增强方法泛化性的目标.除了图像领域外,基于全局-局部的对比学习模式也广泛应用在文本和图数据领域.例如,InfoWord[29]通过最大化N-Gram局部语义和句子全局语义的互信息来训练语言方法,其中正样本是当前语境下的N-Gram词表征,负样本是语料库中其他语境下的词表征.在图学习中,DGI(Deep graph InfoMax)[30]方法将节点表示作为局部特征,将随机采样的2-hop邻居节点的平均表征作为全局上下文,并通过节点扰动生成负样本,实现局部-全局的对比模式.

实例-实例的对比学习模式主要针对图像样本的多个视图间关联关系进行建模.例如,CMC(Con-trastive Multiview Coding)[31]采用同一张图像的多个不同视图作为正样本,另一张图像的任一视图作为负样本,约束正样本在嵌入空间中的距离接近且与负样本的距离较远.动量对比(momentum contrast, MoCo)[32]方法更加关注负样本的数量,其从字典查找的角度出发,构建带有队列和平均移动编码器的动态字典.当查询是相同图像的编码视图,则查询将与关键字匹配,否则不匹配.SimCLR[33]是一种非常简易的对比学习框架,其更加强调构建负样本的方式对对比学习的重要性.SimCLR通过数据增强的方式生成输入图像的正样本,将batch中的其他图像当成负样本,并采用噪声对比估计损失来调整相似性评分的范围.另外,Tian等人[34]提出一种InfoMin对比学习原则,其使特征提取网络在学到不同视图之间共享的信息之外,尽量去除与下游任务无关的冗余信息来保证学习到的特征具有很好的泛化能力;Grill等人[35]认为正负样本之间的对比会使训练过程很不稳定,同时会增大数据集的系统偏差.为此,他们提出了无需负采样的BYOL方法,显著改善了对比学习方法的训练效率和泛化能力.目前,基于实例-实例对比的策略也已经广泛应用于图数据表征[36-37].

2 可解释小样本学习网络

本节介绍基于对比约束的可解释小样本学习方法及应用.2.1节给出了小样本学习的定义.2.2节提出了可解释的小样本网络框架INT-FSL.

2.1 问题定义

在小样本分类任务中,包含源数据集Dbase和目标数据集Dnovel两部分.Dbase与Dnovel中类别语义相关但不重叠,且源数据集Dbase中每类都包含大规模标记样本.基于元学习的训练模式是当前主流的小样本学习方法[27],其在Dbase上生成多个元任务训练方法,并在Dnovel上生成新的元任务测试方法的小样本学习能力.每个元任务可记作T={S,Q},其中S是由极少标记样本组成的支持集,Q是由无标记样本组成的查询集.元任务的目标是在给定支持集S的条件下对Q中的样本进行分类.当S集合包含M个类,且每类有K个标记样本时,即![]() 记为M-way K-shot小样本任务.

记为M-way K-shot小样本任务.

Fig.2 Framework of interpretable few-shot learning with contrastive constraint

图2 基于对比约束的可解释小样本学习方法

2.2 网络结构

本节详细介绍基于对比约束的可解释小样本学习方法INT-FSL.如图2整体框架图所示,其包含3个模块:特征映射模块(feature embedding module)、可解释小样本分类模块(few-shot learning module)和对比学习模块(contrastive learning module).3个模块的具体介绍:

1)特征映射模块.给定元任务T={S,Q},特征映射模块提取支持集与查询集中所有图像的深度特征.图2中的映射函数ψ(·)是典型的深度卷积网络,可以是VGG,ResNet等框架.对于任意图像X∈T,经过深度卷积网络后输出d×h×w的三维张量,可以视作hw个维度为d的局部特征描述子集合,即:

ψ(X)={x1,x2,…,xhw},xj∈Rd,

(1)

其中,xj代表第j个深度局部描述子.经过特征映射模块后,将支持集中所有图像样本的深度表征记作![]() 查询集中的任一无标记图像Xq∈Q的深度表征记为ψ(Xq).

查询集中的任一无标记图像Xq∈Q的深度表征记为ψ(Xq).

2)可解释小样本分类模块.如图2可解释小样分类模块部分,方法通过度量无标记图像到支持集中M个类别的语义距离来实现小样本分类的目标.首先,该模块利用样本的局部特征描述子重构图像类别的描述子空间.对于支持集中的任一类别m,其对应的子空间是所有属于该类标记样本的局部描述子集合,记为

(2)

给定无标记图像Xq,其对应的局部描述子集合为![]() 对于每个描述子

对于每个描述子![]() 在类别m对应空间Rm中搜索与其余弦距离最近的h个描述子,记为

在类别m对应空间Rm中搜索与其余弦距离最近的h个描述子,记为

(3)

基于此,描述子![]() 与第m类子空间的关联得分值为

与第m类子空间的关联得分值为

(4)

将Xq中所有描述子与第m类子空间的关联得分值记为向量![]() 式(3)中的KNN搜索过程过滤了类别描述子空间中的背景噪声,即子空间中与当前元任务不相干的局部描述子并不影响最终的分类结果,这在一定程度上缓解了图像形变、角度、背景等变换带来的负面影响.

式(3)中的KNN搜索过程过滤了类别描述子空间中的背景噪声,即子空间中与当前元任务不相干的局部描述子并不影响最终的分类结果,这在一定程度上缓解了图像形变、角度、背景等变换带来的负面影响.

不同空间位置的局部描述子对无标记图像的语义贡献是有很大差距的.例如,对于一张描述狗的图像,图像中关于眼睛、耳朵、尾巴的局部描述子比其他描述草、房间等背景信息的特征更为重要.在小样本分类中,需要对图像中的一些关键部位赋予更强的关注度,减弱噪声部位的负面影响,通过适应多种图像变换来强化小样本分类的鲁棒性.为此,在图2中设计空间注意力机制学习不同局部描述子对小样本分类的注意分值,该过程可形式化为

aq=σ(AvgPool(ψ(Xq));MaxPool(ψ(Xq))),

(5)

其中,平均池化操作AvgPool(·)与最大池化操作AvgPool(·)旨在ψ(Xq)的通道方向进行下采样,输出经过拼接后形成2×h×w维的张量.该张量通过卷积函数σ(·)后,转换为一维空间注意力向量![]() 在上述基础上,以aq为权重系数向量,预测无标记图像Xq与第m类图像特征子空间Rm的特征相似得分:

在上述基础上,以aq为权重系数向量,预测无标记图像Xq与第m类图像特征子空间Rm的特征相似得分:

(6)

除此之外,我们认为同类图像在特征分布上存在高度相似性,而不同类图像的特征分布差异较大.为此,设计度量方法计算无标签图像样本Xq与支持集中第m类图像特征子空间Rm的分布相似得分:

Sdis(Xq,m)=![]() ,

,

(7)

其中,μq与Σq分别是图像样本Xq局部描述子集合ψ(Xq)的均值向量和方差矩阵,μm与Σm是第m类图像特征子空间Rm的均值向量和方差矩阵.显然,当ψ(Xq)与Rm的空间分布越接近,Sdis(Xq,m)得分值越高,反之亦然.

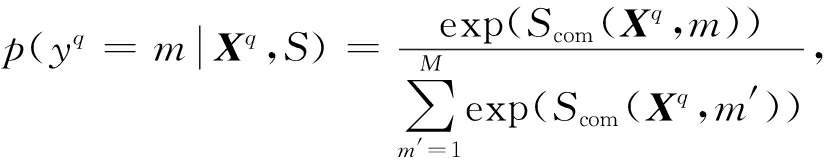

综合式(6)与式(7)中的特征与分布得分,预测图像Xq属于支持集S中第m类的概率值:

(8)

其中,Scom(Xq,m)是特征相似得分Sfea(Xq,m)与分布相似得分Sdis(Xq,m)的和.

基于此,采用交叉熵度量当前元任务T={S,Q}的真实损失值为

(9)

其中,![]() 是图像Xq的真实标签.

是图像Xq的真实标签.

3)对比学习模块.小样本分类任务中的监督信息非常有限,容易造成过拟合.为此,借鉴Deep InfoMax[26]对比方法中的思想,通过最大化互信息的方式辅助小样本特征映射,增强局部描述子的语义表征.如图2对比学习模块部分,对于查询集中样本Xq,局部描述子集合为![]() 通过ψ(Xq)上多层卷积操作得到样本全局表征向量xq.基于此,设计全局与局部对比2种模式.

通过ψ(Xq)上多层卷积操作得到样本全局表征向量xq.基于此,设计全局与局部对比2种模式.

① 全局对比.旨在约束图像全局表征xq与图像特征Eψ(Xq)间的互信息最大,可形式化为

(10)

其中,![]() 表示互信息度量函数.

表示互信息度量函数.

② 局部对比.旨在约束图像全局表征xq与图像局部特征集合Eψ(Xq)中的任一局部描述![]() 间的互信息最大,可形式化为

间的互信息最大,可形式化为

(11)

互信息度量函数有多种实现类型,本文采用典型的Jensen-Shannon散度(JSD)进行度量,实现过程与Hjelm等人[26]的工作基本一致.

综合上述三大模块,INT-FSL方法的整体目标优化函数为

(12)

其中,λ和β分别是全局对比与局部对比损失的权衡系数.

3 实验与结果

本节在3个数据集上验证所提INT-FSL方法的有效性,并将依次介绍实验数据集、对比方法、实验设置、对比结果定量分析、对比模块以及可解释性实验分析.

3.1 数据集

我们使用了3个公开图像数据集进行实验.其中,miniImageNet[7]是大规模ImageNet数据集的子集,包含100类图像,每类600张图像样本,其中64,16,20类图像分别用于训练、验证和测试数据集.Stanford Dogs[38]是斯坦福大学构建的犬类数据集,其仍然是ImageNet数据集的子集,共有20 580张图像,涉及120类狗.其中,70类图像用于训练,20类用于验证,30类用于测试.CUB-200-2011[39]是2011年发布的一个鸟科数据集,由加州理工大学构建,涵盖200种不同的鸟,每种鸟大概有60张图像,共有11 788张图像.在本实验中,130,20,50种鸟分别用于训练、验证与测试.

3.2 对比方法

本文将所提INT-FSL方法与11种流行的小样本分类方法相比,验证INT-FSL方法的有效性.

1)Matching Net[7].经过卷积特征提取模块与LSTM上下文嵌入模块后,通过度量目标图像与支持集图像在特征空间的距离来实现小样本分类.

2)MAML[8].学习一组泛化能力强的初始化参数,使其能在小样本场景下经过一步或几步梯度调整后就能达到快速收敛的目的.

3)Prototypical Net[17].采用支持集中每类图像的平均特征向量来表示该类图像的原型,计算目标图像与所有原型的空间距离,判别目标图像类别.

4)Relation Net[18].联合学习样本的特征映射函数与样本间的距离度量函数,以目标样本与支持集中标记样本间的距离为依据,实现小样本分类.

5)SNAIL[40].结合时序空洞卷积与因果注意力机制,将小样本分类任务转化为一个序列到序列的问题,达到快速吸取过去经验的目标.

6)DN4[41].用多个局部描述子表征图像语义,采用最近邻算法比较目标图像与每个类别的局部描述子间的相似度,以此完成小样本分类.

7)DSN[42].提出一种动态的子空间分类器,为每个类别寻找一个适合的特征子空间,通过度量目标图像在子空间与带标签样本的距离来预测类别.

8)MAML+L2F[43].采用动态衰减策略自动控制先验知识对当前小样本分类任务的影响,遗忘MAML初始化参数中的冲突,以便更好适应当前的小样本任务.

9)BOIL[44].在MAML算法的内循环中,设计只更新方法的特征提取器模块,冻结小样本分类器模块,从而更好的适用新领域的小样本分类任务.

10)PCM[45].设计端到端的小样本网络,包括双线性特征学习模块和分类器映射模块.其中,分类器映射模块以参数很少的方式生成决策边界.

11)RCN[46].在基于局部特征小样本匹配的基础上,添加了可解释模块为小样本分类结果提供依据,并提出一种区域激活映射的方法可视化策略.

3.3 实验设置

INT-FSL方法是基于开源深度学习框架Pytorch实现的.为了减少开销,所有图像都调整为84×84×3的大小后再输入到INT-FSL网络.所有网络的中间层都使用ReLU函数进行非线性映射.另外,网络中所有卷积以及全连接层后都添加了归一化操作(batch normalization),同时在全连接层后加入了概率为0.1的dropout层,增强网络稳定性和泛化能力.INT-FSL方法在32 G单块GPU的Tesla服务器上运行.在上述设置下,将目标函数(13)中的权衡系数λ和β分别设为0.5与1.0,采用学习率为0.01,动量为0.9,权值衰减为0.001的随机梯度下降法来优化INT-FSL方法中的参数.

Table 1 The Experimental Results on miniImageNet Dataset

表1 INT-FSL方法在miniImageNet上的实验结果

主干网络方法5-way1-shot5-way5-shotConv4ResNet-12MatchingNet43.56±0.8455.31±0.73MAML48.70±1.8463.11±0.92ProtoNet49.42±0.7868.20±0.66RelationNet50.44±0.8265.32±0.70SNAIL45.1055.20DN451.24±0.7471.02±0.64DSN51.78±0.9668.99±0.69MAML+L2F52.10±0.4969.38±0.46BOIL49.61±0.1666.45±0.37INT-FSL54.62±0.7972.79±0.63MatchingNet65.64±0.2078.72±0.15ProtoNet60.37±0.8378.02±0.57SNAIL55.71±0.9968.88±0.92DN454.37±0.3674.44±0.29DSN62.64±0.6678.73±0.45INT-FSL64.32±0.8780.12±0.52

注:黑体数字表示每种实验设置下的最佳结果.

3.4 对比结果分析

将M-way K-shot小样本设置中的M=5,K设为1和5,批大小设为32.为了公平对比,我们在每种小样本设置场景下运行5次,计算分类的平均准确率和标准差.表1~3分别记录了miniImageNet,Stanford Dogs,CUB-200-2011三个公开数据集上的小样本分类结果.对于INT-FSL方法中的特征映射模块,我们在miniImageNet数据集上采用了Conv4(4层图卷积)和ResNet网络2种,在其他2个数据集上只采用了Conv4一种.另外,我们在细粒度数据集CUB-200-2011以及Stanford Dogs上采用了图像旋转、变形等方式进行数据增强.对比这些实验结果,可得出3点结论:

1)在已有的小样本方法中,MAML+L2F方法在miniImageNet数据集上取得最优分类效果.RCN方法在Stanford Dogs和CUB-200-2011两个数据集上取得最佳性能.这是因为MAML+L2F方法的动态衰减策略能有效缓解不同小样本分类元任务间的冲突影响,从而使初始化参数在不同任务上具备更好的适应能力;RCN方法采用局部区域元学习器捕获图像的关键位置特征,从而更好地进行小样本分类.

2)与已有的小样本分类方法相比,在大多数情况下,所提出的INT-FSL方法的图像分类性能显著提升.例如,对于5-way 1-shot分类任务,INT-FSL(Conv4)在miniImageNet上提高了2.52个百分点,在Stanford Dogs和CUB-200-2011两个数据集上分别提高了3.62和6.55个百分点.这说明INT-FSL方法能有效捕捉无标记样本的关键部位,并准确学习这些部位与标记样本间的关联关系,进一步改善小样本图像识别的性能.

Table 2 The Experimental Results on Stanford Dogs Dataset

表2 INT-FSL方法在Stanford Dogs上的实验结果

方法主干网络5-way1-shot5-way5-shotMatchingNetConv435.80±0.9947.50±1.03MAMLConv444.81±0.3458.68±0.31ProtoNetConv437.59±1.0048.19±1.03RelationNetConv443.33±0.4255.23±0.41DN4Conv445.41±0.7663.51±0.62PCMConv428.78±2.3346.92±2.00RCNConv454.29±0.9672.65±0.72INT-FSLConv457.91±0.8875.59±0.69

注:黑体数字表示每种实验设置下的最佳结果.

Table 3 The Experimental Results on CUB-200-2011 Dataset

表3 INT-FSL方法在CUB-200-2011上的实验结果

方法主干网络5-way1-shot5-way5-shotMatchingNetConv455.92±0.9572.09±0.76MAMLConv448.70±1.8463.11±0.92ProtoNetConv451.31±0.9170.77±0.69RelationNetConv462.45±0.9876.11±0.69DN4Conv452.79±0.8681.45±0.70PCMConv442.10±1.9662.48±1.21RCNConv467.06±0.9382.36±0.61INT-FSLConv473.61±0.8988.32±0.53

注:黑体数字表示每种实验设置下的最佳结果.

Table 4 The Contrastive Learning Analysis on Three Datasets

表4 对比学习模块消融分析的实验结果

数据集方法5-way1-shot5-way5-shotMiniImageNetStanfordDogsCUB-200-2011INT-FSL#053.56±0.8172.09±0.64INT-FSL#153.87±0.7972.31±0.64INT-FSL#254.43±0.8072.47±0.66INT-FSL54.62±0.7972.79±0.63INT-FSL#056.75±0.9074.96±0.66INT-FSL#156.96±0.8975.02±0.68INT-FSL#257.56±0.8775.36±0.69INT-FSL57.91±0.8875.59±0.69INT-FSL#072.43±0.8788.11±0.50INT-FSL#172.83±0.8688.09±0.54INT-FSL#273.57±0.8888.27±0.50INT-FSL73.61±0.8988.32±0.53

注:黑体数字表示每种实验设置下的最佳结果.

3)在3个数据集上的实验结果都呈现一个共同的现象:随着shot的增加,分类性能明显上升.例如,当INT-FSL(Conv4)方法在miniImageNet运行时,5-way 5-shot上的小样本分类性能比5-way 1-shot的结果高18.17个百分点.这个现象非常合理,因为标注样本越少,小样本分类任务的难度越高,分类的准确率越低.

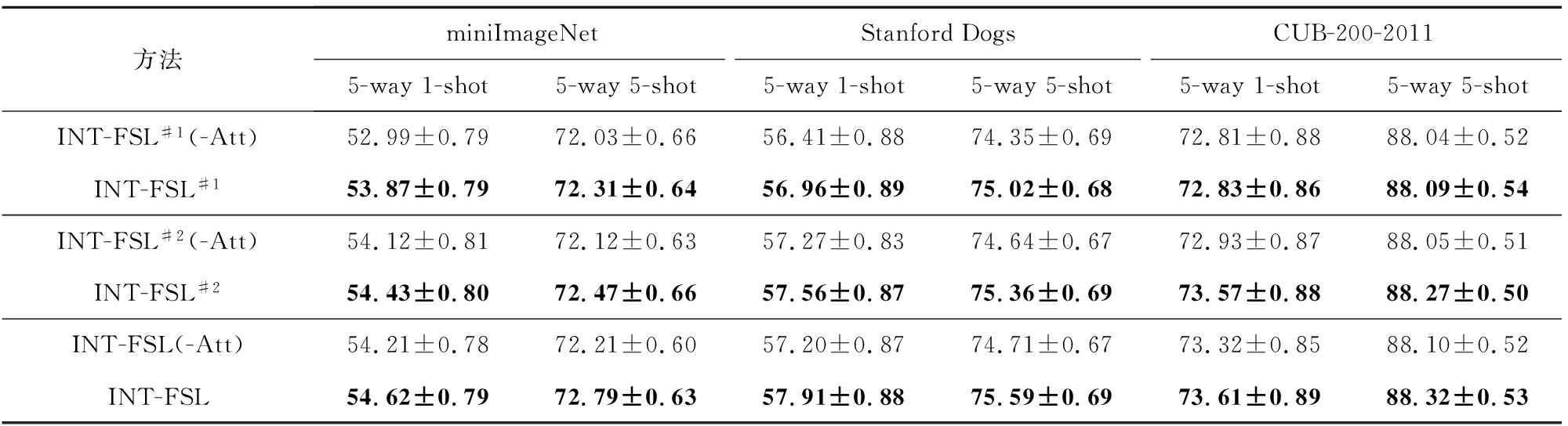

3.5 对比学习模块分析

INT-FSL方法中的特征对比模块通过生成大量正负样本对比的方式,将数据内部信息利用起来以强化图像的局部特征表征.INT-FSL方法中包含全局对比和局部对比2种模式.为了进一步验证该模块对小样本图像分类性能的影响,本节设计了3个方法变种进行实验验证分析.其中,INT-FSL#0是在原始方法的基础上去掉特征对比学习模块,即目标函数(12)中的权重系数λ=β=0;INT-FSL#1只保留对比学习模块中的全局对比模式,去除局部对比模式,即λ=0.5且β=0;相反,INT-FSL#2保留对比学习模块中的局部对比模式,去除全局对比模式,即λ=0且β=1.0.在5-way 1-shot和5-way 5-shot任务设置下,表4记录了4种方法在3个数据集上的小样本分类性能.从表4中可以分析得到:

1)与INT-FSL#0相比,其他3种方法都能在一定程度上提升了小样本图像识别的性能.例如,在数据集miniImageNet上,INT-FSL#0方法在5-way 1-shot小样本分类任务上的准确率为53.56%,INT-FSL#1,INT-FSL#2与INT-FSL能在此基础上分别提升0.31,0.87与1.06个百分点.这个现象进一步说明对比学习模块能通过最大化互信息的方式有效辅助小样本特征映射,增强图像局部描述子的语义表征.

2)在大多数情况下,方法INT-FSL#2的小样本分类性能略高于INT-FSL#1.对于5-way 1-shot任务,INT-FSL#1在Stanford Dogs与CUB-200-2011上的分类准确率达56.96%与72.83%.INT-FSL#2分别达到57.56%和73.57%的性能.INT-FSL方法能将准确率提升到57.91%和73.61%.结果说明,局部对比和全局对比模式都对小样本分类具有一定的促进作用,且当这2种模式综合考虑时性能提升更加明显.

3.6 可解释分析

在所提的小样本分类模块中,将注意力机制作用于无标记图像的hw个局部描述特征上,得到每个局部描述子对于当前图像语义的贡献度.通过学习无标记图像重要区域与标记样本的相似度,达到小样本分类的目标,并提供了可解释的决策过程.本节在方法INT-FSL#1,INT-FSL#2与INT-FSL方法上去除小样本分类模块中的注意力机制(记为“-Att”),即通过赋予无标记图像所有局部描述子相同的权重完成3个数据集上的小样本分类任务.根据表5的实验结果可以得知,注意力机制能有效提升小样本分类的性能.例如,与INT-FSL(-Att)相比,INT-FSL在5-way 1-shot与5-way 5-shot小样本任务上提升0.2~0.9个百分点.

Table 5 Spatial Attention Analysis for INT-FSL#1,INT-FSL#2,INT-FSL on Three Datasets

表5 方法INT-FSL#1,INT-FSL#2,INT-FSL在3个数据集上的空间注意力机制分析

方法miniImageNetStanfordDogsCUB-200-20115-way1-shot5-way5-shot5-way1-shot5-way5-shot5-way1-shot5-way5-shotINT-FSL#1(-Att)52.99±0.7972.03±0.6656.41±0.8874.35±0.6972.81±0.8888.04±0.52INT-FSL#153.87±0.7972.31±0.6456.96±0.8975.02±0.6872.83±0.8688.09±0.54INT-FSL#2(-Att)54.12±0.8172.12±0.6357.27±0.8374.64±0.6772.93±0.8788.05±0.51INT-FSL#254.43±0.8072.47±0.6657.56±0.8775.36±0.6973.57±0.8888.27±0.50INT-FSL(-Att)54.21±0.7872.21±0.6057.20±0.8774.71±0.6773.32±0.8588.10±0.52INT-FSL54.62±0.7972.79±0.6357.91±0.8875.59±0.6973.61±0.8988.32±0.53

注:黑体数字表示每种实验设置下的最佳结果.

Fig.3 Spatial attention visualization for some unlabeled images from CUB-200-2011 dataset

图3 CUB-200-2011数据集上无标记样本的空间注意力可视化展示

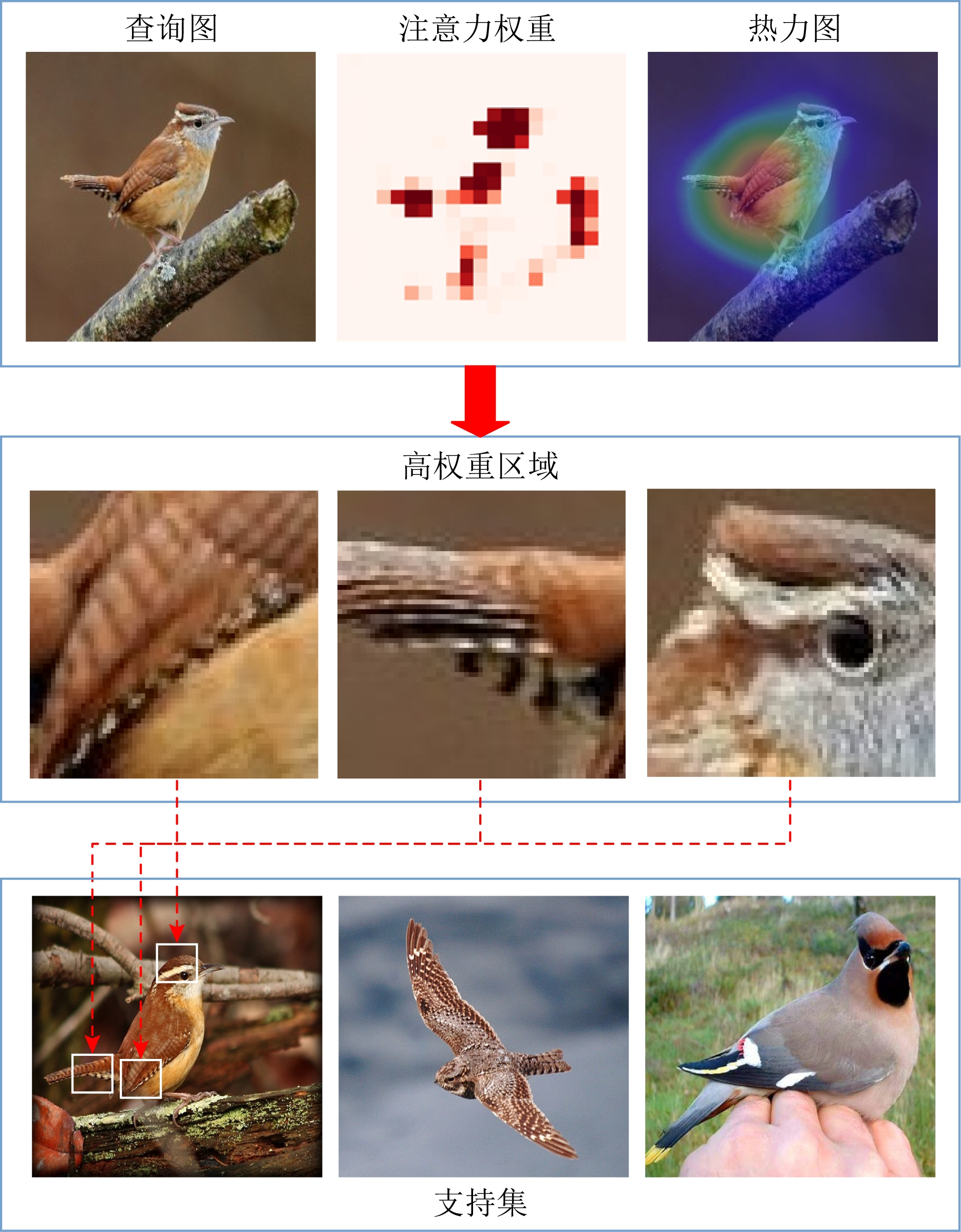

为了进一步说明INT-FSL方法的可解释性,我们针对CUB-200-2011数据集上的小样本分类元任务进行案例分析.图3是查询集中4张无标记图像的注意力权重矩阵与热力图的可视化结果.可以看出,无标记鸟类样本的分类主要取决于图像中“头”“嘴巴”“身体”“脚”等关键部位,而与其周围背景的关联度偏弱.另外,针对一个3-way 1-shot的小样本分类任务,图4展示了该任务中无标记图像注意力权重取值较大的3个区域,并展示了支持集中与这3个关键区域最相似的3个局部区域,可发现支持集中的一张标记图像与无标记图像的这3个区域高度相似,这在很大程度上为小样本分类的过程提供了可解释的推理过程.

Fig.4 Case study of interpretable few-shot learning

图4 可解释小样本学习的示例分析

4 总 结

本文提出了一种创新的基于对比约束的可解释小样本图像识别方法INT-FSL,旨在通过注意力机制提取无标记样本的关键局部特征,学习这些关键特征与其他标记样本局部特征的关联关系,为小样本分类提供可解释的推理过程.另外,INT-FSL方法融合对比学习机理,设计全局和局部2种对比模式增强图像的特征表征能力,缓解小样本分类中监督信息不足的问题.本文在3个标准图像数据集上进行验证,结果表明INT-FSL方法不仅能有效提高当前主流小样本方法的分类准确度,而且能提供有效的可解释性决策过程,满足用户的可解释性需求.在未来工作中,可以设计更符合小样本学习的对比策略来强化分类性能,同时调整特征映射模块的网络结构,满足小样本分类任务中图像特征提取的可解释性需求.

[1]Liu Huan, Zheng Qinghua, Luo Minnan, et al.Cross-domain adversarial learning for zero-shot classification[J].Journal of Computer Research and Development, 2019, 56(12): 2521-2535(in Chinese)(刘欢, 郑庆华, 罗敏楠, 等.基于跨域对抗学习的零样本分类[J].计算机研究与发展, 2019, 56(12): 2521-2535)

[2]Lake B M, Salakhutdinov R, Tenenbaum J B.Human-level concept learning through probabilistic program induction[J].Science, 2015, 350(6266): 1332-1338

[3]Li Feifei.A Bayesian approach to unsupervised one-shot learning of object categories[C]//Proc of IEEE Int Conf on Computer Vision.Piscataway, NJ: IEEE, 2003: 1134-1141

[4]Li Feifei, Fergus R, Perona P.One-shot learning of object categories[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 2006, 28(4): 594-611

[5]Wang Yaqiang, Yao Quanming, Kwok J T, et al.Generalizing from a few examples: A survey on few-shot learning[J].ACM Computing Surveys, 2020, 53(3): 1-34

[6]Alfassy A, Karlinsky L, Aides A, et al.Laso: Label-set operations networks for multi-label few-shot learning[C]//Proc of the IEEE Conf on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE, 2019: 6548-6557

[7]Vinyals O, Blundell C, Lillicrap T, et al.Matching networks for one shot learning[C]//Proc of the Advances in Neural Information Processing Systems.Cambridge, MA: MIT Press, 2016: 3630-3638

[8]Finn C,Abbeel P, Levine S.Model-agnostic meta-learning for fast adaptation of deep networks[C]//Proc of the Int Conf on Machine Learning.New York: ACM, 2017: 1126-1135

[9]Nichol A, Schulman J.Reptile: a scalable metalearning algorithm[J].arXiv preprint arXiv:1803.02999, 2018

[10]Edraki M, Qi Guojun.Generalized loss-sensitive adversarial learning with manifold margins[C]//Proc of the European Conf on Computer Vision.Piscataway, NJ: IEEE, 2018: 87-102

[11]Goodfellow I, Pouget-Abadie J, Mirza M, et al.Generative adversarial nets[C]//Proc of the Advances in Neural Information Processing Systems.Cambridge, MA: MIT Press, 2014: 2672-2680

[12]Schwartz E, Karlinsky L, Shtok J, et al.Delta-encoder: An effective sample synthesis method for few-shot object recognition[C]//Proc of the Conf and Workshop on Neural Information Processing Systems.Cambridge, MA: MIT Press, 2018: 2845-2855

[13]Zhang Ruixiang, Che Tong, Ghahramani Z, et al.Metagan: An adversarial approach to few-shot learning[C]//Proc of the Conf and Workshop on Neural Information Processing Systems.Cambridge, MA: MIT Press, 2018: 2365-2374

[14]Zhang Hongguang, Zhang Jing, Koniusz P.Few-shot learning via saliency-guided hallucination of samples[C]//Proc of the IEEE Conf on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE, 2019: 2770-2779

[15]Koch G, Zemel R, Salakhutdinov R.Siamese neural networks for one-shot image recognition[C/OL]//Proc of ICML Deep Learning Workshop.New York: ACM, 2015[2021-08-26].https://www.cs.cmu.edu/~rsalakhu/papers/oneshot1.pdf

[16]Santoro A, Bartunov S, Botvinick M, et al.Meta-learning with memory-augmented neural networks[C]//Proc of the Int Conf on Machine Learning.New York: ACM, 2016: 1842-1850

[17]Snell J, Swersky K, Zemel R.Prototypical networks for few-shot learning[C]//Proc of the Advances in Neural Information Processing Systems.Cambridge, MA: MIT Press, 2017: 4077-4087

[18]Sung F, YangYongxin, Zhang Li, et al.Learning to compare: Relation network for few-shot learning[C]//Proc of the IEEE Conf on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE, 2018: 1199-1208

[19]Garcia V, Bruna J.Few-shot learning with graph neural networks[J].arXiv preprint arXiv:1711.04043, 2017

[20]Kim J, Kim T, Kim S, et al.Edge-labeling graph neural network for few-shot learning[C]//Proc of the IEEE Conf on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE, 2019: 11-20

[21]Yao Huaxiu, Zhang Chuxu, Wei Ying, et al.Graph few-shot learning via knowledge transfer[C]//Proc of the AAAI Conf on Artificial Intelligence.Palo Alto, CA: AAAI, 2020: 6656-6663

[22]Sutskever I, Martens J, Dahl G, et al.On the importance of initialization and momentum in deep learning[C]//Proc of the Int Conf on Machine Learning.New York: ACM, 2013: 1139-1147

[23]Kingma D P, Ba J.Adam: A method for stochastic optimization[J].arXiv preprint arXiv:1412.6980, 2014

[24]Ravi S, Larochelle H.Optimization as a model for few-shot learning[C/OL]//Proc of the Int Conf on Learning Representations.OpenReview.net, 2017[2021-08-26].https://openreview.net/pdf?id=rJY0-Kcll

[25]Li Zhenguo, Zhou Fengwei, Chen Fei, et al.Meta-sgd: Learning to learn quickly for few-shot learning[J].arXiv preprint arXiv:1707.09835, 2017

[26]Hjelm R D, Fedorov A, Lavoie-Marchildon S, et al.Learning deep representations by mutual information estimation and maximization[C/OL]//Proc of the Int Conf on Learning Representations.OpenReview.net, 2019[2021-08-26].https://openreview.net/pdf?id=Bklr3j0cKX

[27]Oord A, Li Yazhe, Vinyals O.Representation learning with contrastive predictive coding[J].arXiv preprint arXiv:1807.03748, 2018

[28]Bachman P, Hjelm R D, Buchwalter W.Learning representations by maximizing mutual information across views[C]//Proc of the Conf and Workshop on Neural Information Processing Systems.Cambridge, MA: MIT Press, 2019: 15509-15519

[29]Kong Lingpeng, d’Autume C D M, Wang Ling, et al.A mutual information maximization perspective of language representation learning[J].arXiv preprint arXiv:1910.08350, 2019

[30]Velickovic P, Fedus W, Hamilton W L, et al.Deep graph infomax[C/OL]//Proc of the Int Conf on Learning Representations(Poster).OpenReview.net, 2019[2021-08-26].https://openreview.net/pdf?id=rklz9iAcKQ

[31]Tian Yonglong, Krishnan D, Isola P.Contrastive multiview coding[C]//Proc of the European Conf on Computer Vision.Piscataway, NJ: IEEE, 2020: 776-794

[32]He Kaiming, Fan Haoqi, Wu Yuxin, et al.Momentum contrast for unsupervised visual representation learning[C]//Proc of the IEEE Conf on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE, 2020: 9729-9738

[33]Chen Ting, Kornblith S, Norouzi M, et al.A simple framework for contrastive learning of visual representations[C]//Proc of the Int Conf on Machine Learning.New York: ACM, 2020: 1597-1607

[34]Tian Yonglong, Sun Chen, Poole B, et al.What makes for good views for contrastive learning[C]//Proc of the Conf and Workshop on Neural Information Processing Systems.Cambridge, MA: MIT Press, 2020: 6827-6839

[35]Grill J B, Strub F, Altche F, et al.Bootstrap your own latent: A new approach to self-supervised learning[J].arXiv preprint arXiv:2006.07733, 2020

[36]Qiu Jiezhong, Chen Qibin, Dong Yuxiao, et al.Gcc: Graph contrastive coding for graph neural network pre-training[C]//Proc of the ACM SIGKDD Int Conf on Knowledge Discovery & Data Mining.New York: ACM, 2020: 1150-1160

[37]You Yuning, Chen Tianlong, Sui Yongduo, et al.Graph contrastive learning with augmentations[C]//Proc of the Conf and Workshop on Neural Information Processing Systems.Cambridge, MA: MIT Press, 2020: 5812-5823

[38]Khosla A, Jayadevaprakash N, Yao Bangpeng, et al.Novel dataset for fine-grained image categorization: Stanford dogs[C/OL]//Proc of CVPR Workshop on Fine-Grained Visual Categorization(FGVC).Piscataway, NJ: IEEE, 2011[2021-08-26].https://people.csail.mit.edu/khosla/papers/fgvc2011.pdf

[39]Wah C, Branson S,Welinder P, et al.The Caltech-UCSD Birds-200-2011 Dataset[J/OL].Computation & Neural Systems Technical Report, CNS-TR-2011-001.[2021-08-26].http://www.vision.caltech.edu/visipedia/papers/CUB_200_2011.pdf

[40]Mishra N, Rohaninejad M, Chen Xi, et al.A simple neural attentive meta-learner[C/OL]//Proc of the Int Conf on Learning Representations.OpenReview.net, 2018.[2021-08-26].https://openreview.net/pdf?id=B1DmUzWAW

[41]Li Wenbin, Wang Lei, Xu Jinglin, et al.Revisiting local descriptor based image-to-class measure for few-shot learning[C]//Proc of the IEEE Conf on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE, 2019: 7260-7268

[42]Simon C, Koniusz P, Nock R, et al.Adaptive subspaces for few-shot learning[C]//Proc of the IEEE Conf on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE, 2020: 4136-4145

[43]Baik S, Hong S, Lee K M.Learning to Forget for Meta-Learning[C]//Proc of the IEEE Conf on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE, 2020: 2379-2387

[44]Oh J, Yoo H, Kim C H, et al.BOIL: Towards representation change for few-shot learning[C/OL]//Proc of the Int Conf on Learning Representations.OpenReview.net, 2021[2021-08-26].https://openreview.net/pdf?id=umIdUL8rMH

[45]Wei Xiushen, Wang Peng, Liu Lingqiao, et al.Piecewise classifier mappings: Learning fine-grained learners for novel categories with few examples[J].IEEE Transactions on Image Precessing, 2019, 28(12): 6116-6125

[46]Xue Zhiyu, Duan Lixin, Li Wen, et al.Region comparison network for interpretable few-shot image classification[J].arXiv preprint arXiv: 2009.03558, 2020