伴随着过去10年浪潮,人工智能发展方兴未艾,正处于由感知智能到认知智能转变的关键时期.知识图谱作为大数据时代的知识工程集大成者,是符号主义与连接主义相结合的产物,是实现认知智能的基石.知识图谱以其强大的语义表达能力、存储能力和推理能力,为互联网时代的数据知识化组织和智能应用提供了有效的解决方案.因此,新一代知识图谱的关键技术研究逐渐受到来自工业界和学术界的广泛关注.

知识图谱最早于2012年由Google正式提出[1],其初衷是为了改善搜索,提升用户搜索体验.知识图谱至今没有统一的定义,在维基百科中的定义为:“Google知识图谱(Google knowledge graph)是Google的一个知识库,其使用语义检索从多种来源收集信息,以提高Google搜索的质量.”从当前知识图谱的发展看来,此定义显然是不够全面的,当前知识图谱的应用俨然远超其最初始的搜索场景,已经广泛应用于搜索、问答、推荐等场景中.比较普遍被接受的一种定义为“知识图谱本质上是一种语义网络(semantic network),网络中的结点代表实体(entity)或者概念(concept),边代表实体/概念之间的各种语义关系”.一种更为宽泛的定义为“使用图(graph)作为媒介来组织与利用不同类型的大规模数据,并表达明确的通用或领域知识”.从覆盖的领域来看,知识图谱可以分为通用知识图谱和行业知识图谱;前者面向开放领域,而后者则面向特定的行业.随着知识图谱在各行业的应用落地,知识图谱技术的相关研究得到了大量研究者的关注.以知识图谱为基础的典型应用也逐渐走进各个行业领域,包括智能问答、推荐系统、个人助手、战场指挥系统等.

传统的知识图谱研究领域主要围绕传统的数据存储、知识获取、本体融合、逻辑推理以及知识图谱应用等方面.文献[2]详细综合和分析了知识图谱存储管理最新的研究进展.文献[3]从知识表示学习、知识获取与知识补全、时态知识图谱和知识图谱应用等方面进行了全面的综述.文献[4]则重点对面向知识图谱的知识推理相关研究进行了综述.

然而,在大数据环境和新基建背景下,数据对象和交互方式的日益丰富和变化,对新一代知识图谱在基础理论和关键技术等方面提出新的需求,也带来新的挑战.和已有的知识图谱研究综述相比,本文将从众多最新的知识图谱研究方法中,对3方面的新一代知识图谱关键技术和理论做分析:

1) 非结构化多模态数据组织与理解;

2) 大规模动态图谱表示学习与预训练模型;

3) 神经符号结合的知识更新与推理.

本文将综述国内外新一代知识图谱关键技术研究发展现状,对国内外研究的最新进展进行归纳、比较和分析,就未来的技术挑战和研究方向进行展望.

1 非结构化多模态数据组织与理解

1.1 非结构化多模态数据组织

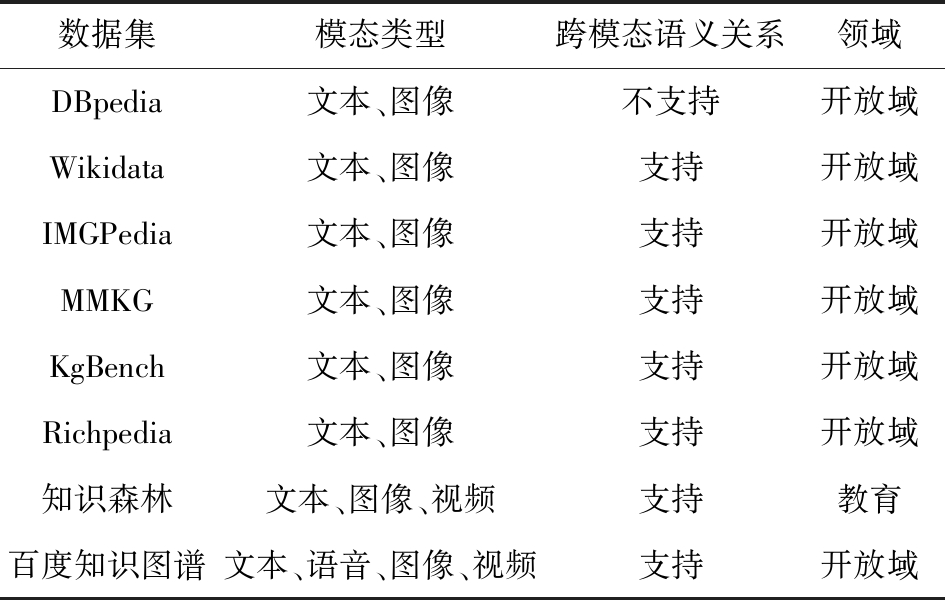

“模态”的定义较多,可以直观地理解为不同类型的多媒体数据,也可以作为一个更加细粒度的概念,区分模态的关键点可以理解为数据是否具有异构性.例如,对于某个歌手,互联网上可以找到他的照片和歌曲视频,同时也有相关的文本信息(百科、新闻等)以及具体的歌曲音频.图片、视频、文本、语音这4种数据,可以被理解为该对象的多模态数据.目前主要的非结构化多模态知识图谱如表1所示:

Table 1 Multi-Modal Knowledge Graphs

表1 多模态知识图谱

数据集模态类型跨模态语义关系领域DBpedia文本、图像不支持开放域Wikidata文本、图像支持开放域IMGPedia文本、图像支持开放域MMKG文本、图像支持开放域KgBench文本、图像支持开放域Richpedia文本、图像支持开放域知识森林文本、图像、视频支持教育百度知识图谱文本、语音、图像、视频支持开放域

DBpedia[5]作为近10年来知识图谱研究领域的核心数据集,其丰富的语义信息中也包含了大量的非结构化数据,如文本描述和实体图片.目前DBpedia包含了超过260万个实体,且每个实体具有唯一的全局标识符.以此为基础,越来越多的数据发布者将自己的数据通过SameAs关系链接到DBpedia资源,使DBpedia一定程度上成为多类型数据组织的中心.目前,围绕DBpedia的互联网数据源网络提供了约47亿条信息,涵盖地理信息、人、基因、药物、图书、科技出版社等多个领域.

Wikidata[6]中也存在大量的多模态数据资源,它是维基媒体基金会(Wikimedia Foundation)推出的知识图谱,也是维基媒体数据组织和管理的核心项目.Wikidata充分利用了知识图谱的图数据模型,综合了Wikivoyage,Wiktionary,Wikisource等各类结构化和非结构化数据,其目标是通过创造维基百科全球管理数据的新方法来克服多类数据的不一致性,已经成为维基媒体最活跃的项目之一,越来越多的网站都从Wikidata获取内容以嵌入提供的页面浏览服务.

IMGPedia[7]是多模态知识图谱的早期尝试.相较于DBpedia和Wikidata,其更关注在已有的知识图谱中补充非结构化的图片信息.IMGPedia的核心思路是首先提取Wikimedia Commons中的多媒体资源(主要是图片),然后基于多媒体内容生成特征用于视觉相似性的计算,最后通过定义相似关系的方式将图片内容信息引入到知识图谱中,此外其还链接了DBpedia和DBpedia Commons来提供上下文和元数据.IMGPedia的优势在于开创性地定义了知识图谱中图像内容的“描述符”,也就是视觉实体属性(诸如灰度等),同时根据这些描述符去计算图片相似度,方便人们进行相似图片的查找.但IMGPedia中定义的“描述符”种类较少,且图片之间的关系单一.

MMKG[8]项目旨在对不同知识图谱(Freebase,YAGO,DBpedia)的实体和图片资源进行对齐.其通过对3个知识图谱(Freebase15k,YAGO15k,DB15k,均为从原始的知识图谱中获得的知识图谱子集)进行实体对齐,以及数值、图片资源与实体的绑定,构建了一个包含3个知识图谱子集的多模态数据集合.MMKG包含的3个知识图谱既有诸多对齐的实体,又有各自不同的拓扑结构.值得一提的是,MMKG的目标并非是提供一个多模态知识图谱,而是定义一个包含多模态信息的评估知识图谱实体对齐技术的基准数据集.但是其本质上还是以传统的知识图谱为主,规模很小同时也没有充分收集和挖掘互联网上多种类型的多模态数据,在将图像分发给相关文本实体时也未曾考虑图像的多样性.

KgBench[9]和MMKG类似,在RDF编码的知识图谱上引入了一组新的实体分类基准多模态数据集.对于多个知识图谱基准实体分类任务,提供至少1 000个实例的测试和验证集,有些实例超过10 000个,每个实例包含了多种模态的数据描述和特征.每个任务都能够以知识图谱结构特征进行评估,或者使用多模态信息来实验.所有数据集都以CSV格式打包,并提供RDF格式的源数据和源代码.

东南大学的Wang等人[10]提出的多模态图谱Richpedia,是目前国内在多模态知识图谱领域的代表工作.其核心思路延续了知识图谱的基本数据模型,在RDF框架下对现有的知识图谱进行扩充(主要是包含视觉信息的图片实体),使其变为多模态知识图谱.相较之前的多模态知识图谱,该工作的最大贡献在于收集与实体相关图片的同时,利用图片的配文来识别图片中所包含的其他实体,进而在跨模态实体之间的语义关系发现方面取得了显著效果提升.

西安交通大学的郑庆华等人[11-12]提出了知识森林的概念,旨在针对智慧教育领域的多模态数据,实现基于知识森林数据模型的组织与个性化导学.知识森林的特点在于针对教育领域的垂域特点,用自然语言处理、图像识别等人工智能技术突破了教育领域给定课程科目的知识森林自动构建,研制了知识森林AR交互系统,缓解学习过程中人机可视化交互难题.知识森林的多模态类型不再局限于文本和图像的范畴,增加了与视频数据交互的能力.

百度知识图谱近年来也逐渐向多模态知识图谱演变.基于海量互联网资源,百度构建了超大规模的通用知识图谱,并随着文本、语音、视觉等智能技术的不断深入,以及行业智能化诉求的提升,百度近年来一直致力于知识图谱在复杂知识表示、多模态语义理解、行业图谱构建和应用,其挖掘的多模态知识在图文视频的基础上,加入了更多语音数据来丰富多模态知识图谱的内容.

1.2 多模态数据理解

多模态数据理解旨在实现处理和理解不同模态信息之间共同表达语义的能力.整体上,和知识图谱相关的多模态数据的理解主要分为基于本体的多模态语义理解和基于机器学习的多模态语义理解.基于本体的多模态语义理解是比较早期的工作,均和知识图谱相关,其主要活跃于深度学习的浪潮兴起之前,代表性的工作为LSCOM(large-scale concept ontology for multimedia)[13]和COMM(core ontology for multimedia)[14].

LSCOM[13]是一个由IBM、卡内基梅隆大学(Carnegie Mellon University, CMU)和哥伦比亚大学领导开发的多模态大规模概念本体协作编辑任务.在这项工作中,CyC公司与很多学术研究和工业团体均有参与.其整个过程包含了一系列学术研讨会,来自多个领域的专家聚集在一起,创建了描述广播新闻视频的1 000个概念的分类.LSCOM中对多模态数据的实用性、覆盖率、可行性和可观察性制定了多个标准.除了对1 000个概念进行分类外,LSCOM还生成了一组用例和查询,以及广播新闻视频的大型注释数据集.

COMM[14]是由德国、荷兰以及葡萄牙的研究团队联合推出的多模态本体,其诞生的主要动机在于LSCOM为多模态数据语义分析研究创建了一个统一的框架,但并没有一个高质量的多模态本体正式描述,也缺乏与已有的语义Web技术兼容.针对此问题,COMM定义了一个基于MPEG-7的多模态本体,由多模态数据模式组成,满足了本体框架的基本要求,并且在OWL DL中完全形式化.基于本体的多模态语义理解要求高质量的本体编辑以及精细粒度的数据描述,因此COMM和LSCOM并没有很好地发展起来.

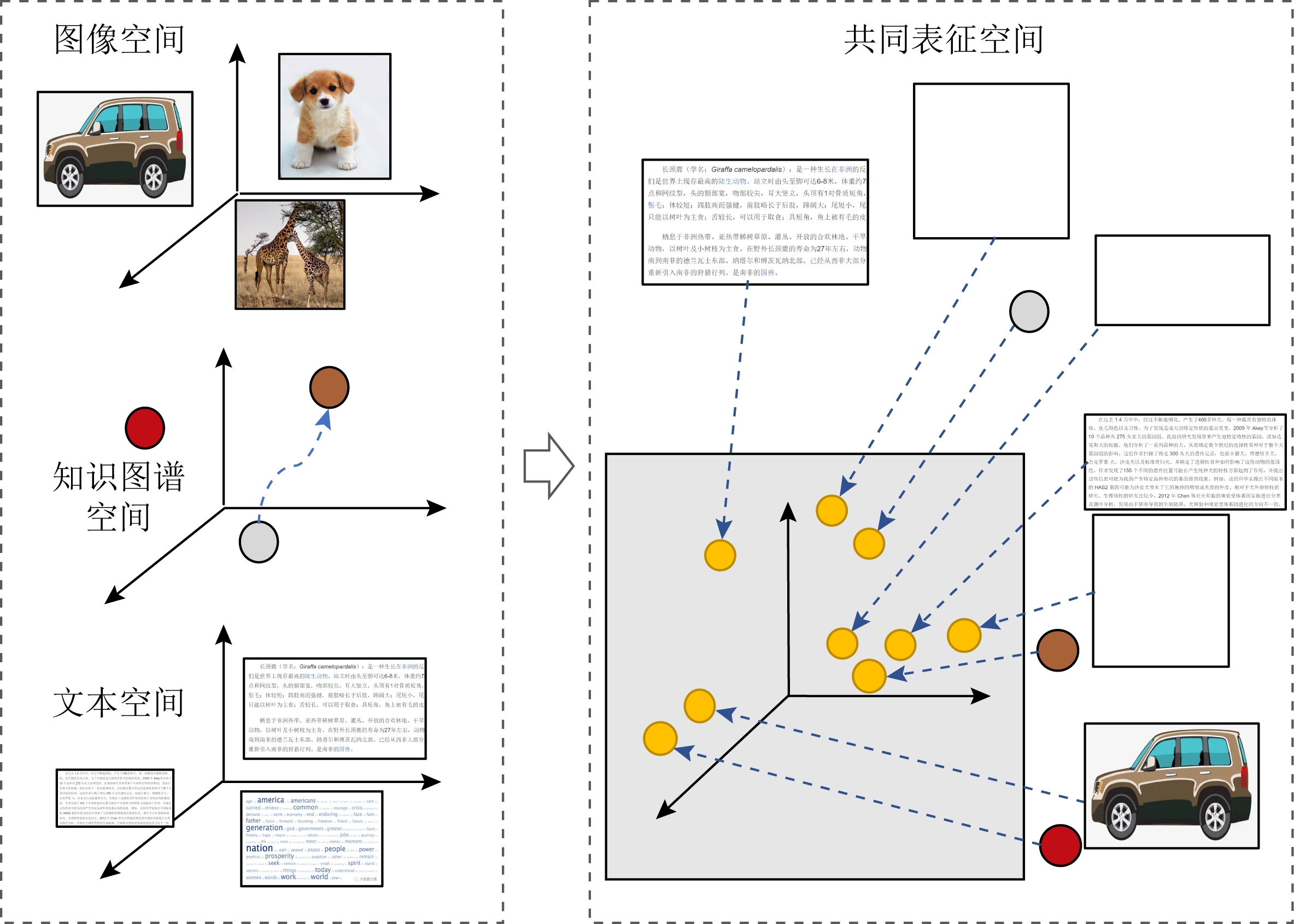

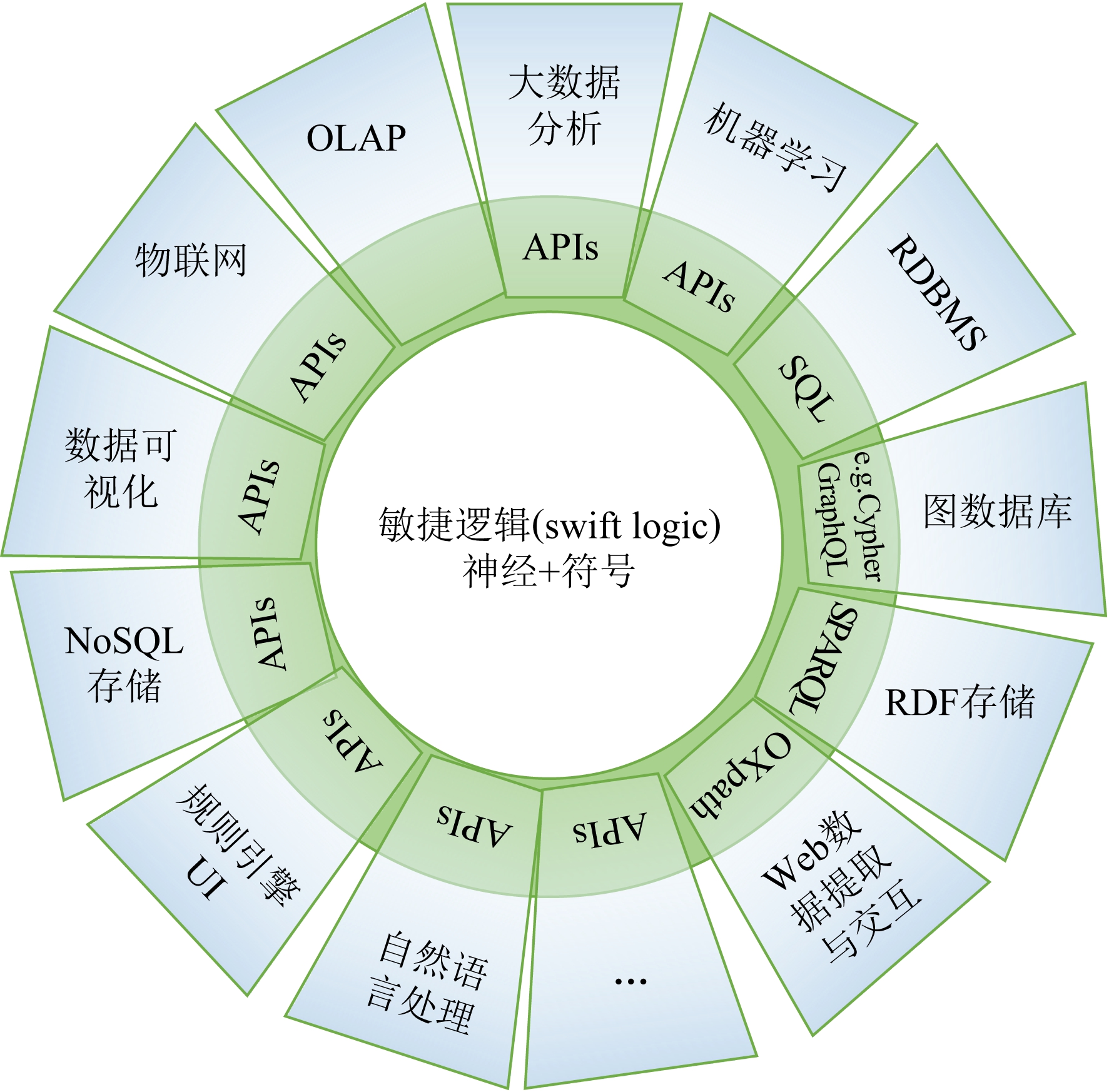

基于机器学习的多模态语义理解[15]是目前多模态数据理解的主流方法,和知识图谱的联系主要是利用多模态表示学习方法实现知识补全或应用到下游任务中.多模态表示学习是指通过利用不同多模态数据之间的互补性,剔除模态冗余性,从而将多模态数据的语义表征为实值向量,该实值向量蕴含了不同模态数据的共同语义和各自特有的特征,如图1所示.代表性的工作如Srivastava等人[16]通过深度玻尔兹曼机实现图像和文本的联合空间生成,在此基础上实现多模态数据的统一表示.

Fig. 1 Multi-modal representation learning

图1 多模态表示学习

多模态知识图谱表示学习的代表性工作是Mousselly-Sergieh等人[17]将视觉特征、文本特征和知识图谱的结构特征共同学习成统一的知识嵌入,在此过程中使用Simple Concatenation,DeViSE,Imagined这3种不同的方法来集成多模态信息,最终实现了知识图谱的多模态表示学习,生成了蕴含多种模态特征的知识图谱实体和关系实值向量,相较于传统的基于结构的知识图谱表示学习,其在链接预测和实体分类任务上的效果均有提升.

GAIA[18]是最近提出的一个细粒度的多模态知识抽取、理解和组织框架,旨在提取不同来源的异构多媒体数据(包括多模态、多语言等),生成连续的结构化知识,同时提供一个丰富的细粒度的多模态数据描述本体.GAIA整个系统主要有3个优势:1)大量使用计算机视觉和自然语言处理的深度学习框架和其他知识图谱算法作为其底层模块,通过结合不同领域的技术实现了特别是对于图片资源的实体识别和多模态实体链接,相较于之前的IMGPedia,这样的处理保证了对图片内容细粒度识别的进一步深入,而对于文本资源,也实现了实体识别和关系抽取.2)相较于粗粒度的实体,细粒度可以保证内容查询的灵活性和更强的易用性,例如对场景的理解和事件预测,故可以更广泛地用于实际应用中.3)通过将图片和文本实体进行实体链接、关系抽取等处理,实现了多模态知识融合和知识推理,充分利用了多模态的优势.GAIA所提出的多模态知识图谱提取框架是当前比较全面的一种范式,有着较好的借鉴意义.

北京大学的Peng等人[19]提出了跨媒体智能的概念,该概念和多模态数据理解的思路类似,其借鉴人脑跨越视觉、听觉、语言等不同感官信息认知外部世界的特性,重点研究了跨媒体分析推理技术中的任务和目标,包括细粒度图像分类、跨媒体检索、文本生成图像、视频描述生成等.其代表性的工作为PKU FG-Xmedia[20],是第1个包含4种媒体类型(图像、文本、视频和音频)的细粒度跨媒体检索公开数据集和评测基准,并且在此基础上提出了能够同时学习4种媒体统一表征的深度网络模型FGCrossNet.

中国科学院自动化研究所的张莹莹等人[21]提出了一个基于多模态知识感知注意力机制的问答模型.该模型首先学习知识图谱中实体的多模态表示;然后从多模态知识图谱中与问答对相关联的实体的路径来推测出回答该问题时的逻辑,并刻画问答对之间的交互关系.此外,该模型还提出了一种注意力机制来判别连接问答对的不同路径之间的重要性.

清华大学的Liu等人[22]最早在多模态知识图谱表示学习方面开展了研究,代表性的工作是IKRL,其将视觉特征和知识图谱的结构特征进行联合表示学习,进而通过不同模态信息之间的约束生成质量更高的知识图谱嵌入.

华南理工大学的Cai等人[23]提出一种结合图像信息和文本信息的神经网络来对Twitter等短文本中的实体进行识别和消歧.其核心思想是将视觉和文本信息通过表示学习生成的嵌入连接起来,并且为细粒度的信息交互引入了共同关注机制.在Twitter数据集上的实验结果表明,其方法优于单纯依赖文本信息的方法.

中国科学技术大学的Xu等人[24]在多模态信息理解与关联方面探索了如何有效联合映射与建模跨模态信息,进而从视频概括性描述深入至实体间语义关系,实现视觉元素多层次、多维度语义理解与关联,以形成对视频等多模态内容更为全面的解析,有效解读其中的语义信息,进而为支撑面向多模态内容的智能应用服务奠定重要基础.其代表性的工作为MMEA[24],针对多模态知识图谱的实体对齐问题,设计了一种多视图知识嵌入方法,实现多模态知识图谱实体对齐效果的提升.

国防科技大学的Zhao等人[25]在多模态知识图谱的实体对齐任务上进一步进行了探索,其主要将多模态实体对齐任务从欧氏空间拓展到了双曲空间进行建模表示,最终利用双曲空间内的图卷积网络和视觉特征抽取模型DENSENET实现了多个数据集上的实体对齐效果.

2 大规模动态图谱表示学习与预训练模型

2.1 大规模动态表示学习

知识图谱的本质是一种语义网络,亦是一种特殊的图.动态知识图谱同样是一种特殊的动态图.但是因为知识图谱的特殊性,动态知识图谱可以被分为2类:一类是时序动态知识图谱,其中蕴含着时间特征,知识图谱的结构、实体和关系都会随着时间的推移发生改变;另一类是非时序动态知识图谱,这类知识图谱中没有显式的时间特征,但是知识图谱会发生更新,有新的实体和关系添加到原有的知识图谱中.一般情况来说,已存在知识图谱中的实体和关系不会发生改变.

1) 时序的动态知识图谱表示学习

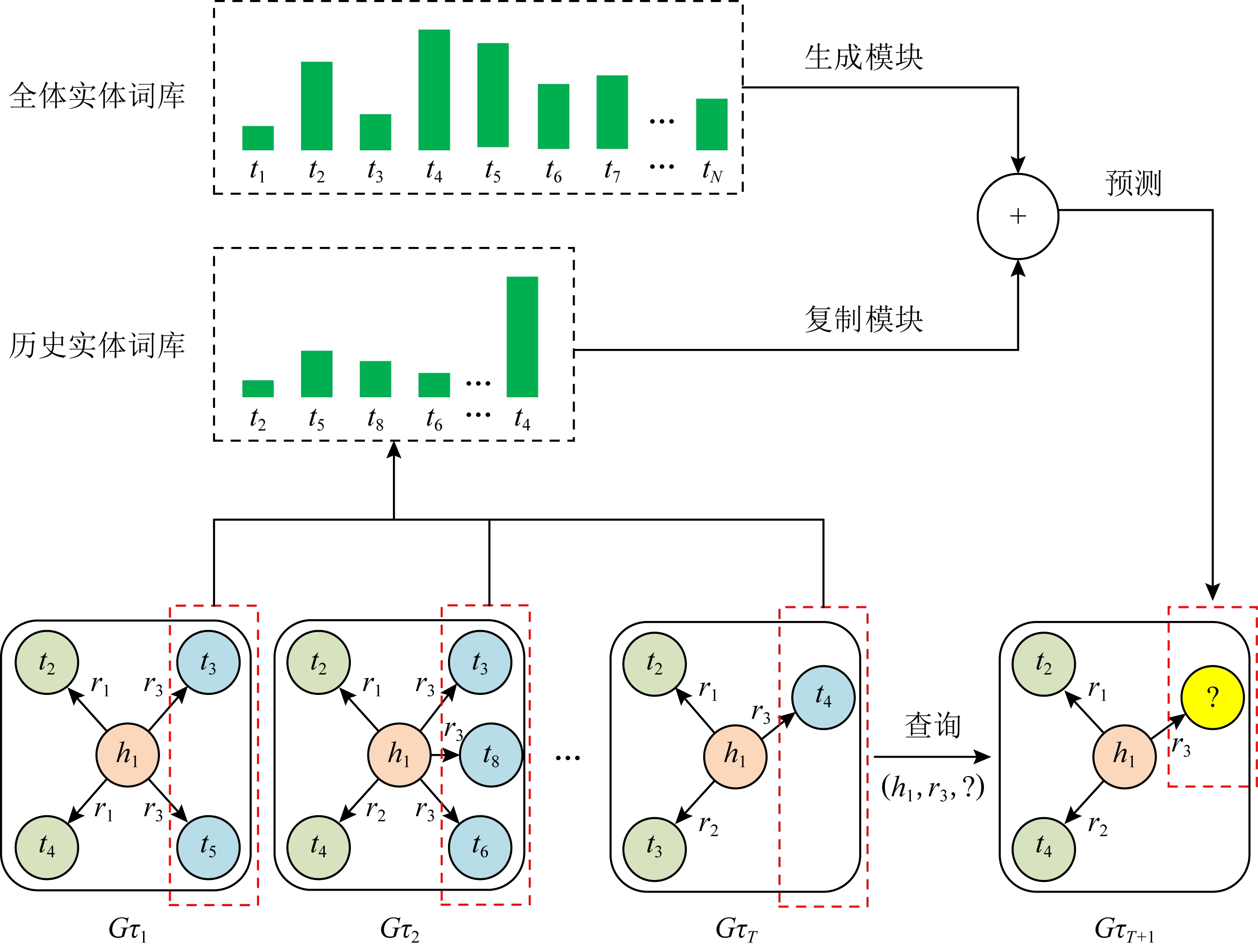

时序知识图谱是一种特殊的知识图谱,其相比传统的静态知识图谱多了时间信息,知识图谱中的知识不是静态不变的,反而是因为时间的变化,知识三元组发生改变.如表2中所总结,我们根据其对时间信息处理方式的差异将所有算法模型分为三大类:具有时间约束的历时性时序知识图谱表示模型、基于时间序列编码的时序知识图谱表示模型和基于路径推理的时序知识图谱表示模型.其中在各通用数据上表现最佳的模型为2021年Zhu等人[26]提出的CyGNet,其模型结构如图2所示.

Table 2 Features Comparison of the Dynamic Knowledge Graph Representation Learning

表2 时序知识图谱表示学习的特点比较

时序知识图谱表示类别表示学习模型(提出年份)特性性能创新点不足MRR∕%Hits@10∕%具有时间约束的历时性时序知识图谱表示模型TTransE[27](2018)在TransE模型的基础上利用时间信息对三元组进行约束,采用关系时间合并的方式对时间点进行嵌入表示.关系时间合并的方法无法对连续时间点的关系进行有效区分,增加关系类别数量导致标注样本稀疏;直接对时间信息进行编码不足以获得时间的有效特征.32.5753.37ATiSE[28](2019)充分挖掘时间对实体演化的影响,不仅包含过去时间的影响,还通过时间序列的趋势、周期和随机性挖掘未来时间对实体的影响.模型需从时间序列的趋势、周期和随机性中挖掘时间对实体的影响,因此仅对随时间变化实体改变明显的数据集有较好的效果,即针对时间尺度较大的数据集效果一般.17.028.8ETA-TransE[29](2020)在TransE模型的基础上,根据应用场景时间粒度的差异构建了一个时间转移矩阵,可以区分同一时间对不同类型实体的影响.模型使用的基础模型是TransE,其仅为同类方法最基础的模型,本身具有无法对一对多关系进行建模等问题.25.7(头实体预测)41.1(尾实体预测)CyGNet[26](2020)模型通过设计特殊的复制模块对知识的历史信息进行利用;同时设计生成模块对首次出现的知识进行预测.模型针对头实体预测和尾实体预测效果存在较为明显差异,对于尾实体预测结果远远优于头实体预测,即模型针对头实体预测略有劣势.63.4768.95基于时间序列编码的时序知识图谱表示模型Know-Evolve[30](2017)模型在静态图谱表示的基础上通过构建一个RNN网络来更新实体受时间变化影响后的嵌入表示.模型针对同一时间上的实体或事件建模存在一定冲突,并且通过RNN更新实体表示并没有捕获到时序依赖关系,因此对未来时间的事件或实体预测存在极大误差.6.1911.48RE-NET[31](2019)将时间信息转换为具有时间信息的事件(三元组)序列,构建基于RNN对序列中的实体进行编码,捕获其历史信息对其的影响;最后使用RGCN网络来聚合同一时间内实体的信息.模型因使用RGCN来聚合实体信息,其复杂度随着知识图谱关系数量的增加而急剧增大,因此RE-NET在运行时间上要远多于其他模型.65.1668.08基于路径推理的时序知识图谱表示模型Chang2vec[32](2019)将时序知识图谱按照时间节点拆分为多个静态知识图谱,针对每个知识图谱采用元路径编码的方式对有变化的节点实体表示进行重新计算并更新其嵌入表示.模型依赖知识图谱的结构特征,通过边(关系)变化来更新节点(实体)的嵌入表示,并没有着重关注边(关系)的特征,因此针对关系种类少的知识图谱效果更佳.xERTE[33](2020)模型结合低维静态向量和时间函数用以对实体进行嵌入表示,不仅可以表示实体不随时间变化的长期属性和受时间影响的变化特征;同时,模型可以对推理进行可解释性的可视化展示推理路径.模型可在大规模百万条边的动态知识图谱上进行推理应用.模型方法针对时间尺度小的数据集提升明显,效果极佳;在时间尺度大的Yago数据集效果一般,不能更好地完成推理,仅可以对推理进行可解释性的可视化展示.53.62

2) 非时序的动态知识图谱表示学习

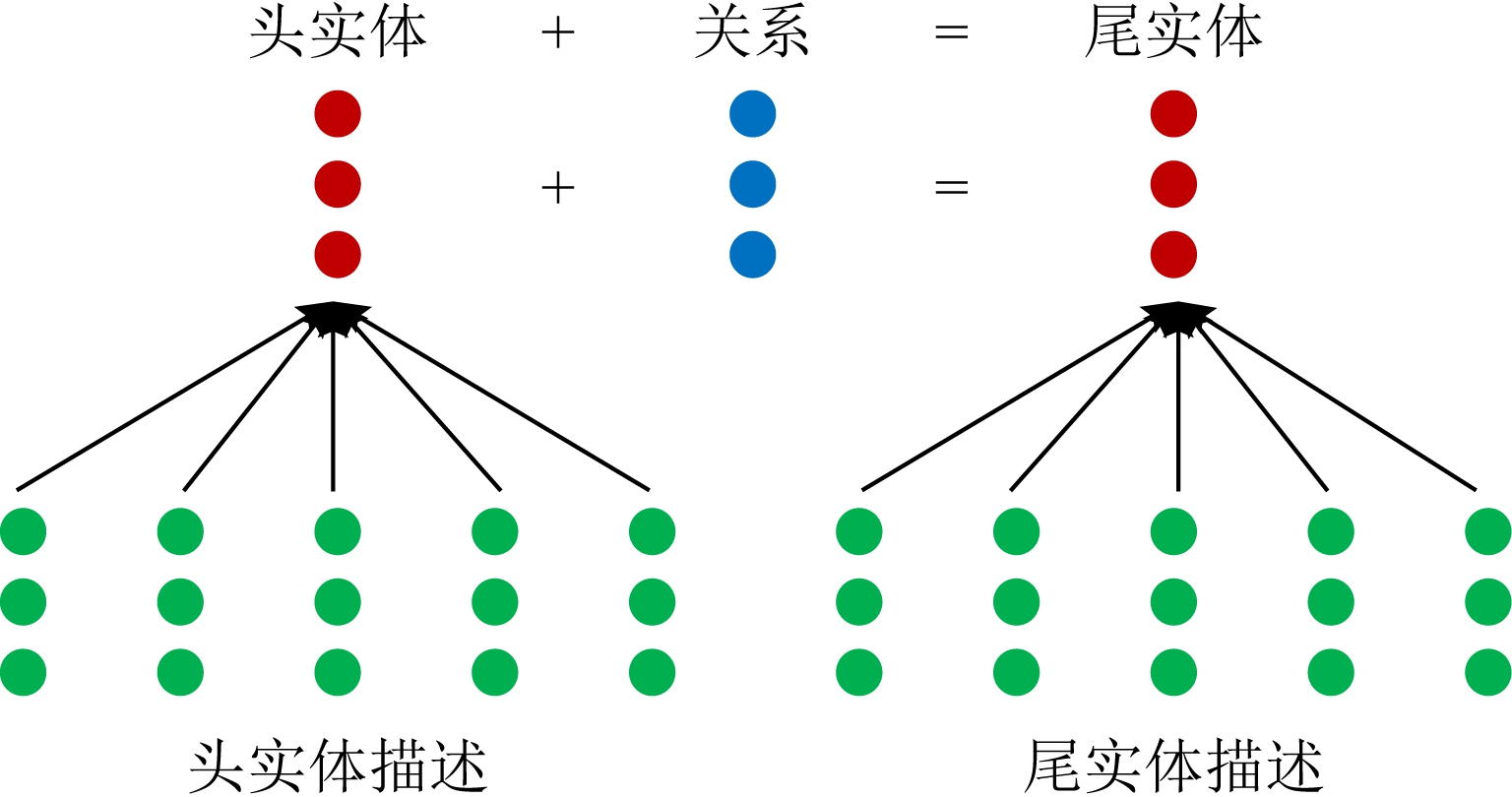

对于非时序动态知识图谱,其在应用和更新过程中,可以加入新的实体和关系,新实体与原有实体构成的三元组只要在现实应用场景下为正确的,则可将此三元组纳入到原有的知识图谱中.所以非时序动态知识图谱的规模是可以随着现实情况不断增大的,被认为是一种动态变化的知识图谱.针对非时序知识图谱,其中最初的模型是在原有的DKRL模型[34]上进行简单的更改,直接应用于开放世界知识图谱上,其效果相比其他静态的算法有所提高,成为了这个任务的一个基准结果,其模型基础框架如图3所示.DKRL的优势不仅在于提升了实体表示的区分能力,而且更在于其对新实体的表示,当一个未在知识图谱中出现的新实体出现时,DKRL将根据新实体的简短描述生成它的表示,用于知识图谱补全.

Fig. 2 Framework of CyGNet model

图2 CyGNet模型结构图

Fig. 3 Framework of DKRL model

图3 DKRL模型结构图

Shi等人[35]提出了一种以文本为中心的表示方法ConMask,其中头实体、关系和尾实体基于文本的向量表示是通过注意力模型在名称和描述上得出的,并且通过全卷积神经网络(fully convolutional neural network)得到三元组的评分,最后通过评分完成实体与关系的预测.

Shah等人[36]提出了区别于DKRL和ConMask这2种方法的新模型OWE,其独立地训练知识图谱和文本向量,然后通过缺失实体的描述文本向量模糊代替实体的表示,在知识图谱中进行匹配,最终得到实体与关系的预测结果.该模型可以调整和选用不同的基础知识图谱表示模型得到不同的融合模型,在不同环境任务中发挥更好的作用.

Wang等人[37]提出了一种基于胶囊网络的新模型Caps-OWKG,其在融合知识图谱的结构信息和描述信息后,采用胶囊网络提取三元组的特征,得到动态非时序知识图谱三元组的表示.Gaur等人[38]提出了一个框架HUKA,它使用起源多项式通过编码生成答案所涉及的边来跟踪知识图谱上查询结果的推导.

Das等人[39]证明了基于案例的推理(case-based reasoning, CBR)系统通过检索与给定问题相似的“案例”来解决一个新问题是可以实现动态知识库(KBs).其通过收集知识库中相似实体的推理路径来预测实体的属性.概率模型估计路径在回答关于给定实体的查询时有效的可能性.

在国内,最初的模型是在Xie等人[34]提出的DKRL模型上进行简单的更改,直接应用于开放世界知识图谱上,其效果相比其他静态的算法有所提高,成为了这个任务的一个基准结果.

杜治娟等人[40]提出一种表示学习方法TransNS.其选取相关的邻居作为实体的属性来推断新实体,并在学习阶段利用实体之间的语义亲和力选择负例三元组来增强语义交互能力.

Xie等人[41]提出了一种基于深度递归神经网络DKGC-JSTD的动态知识图谱补全模型.该模型学习实体名称及其部分文本描述的嵌入,将看不见的实体连接到知识图谱.为了建立文本描述信息与拓扑信息之间的相关性,DKGC-JSTD采用深度记忆网络和关联匹配机制,从实体文本描述中提取实体与关系之间的相关语义特征信息.然后利用深度递归神经网络对拓扑结构与文本描述之间的依赖关系进行建模.

Zhou等人[42]提出了一种聚合器,采用注意网络来获取实体描述中单词的权重.这样既不打乱词嵌入中的信息,又使聚合的单词嵌入更加高效.

Niu等人[43]使用多重交互注意(MIA)机制来模拟头部实体描述、头部实体名称、关系名称和候选尾部实体描述之间的交互,以形成丰富的表示.此外,还利用头部实体描述的额外文本特征来增强头部实体的表示,并在候选尾部实体之间应用注意机制来增强它们的表示.

2.2 知识图谱的预训练模型

知识广泛存在于文本、结构化及其他多种模态的数据中.除了通过抽取技术将知识从原始数据中萃取出来以支持搜索、问答、推理、分析等应用以外,另外一种思路是利用数据中本身存在的基本信号对隐藏的知识进行预训练.预训练的核心思想是“预训练和微调”,例如预训练一般包含2个步骤:首先利用大量的通用知识数据训练一个知识模型,获取文本中包含的通用知识信息;然后在下游任务微调阶段,针对不同下游任务,设计相应的目标函数,基于相对较少的监督数据进行微调,便可得到不错的效果.近2年对面向知识表示、面向自然语言、面向下游任务和基于图结构的预训练模型这4类有所进展,代表性模型如表3所示:

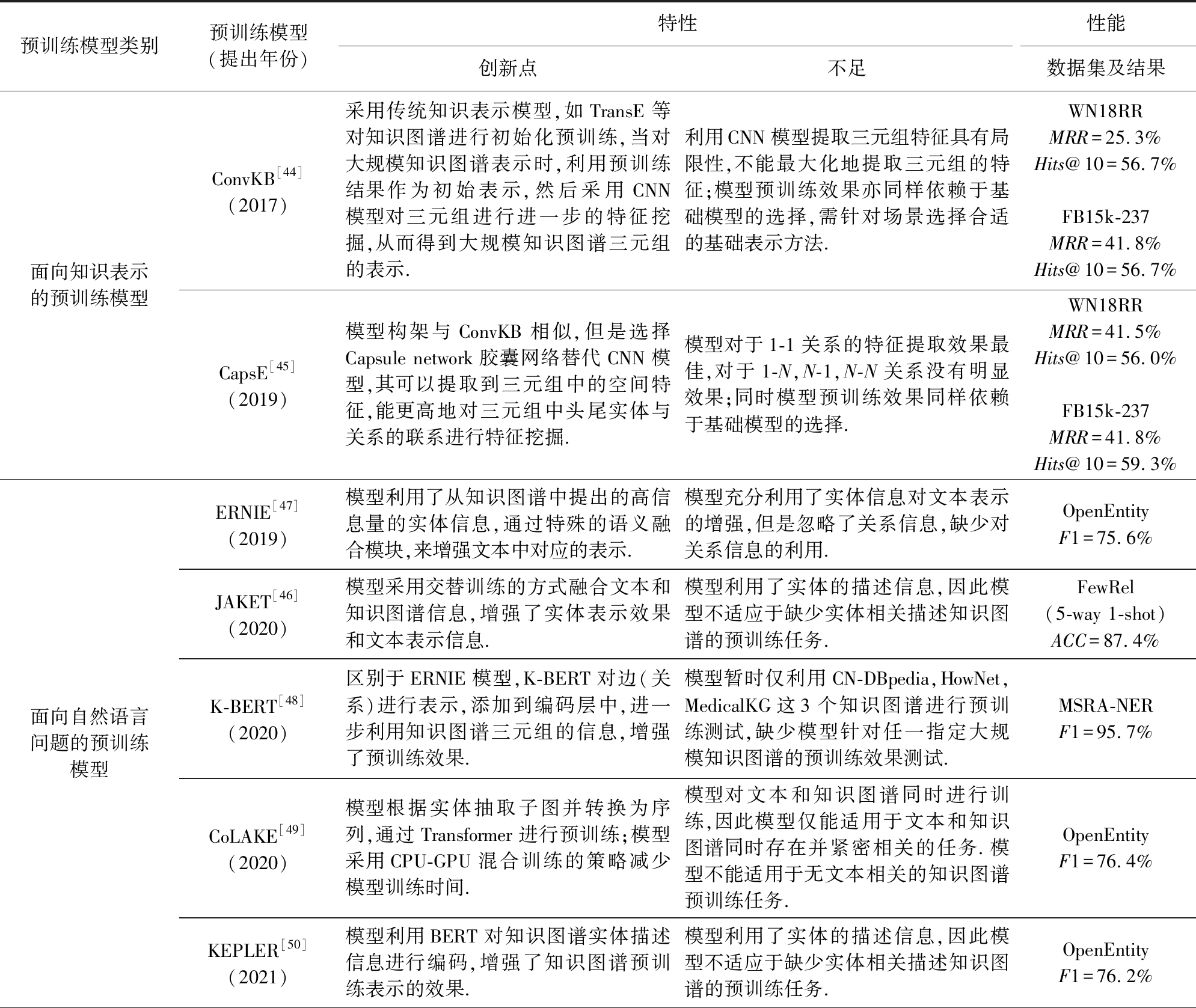

Table 3 Models and Their Characteristics of Knowledge Graph Pre-trained From 2019 to 2021

表3 2019—2021年知识图谱预训练的模型与特点

预训练模型类别预训练模型(提出年份)特性性能创新点不足数据集及结果面向知识表示的预训练模型ConvKB[44](2017)采用传统知识表示模型,如TransE等对知识图谱进行初始化预训练,当对大规模知识图谱表示时,利用预训练结果作为初始表示,然后采用CNN模型对三元组进行进一步的特征挖掘,从而得到大规模知识图谱三元组的表示.利用CNN模型提取三元组特征具有局限性,不能最大化地提取三元组的特征;模型预训练效果亦同样依赖于基础模型的选择,需针对场景选择合适的基础表示方法.WN18RRMRR=25.3%Hits@10=56.7%FB15k-237MRR=41.8%Hits@10=56.7%CapsE[45](2019)模型构架与ConvKB相似,但是选择Capsule network胶囊网络替代CNN模型,其可以提取到三元组中的空间特征,能更高地对三元组中头尾实体与关系的联系进行特征挖掘.模型对于1-1关系的特征提取效果最佳,对于1-N,N-1,N-N关系没有明显效果;同时模型预训练效果同样依赖于基础模型的选择.WN18RRMRR=41.5%Hits@10=56.0%FB15k-237MRR=41.8%Hits@10=59.3%面向自然语言问题的预训练模型ERNIE[47](2019)模型利用了从知识图谱中提出的高信息量的实体信息,通过特殊的语义融合模块,来增强文本中对应的表示.模型充分利用了实体信息对文本表示的增强,但是忽略了关系信息,缺少对关系信息的利用.OpenEntityF1=75.6%JAKET[46](2020)模型采用交替训练的方式融合文本和知识图谱信息,增强了实体表示效果和文本表示信息.模型利用了实体的描述信息,因此模型不适应于缺少实体相关描述知识图谱的预训练任务.FewRel(5-way 1-shot)ACC=87.4%K-BERT[48](2020)区别于ERNIE模型,K-BERT对边(关系)进行表示,添加到编码层中,进一步利用知识图谱三元组的信息,增强了预训练效果.模型暂时仅利用CN-DBpedia,HowNet,MedicalKG这3个知识图谱进行预训练测试,缺少模型针对任一指定大规模知识图谱的预训练效果测试.MSRA-NERF1=95.7%CoLAKE[49](2020)模型根据实体抽取子图并转换为序列,通过Transformer进行预训练;模型采用CPU-GPU混合训练的策略减少模型训练时间.模型对文本和知识图谱同时进行训练,因此模型仅能适用于文本和知识图谱同时存在并紧密相关的任务.模型不能适用于无文本相关的知识图谱预训练任务.OpenEntityF1=76.4%KEPLER[50](2021)模型利用BERT对知识图谱实体描述信息进行编码,增强了知识图谱预训练表示的效果.模型利用了实体的描述信息,因此模型不适应于缺少实体相关描述知识图谱的预训练任务.OpenEntityF1=76.2%

续表3

预训练模型类别预训练模型(提出年份)特性性能创新点不足数据集及结果面向基于大规模知识下游任务的预训练模型K-ADAPTER51](2020)模型针对不同任务场景融合不同的相关知识,采用adapter针对性地进行特征提取,增强了模型预训练效果.因为每个adapter都需要分别设计预训练目标,需要针对不同的知识设计不同的预训练任务,因此模型对于无预训练任务目标的知识不能有效利用.OpenEntityF1=77.5%PKGM[52](2021)模型可以在不需要访问知识图谱三元组的情况下,使下游任务通过嵌入计算得到必要的事实知识.减少了下游任务繁琐的数据选择和模型设计.模型需要尽可能大且全量的知识图谱数据集,这样才能发挥模型预训练的优势,因此模型对于图谱完成性差、稀疏度高的知识图谱预训练较差.基于图结构的预训练模型GPT-GNN[53](2020)模型是自监督的生成式预训练框架,可以捕捉知识图谱内在的结构和语义等属性信息,增强了知识图谱预训练效果,提升图谱在下游任务的作用.图神经网络模型在大规模任务中计算量大,因此模型需进行子图采样,针对子图先进行预训练.模型缺少对关系的建模和表示.OAG0.393±0.112DGI[54](2018)模型是对比学习的预训练模型.通过对比学习局部表示和全局表示的互信息最大化进行图谱预训练表示.模型利用互信息进行知识图谱预训练,需要全局表示,因此在大规模知识图谱预训练时,时间消耗非常巨大.Reddit0.940±0.001GraphCL[55](2020)模型是一个基于对比学习的自监督图谱预训练模型,通过最大化子图间的相似度进行自监督学习.模型利用子图相似度进行对比学习,因此极大依赖图谱的结构信息,缺失对关系的建模和表示.Reddit0.951±0.01GCC[56](2020)模型不依赖节点和边信息,仅利用图结构信息进行预训练,避免了复杂的特征工程,更加具有普适性.数据生成部分耗时较大,尤其获取子图实例操作具有极大的时间消耗.COLLAB81.1%

1) 面向知识图谱表示的预训练模型

在词向量表示中,预训练模型分为2个部分,分别是预训练与微调,这样的模式可以使词向量表示更适合于不同的应用环境.同样地,在面向知识表示的预训练模型中,同样先采用预训练的向量表示,然后再基于此进行进一步的深化挖掘.这类预训练模型,旨在通过引入新的处理方法对预训练的知识表示进行进一步的特征挖掘,以此可以得到原有表示不具备的特征,如ConvKB[44],CapsE[45]等.这类模型不能最大化地提取三元组的特征,模型预训练效果依赖于基础知识图谱表示学习模型的选择.

2) 面向自然语言问题的预训练模型

知识图谱在处理与自然语言相关的任务时,必不可少地与语言模型相互联系.这一类预训练模型,主要是将知识融合到一个词向量模型中形成一个既包含知识又具备上下文信息的预训练词向量.近几年的相关研究主要是将知识融合到BERT中形成新的预训练模型.典型的模型有:CMU和微软联合提出的JAKET[46]、清华大学和华为联合提出的ERNIE[47]、北京大学和腾讯联合提出的模型K-BERT[48]、复旦大学和亚马逊提出的CoLAKE[49]、清华大学和Mila实验室提出的KEPLER[50]等.这类模型利用实体信息增强了预训练效果并减少了训练时间,但不适用于缺少实体相关描述的预训练任务.

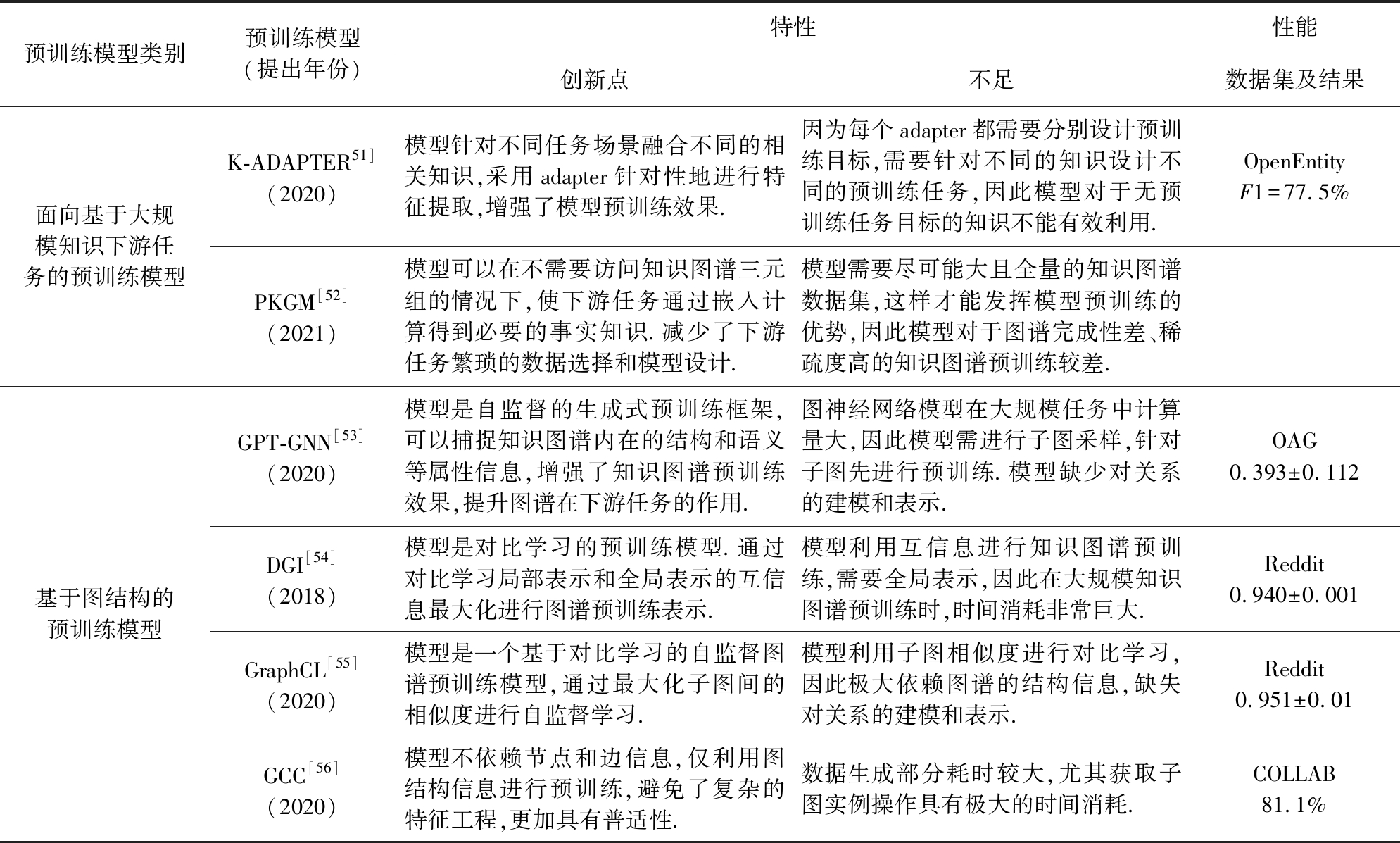

3) 面向下游任务的预训练模型

知识图谱预训练模型还可以通过不同的特殊下游任务来帮助向预训练模型融入任务相关的知识.主要方法是在对具体的下游任务进行微调时,可以采用不同的适配器来针对性地加入特征,进而增强其效果.代表性的工作有复旦大学和微软提出的K-ADAPTER[51]和阿里巴巴实验室提出的“预训练+知识向量服务”的模式PKGM[52],结构如图4所示.这类模型需要尽可能大且全量的知识图谱数据集,这样才能发挥模型预训练的优势,因此模型对于图谱完成性差、稀疏度高的知识图谱预训练较差.

Fig. 4 Adding service embedding to the sequence model

图4 将服务向量添加到序列模型

4) 基于图谱中图结构的预训练模型

知识图谱是一种特殊的信息图,可以通过适用于图的方法GNN获取知识图谱的部分结构特征.图神经网络(graph neural networks, GNNs)已被证明是建模图结构数据的强大工具,然而,训练GNN模型通常需要大量的特定任务的标记数据,而获取这些数据往往非常昂贵.利用自监督GNN模型对未标记数据进行预训练是减少标记工作的一种有效方法,预训练学习到的模型可用在只有少量标签图谱数据的下游任务中.代表性的工作有:GPT-GNN[53],GI[54],GraphCL[55],GCC[56]等.这类方法不依赖于图谱的节点与边信息,仅利用图结构进行预训练,避免复杂的特征工程,但缺陷是耗时巨大.

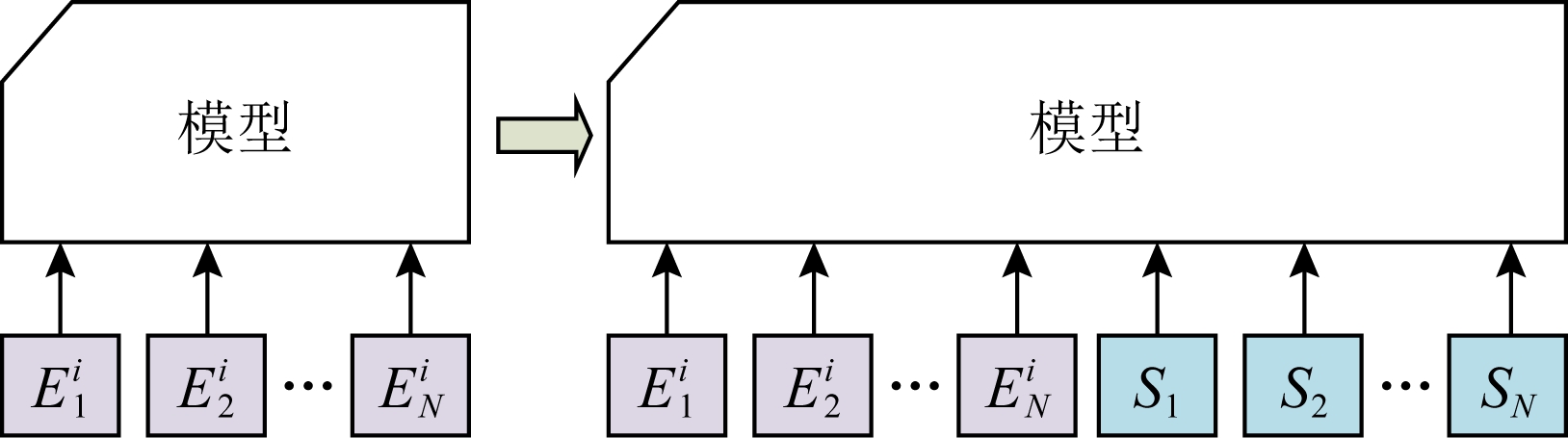

3 神经符号结合的知识更新与推理

ACM图灵奖获得者Yoshua Bengio在NeuIPS 2019的特邀报告中明确提到,深度学习需要从系统1到系统2转化.这里所说的系统1和系统2来源于认知科学中的双通道理论,其中系统1可以理解为神经系统,它表示直觉的、快速的、无意识的系统;系统2可以理解为符号系统,它表示慢的、有逻辑的、有序的、可推理的系统.Bengio所提的系统2关于深度学习的想法与“神经+符号”的知识表示与推理目标基本一致.神经系统优势在于能够轻松处理图像识别、文本分类等一类机器学习擅长的问题,模型能够允许数据噪音的存在,但缺点在于其端到端的过程缺乏可解释性,并且在模型求解答案过程中难以嵌入已有的人类知识.相反地,符号系统可以完美地定义各类专家经验规则和知识,形成对结构化数据的各类原子操作,在此基础上通过搜索和约束进行求解,整个过程的解释性和可理解性也很强.但是,符号系统的缺点在于难以处理很多拥有异常数据和噪音的场景.然而,“神经+符号”到底如何有机结合,实现起来并不容易.知识图谱从早期的知识库、专家系统,到谷歌2012年正式提出知识图谱,其发展历程也体现了神经系统和符号系统的各自发展缩影,整体上可分为神经助力符号和符号助力神经两大类.

3.1 神经助力符号推理

神经助力符号推理方法的特点在于将神经的方法应用在传统符号系统的问题求解,通常主要是解决浅层的推理问题,其核心在于如何将神经系统学到的“浅层知识表示”(计算结构和连续型数值表示的知识)更新到已有的符号知识体系中(离散的、显式的符号化知识).

敏捷逻辑(swift logic)是牛津大学Gottlob等人[57]关于“神经+符号”的尝试,如图5所示,该系统既能够执行复杂的推理任务(以Datalog±语言为理论基础),同时在可接受的计算复杂度下,利用神经网络在大数据上实现高效和可扩展的推理.此外,敏捷逻辑还定义了与企业数据库、网络、机器学习和分析软件包的接口,以实现与数据库和人工智能中不断出现的新技术相结合.敏捷逻辑的特点是不局限于模型层面的结合,更关注从知识图谱管理系统框架层面来使用神经和符号多种技术.

Fig. 5 Neural for symbolic system—swift logic

图5 神经助理符号系统——敏捷逻辑框架

Markov逻辑网络[58](Markov logic network, MLN)是由一阶逻辑公式及其对应的权值组成的二元组集合,其基本思想是利用统计关系学习模型将Markov网络与一阶逻辑相结合,进而实现对传统一阶逻辑限制的放松,在自然语言处理、复杂网络、信息抽取等领域都有重要的应用.此类方法的缺点在于模型往往受限于Markov逻辑推理的效率瓶颈,采用相对简单的逻辑推理机制又易陷入推理困境.

知识图谱表示学习技术[59]也是一种典型的神经助力符号推理的研究,其特点是采用神经系统训练的思想,设计知识图谱实体和关系在隐空间下的距离度量函数,用统计推理代替逻辑演绎,最终应用于知识补全或其他下游任务中.最具代表性的工作是翻译模型TransE[60]和基于矩阵分解的RESCAL[61]模型.在这2种方法的启发下诞生了很多变种,其本质区别是分别从知识图谱特征上有更多考虑,如时空知识图谱嵌入[62],或从表示空间上进行拓展迁移,如使用奇异值分解模型生成的复数值嵌入ComplEx[63],ConvE[64]等.受知识图谱表示学习的启发和图神经网络技术的发展,华盛顿大学Chen等人[65]则尝试直接使用图神经网络等深度学习技术进行知识表示学习.

牛津大学和伦敦大学学院的研究团队提出神经理论证明机[66],其设计了一个端到端的微分定理证明神经网络,其中的运算基于知识图谱的稠密实值向量表示,通过运算稠密向量表示来实现对知识图谱上查询的端到端可微证明.在该过程中,神经网络是受Prolog中的反向链算法启发递归构造而成,同时用径向基函数核符号向量表示的可微计算来代替传统的符号统一表示,从而将符号推理与学习次符号向量表示相结合.

斯坦福大学的自然语言处理团队提出神经张量网络[67],相比前人在知识图谱里使用实体去预测关系,其引入了一个损失函数为双线性的3层神经网络模型,并且对于实体向量初始化的处理采用非监督模型训练得到的词向量的平均值,进而大大提高了系统准确率.

清华大学自然语言处理实验室在知识图谱表示学习领域发布了OpenKE平台(1)http://openke.thunlp.org/,整合了TransE,TransH,TransR,TransD,RESCAL,DistMult,HolE,ComplEx等算法,提供了统一接口方便研究人员进行高效复现或直接调用,同时,在WikiData 和 Freebase两个数据集上提供了预训练知识表示.该项目旨在为开发者和研究人员提供便利,在系统工具方面是一项重要的贡献.

东南大学的Wang等人[68-69]从知识图谱的应用出发,在知识图谱嵌入空间求解复杂问题方向提出了一系列方法,首先针对知识图谱复杂查询面临的空集问题,充分利用知识图谱嵌入空间对于数据不完整性的弥补以及链接预测机制,设计了一种全身的知识图谱近似查询方法[68-69],并针对该方法的效率问题设计了合理的知识图谱哈希学习方法[70].

南京大学的Hu等人[71-72]和清华大学的Li等人[73]在传统的知识图谱实体对齐任务上,引入知识图谱表示学习技术,提出了一系列基于知识图谱嵌入的实体对齐模型,并充分考虑了路径等特征对于实体对齐模型的影响[73].值得一提的是南京大学的Hu等人在基准数据集上对于知识图谱嵌入的有效性做了深入评测,为该领域提供了重要的基准数据集和方向指引[74].

中山大学的Wan等人[75]和广东外语外贸大学的Du等人[76]针对知识图谱表示学习的更新问题,以及无法有效利用逻辑公理进行推理的缺陷,提出了一种效率较高的增量更新方法,可以在不重新进行机器学习训练的情况下对知识图谱实体和关系向量进行更新,同时分析了各种现有的基于翻译机制的表示学习模型对不同类型的逻辑公式的支持情况,并有效嵌入逻辑规则提升嵌入质量.

值得一提的是,异质信息网络近年来和知识图谱一样在社交网络挖掘领域也逐渐被提及,国内清华大学的Cui等人[77-78]在异质信息网络的表示学习方面从节点重要性、社团、网络距离等方面都进行了向量空间中的探索研究,同时考虑了超图等复杂的结构和嵌入的动态更新,为知识图谱领域的嵌入提供了一定的借鉴思路.北京邮电大学的Shi等人[79-81]则立足于知识图谱和社交网络的研究交叉点,重点探索了基于图神经网络和异质信息网络表示学习技术在文本分析、知识图谱问答、推荐系统层面的作用.

3.2 符号助力神经计算

符号助力神经方法的特点在于将符号的方法应用在神经网络的训练过程中.国外代表性的工作有:

日本索尼公司联合英国和意大利的学者共同提出的逻辑张量网络[82-83],通过改进神经的方法,引入称为多值和端到端的可微分一阶逻辑作为表示语言来支持深度学习和推理.逻辑张量网络为多种任务(例如数据聚类、多标签分类、关系学习、查询应答、半监督学习、回归和嵌入学习)提供了统一的语言.

卡内基梅隆大学团队使用逻辑规则在深度神经网络中进行数据的编审(data curation)[84],其核心是将一阶逻辑规则所代表的认知和结构化知识通过后验正则项(posterior regularization)建模成一个指导网络(teacher network),然后用知识蒸馏的方式将指导网络中的知识传授给另一个学习者神经网络(student neural network)的权重中,实现在测试阶段一些新样本的预测.

斯坦福大学的研究团队提出的远程监督(distant supervision)模型[85],衍生出了一系列研究工作.远程监督针对知识图谱构建过程中的核心任务关系抽取,假设知识图谱中存在一个三元组〈实体1,关系,实体2〉,那么给定非结构化的文本中任何包含实体1和实体2的句子在一定程度上都反映了该三元组中的关系.基于这个假设,远程监督算法可以利用知识图谱中已有三元组和对应的关系来启发式地标注句子.值得一提的是远程监督这种启发式的策略可能使一些句子被错误标记,导致抽取性能下降,因而如何去噪是远程监督的关键问题.

在计算机视觉和自然语言处理领域的少样本、零样本模型和场景中,知识图谱等符号知识也被用来增强训练数据,从而扩充监督信息,实现用充足数据和可靠的经验知识将神经系统学习得到的模型误差最小化[86].

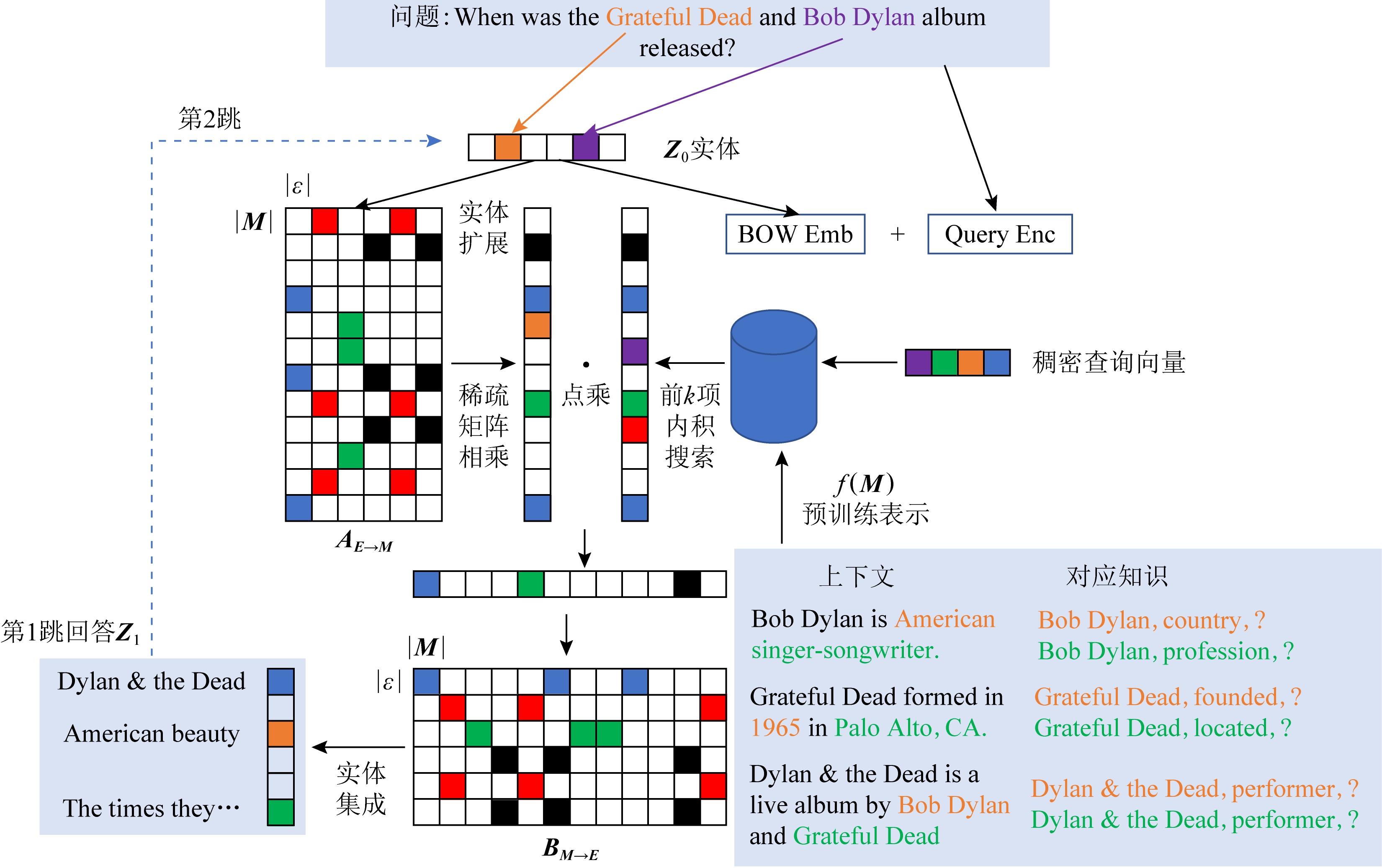

Fig. 6 Neural+symbolic complex multi-hop question answering

图6 神经符号结合的复杂多跳问题求解

哈尔滨工业大学团队近年来致力于符号助力的自然语言处理研究,在传统的自然语言处理的实体识别及其类别获取、关系抽取、文本情感分析、生物医学文献挖掘、因果推断、知识推理、事理图谱构建等方面都有一定的进展[87].

中国科学院自动化研究所模式识别国家重点实验室团队充分利用符号形式的知识,在传统的自然语言处理[88]和事件知识抽取[89]方面取得了一系列进展.在自然语言处理方面,其最新致力于探索神经网络的可解释性研究;在事件图谱构建方面,其最新致力于面向垂直领域的复杂场景事件知识抽取和事件图谱构建.

复旦大学团队近年来提出的符号接地(symbol grounding)工作[90],旨在为大规模知识图谱实现符号接地,实现基于大规模知识图谱的跨模态语义增强.其核心思想是以符号知识为核心的认知智能与以模式识别为核心的感知智能相结合,在大规模符号接地技术的推动下,使机器学习与符号知识充分融合与协同计算,进而赋予符号化的知识体系与形式化系统以“体验”与“意义”,进一步提升机器的认知水平.

3.3 神经符号结合的知识表示与推理

一个完美的“神经+符号”系统的特点和优势为:1)能够轻松处理目前主流机器学习擅长的问题;2)对于数据噪音有较强的鲁棒性;3)系统求解过程和结果可以被人容易地进行理解、解释和评价;4)可以很好地进行各类符号的操作;5)可以无缝地利用各种背景知识.从以上标准来看,实现神经符号知识表示的充分结合还有很长一段路要走.国外目前最具代表性的研究为Cohen等人[91]和Lamb等人[92]的研究工作.

Cohen[91]作为人工智能领域的重要学者,近年来发表了一系列的神经符号结合的研究工作,其中典型工作DrKIT的整体框架如图6所示.DrKIT使用语料库作为虚拟的知识图谱,进而实现复杂多跳问题求解.DrKIT采用传统知识图谱上的搜索策略进行文本数据的遍历,主要是遵循语料库中包含文本提及实体之间的关系路径.在每个步骤中,DrKIT使用稀疏矩阵TF/IDF索引和最大内积搜索,并且整个模块是可微的,所以整个系统可使用基于梯度的方法从自然语言输入到输出答案进行训练.DrKIT非常高效,每秒比现有的多跳问答系统快10~100倍,同时保持了很高的精度.

Lamb等人[92]从事神经符号结合的人工智能研究已经很多年,其最新的研究致力于探索图神经网络技术在神经符号集合的智能计算过程中扮演的关键作用.值得一提的是,由其发起的神经符号国际研讨会已经召开了15届,近些年逐渐受到越来越多的关注.

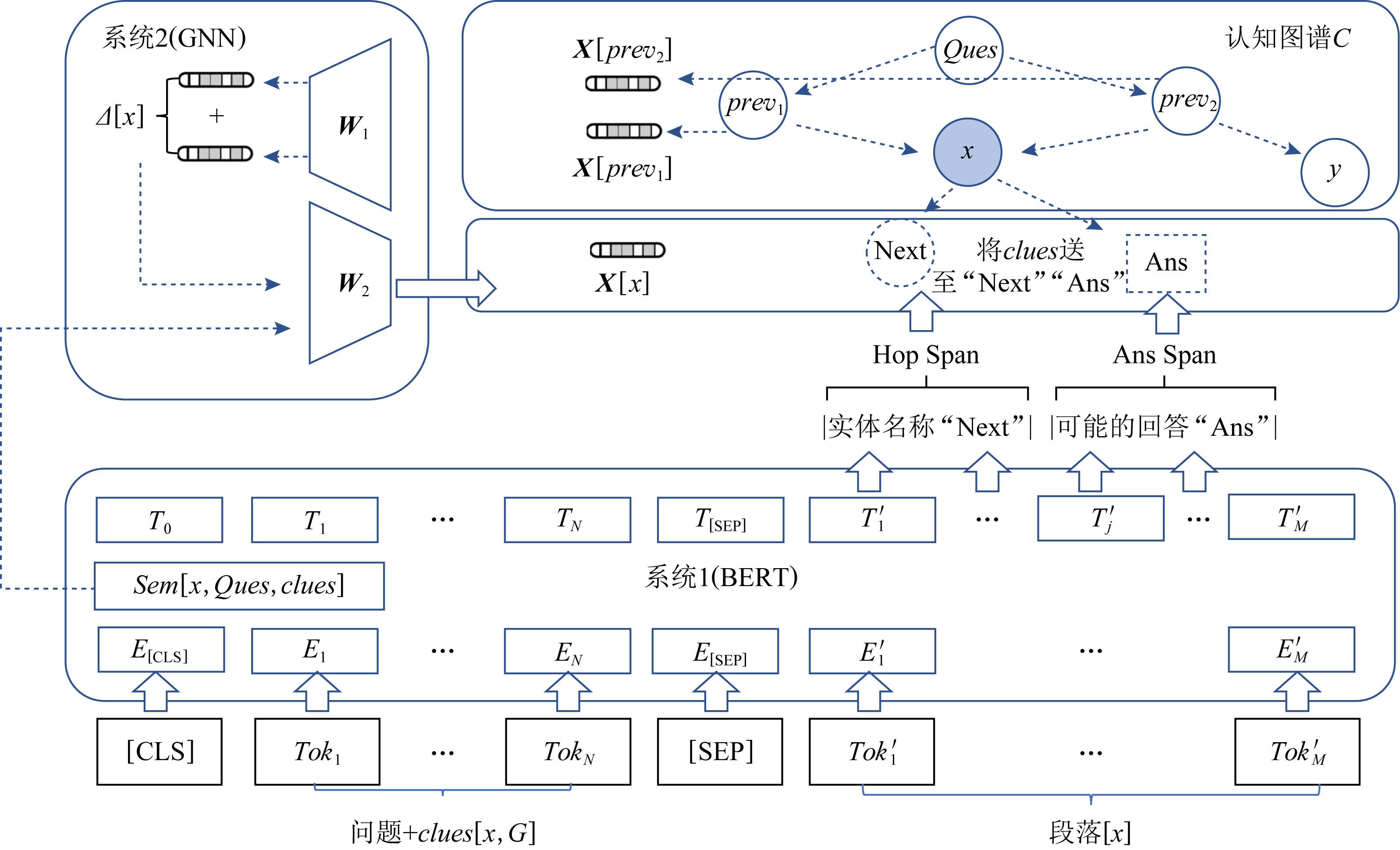

清华大学的Ding等人[93]所做的工作CogQA提出了基于人类认知模式的认知图谱来解决阅读理解上的多跳问答,属于神经符号结合较为均衡的工作,整体框架如图7所示.其核心思想是“知识图谱+认知推理+逻辑表达”,目的是在系统1中做知识的扩展,在系统2中做逻辑推理和决策(采用图神经网络和符号知识结合的方法),进而实现用符号知识的表示、推理和决策(系统2)来解决深度学习求解过程(系统1)的黑盒问题.值得一提的是要真正实现对系统1所有场景的知识和推理,需要万亿级的知识图谱支持.

Fig. 7 Neural+symbolic cognitive graph

图7 神经符号结合的认知图谱

浙江大学的Zhang等人[94]在知识图谱表示学习和规则挖掘方面的结合近年来进行了一系列探索,核心思想是将表示学习和规则挖掘结合在一起,互相弥补各自的瓶颈,既能够通过知识图谱规则挖掘的方法提取一组可代表知识图谱语义信息的Horn逻辑规则,又通过基于规则的物化推理方法将相应的隐藏语义信息注入到知识图谱表示学习模型中提升嵌入效果,反之,更新后的知识图谱嵌入集合有效的生成策略可以生成候选规则.

吉林大学的Cui等人[95]最新的研究工作充分探究了神经符号结合在图生成领域的效果,该文作者提出一个通用的关注成本的图生成(cost-aware graph generation)框架,把贝叶斯优化的优势带给图生成任务来解决此问题,该方法在分子发现和神经架构搜索2个具有挑战任务中能够找到次优甚至最优解,同时比当前最新的深度图生成技术,特别是被MIT review评论为2020年十大突破技术之一的GENTRL方法降低了30%~95%的评估代价.

4 研究进展比较

4.1 非结构化多模态数据组织与理解

在非结构化多模态数据组织方面,多模态知识图谱目前已经成为国内外学者对于多种类型数据组织的共识,国内外的学者均有新的研究成果.对于国外研究团队而言,其核心思路依然是从维基百科中抽取已有知识图谱的多模态数据资源,而国内研究团队将范围扩展到了通过全域的数据资源来补充已有知识图谱中的视觉和文本信息.可以看出,对于知识图谱而言,开放域的非结构化数据资源丰富,但是如何同已有结构化的图谱融合并建立不同模态数据之间的语义关联是关键.此外,国内研究团队面向垂直领域(智慧教育)提出了系统级的研究工作,这一点要比国外的研究更具有落地思维,可以预见未来国内在更多垂域会出现以多模态知识图谱为基础的系统和应用.在多模态数据理解方面,受益于深度学习技术的持续发展,国内外在该领域都取得了最新的研究成果.可以看出,国内研究人员已经可以从延续他人工作转变为开辟新的研究领域,这一点说明国内在该领域走在世界学术前沿.值得一提的是,国内学者在知识图谱驱动的多模态数据理解方面同样具有较强的应用落地思维,分别面向推荐系统等垂直场景进行了探索尝试.

4.2 大规模动态知识图谱表示学习与预训练

在大规模动态表示学习方面,国内外均有新的研究成果,在不同的方向有所突破.国外在序列模型编码方法上有更多模型被提出,对GCN,GNN等类型的编码器进行了改进,在动态表示方面取得了更好的结果;而国内主要的工作集中在基于分解、基于历时性编码和基于随机游走改进3个方面,虽然与国外的方法思路不同,但是在动态表示方面也有亮点和突出表现.知识图谱预训练是近两年的一个热点方向,国内外很多研究机构都针对此方面有所研究并做出了突破.国外在图谱表示的预训练方面有一些新的工作,并在基于知识图谱图结构的预训练方面有更多的进展.而国内,基于自然语言方面的知识预训练有更多的新模型产生,诸如北京大学、清华大学等学校,百度等企业均在这方面有新的研究成果产生.尤其是面向基于大规模知识下游任务的预训练模型,有了重大突破,对数以10亿计规模的知识进行了预训练,并应用于阿里电商平台,为商品推荐、语义搜索和智能问答等下游任务提供支持.

4.3 神经符号结合的知识表示与推理

在神经助力符号方面,国内外均有新的研究成果.通过比较可以看出,国外研究团队在知识图谱表示学习技术的初期走在该领域的前沿,提出了一系列开创性的工作;国内的研究团队主要针对各类模型和数据特点进行改进,在后期逐渐提出了创新性更高和实用性更强的工作,尤其是知识图谱表示学习技术在其他任务(如智能问答、近似搜索、推荐系统、实体对齐、社交网络等)中有效地使用,国内研究团队走在学术的前沿,可以看出国内学者更倾向于应用层级的研究.除此之外,在逻辑推理等偏理论的模型中如何引入神经网络,国内研究工作还不多.在符号助力神经方面,国内外都走在学术的前沿.在神经符号结合方面,谷歌公司依然走在世界的最前沿,提出了一系列开创性工作,国内这方面的工作还偏少.不过整个神经符号的有机结合还属于初期探索领域,随着越多的研究者开始关注,未来我国研究团队还有很大的提升空间.

5 未来研究方向展望

知识图谱对于大数据智能具有重要意义,在自然语言处理、信息检索、智能推荐和智能问答等领域中发挥重要作用.

现如今,各大高校、科研机构和商业互联网络公司都已经意识到知识图谱的重要战略意义,纷纷投入精力加速对知识图谱的研究与应用.同时,知识图谱虽然已历经10余年的发展,但是依然处在发展的初级阶段,部分知识图谱投入使用但是应用场景仅仅局限在商品推荐、智能搜索和医疗健康等领域,更多的领域知识图谱还处在构建完善阶段,远远没有达到投入前沿应用并发挥显著作用的地步.

在未来的一段时间内,知识图谱的构建、储存、表示和推理等依然是知识图谱领域内的研究热点,与此同时适用于特殊场景、更多下游任务的特殊知识图谱,诸如动态知识图谱、时序知识图谱、空间知识图谱、事理图谱、认知图谱和多模态图谱等均是研究者们关注的重点,同时许多问题也需要学术界和工业界共同协力解决.在此,我们对未来新一代知识图谱关键技术研究发展趋势进行展望.

5.1 非结构化多模态数据组织与理解

知识不是简单的数据,亦不是普通的信息,知识反映了客观世界中事物之间的关系,不同事物或者相同事物之间的不同关系形成了不同的知识.而在互联网上,人们往往最先接触到的是各种信息或各种数据,而知识往往就存在于这些信息和数据中,人们可以通过对信息和数据的初步提炼和分析获得自己需要的知识.对于计算机而言同样如此,如何从互联网上各种格式的信息和大数据中提炼出其需要的知识,是知识图谱的重要问题.目前,已经存在很多优秀的算法可以从文本、图像等格式的数据中抽取知识,部分优秀的算法也能达到比较优异的准确率.但是往往这些表现优异的算法,更多的是针对格式化的数据,并且对于知识的领域有所限制.然而,随着需求的不断提高,从非结构化多模态的数据中提取特定领域的知识就愈发重要.因此,在未来针对非结构化知识获取、多模态知识获取、长文本处理、多方式协同获取、特定领域知识获取、环境自适应增量获取等方向的研究将成为研究者们进一步深入研究的重点.

5.2 大规模动态图谱表示学习与预训练

知识图谱主要以三元组的方式进行储存,这种方法可以较好地表示更多事实性知识.然而,知识丰富多样,面对很多特殊环境,简单的三元组就已经束手无策,诸如时序知识、事件知识和模糊知识等.针对简单的知识图谱三元组、时序知识图谱和事件知识图谱等,研究者们已经研究出很多相关的表示模型用以对这些知识进行表示.但是,现有的研究还远远没有满足人们的需求,知识表示是知识图谱构建和后续研究的基础,而且针对不同类型的知识图谱也需要特定的知识表示方式.因此,针对特殊的知识图谱,诸如时序、空间、事理、认知图谱等均需要独特的知识表示方法,这些相比简单的三元组知识而言的复杂知识所需的特殊知识表示方法将是未来几年知识表示方向的重要研究趋势.此外,近几年,研究者们对知识表示的可解释性越发地重视,不能简简单单地将知识表示为嵌入向量,而是需要对表示的可解释性进行展示.因此,未来几年,知识表示可解释性方面的研究依然会是热点.

5.3 神经符号结合的知识更新与推理

神经符号结合的知识更新与推理的核心在于神经方法和符号方法如何有效结合,围绕此过程,未来该领域的研究方向首先是神经符号2种知识的翻译问题,这种神经符号知识的翻译研究将主要包括知识图谱预训练结果与知识图谱实例的映射,以及融合神经和符号的知识图谱实例多重语义表达.其次,在神经符号完美融合较为困难的理论背景下,2类方法的合理组合方式可能会是研究人员更为实际的探索方向,主要包括“神经+符号”的联合表征学习,融合预训练、知识图谱、记忆机制的神经符号组合框架设计,面向不同垂域任务应用的神经符号知识互补范式,以及脑认知启发下的神经符号结合4个方面.最后,在知识推理层级,主要可能的研究方向包括融合神经与符号知识的推理任务重定义、将符号知识高效编码并且以低损方式嵌入到神经网络、设计包含符号知识的可微推理规则、本体(概念层次、公理规则)表示学习以及神经符号推理引擎4个方面.

6 总 结

本文围绕支撑新一代知识图谱的关键技术研究进展与趋势展开系统性论述,内容包括:非结构化多模态图谱组织与理解、大规模动态图谱表示学习与预训练模型、神经符合结合的知识表示与推理.在此基础上,给出了国内与国际的当前研究进展,并对国内外研究进展进行比较.最后对这些关键技术的发展趋势进行了展望.

作者贡献声明:王萌负责组织文章整体结构,调研部分文献以及分析、整理文献;王昊奋完成部分文献的分析与比较;李博涵调研、分析、整理文献;赵翔参与部分文献的调研、分析和比较,还参与图形制作以及审核论文;王鑫修订论文.

[1]Singhal A. Introducing the knowledge graph: Things, not strings[EB/OL]. [2021-11-19]. https://blog.google/products/search/introducing-knowledge-graph-things-not/

[2]Wang Xin, Zou Lei, Wang Chaokun, et al. Research on knowledge graph data management: A survey[J]. Journal of Software, 2019, 30(7): 2139-2174 (in Chinese)(王鑫, 邹磊, 王朝坤, 等. 知识图谱数据管理研究综述[J]. 软件学报, 2019, 30(7): 2139-2174)

[3]Ji Shaoxiong, Pan Shirui, Cambria E, et al. A survey on knowledge graphs: Representation, acquisition, and applications[J]. arXiv preprint, arXiv: 2002.00388, 2020

[4]Guan Saiping, Jin Xiaolong, Jia Yantao, et al. Knowledge reasoning over knowledge graph: A survey[J]. Journal of Software, 2018, 29(10): 2966-2994 (in Chinese)(官赛萍, 靳小龙, 贾岩涛, 等. 面向知识图谱的知识推理研究进展[J]. 软件学报, 2018, 29(10): 2966-2994)

[5]Auer S, Bizer C, Kobilarov G, et al. DBpedia: A nucleus for a web of open data[C] //Proc of the 6th Int Semantic Web Conf. Berlin: Springer, 2007: 722-735

[6]Vrande![]() i

i![]() D, Krötzsch M. Wikidata: A free collaborative knowledge base[J]. Communications of the ACM, 2014, 57(10): 78-85

D, Krötzsch M. Wikidata: A free collaborative knowledge base[J]. Communications of the ACM, 2014, 57(10): 78-85

[7]Ferrada S, Bustos B, Hogan A. IMGPedia: A linked dataset with content-based analysis of Wikimedia images[C] //Proc of the 16th Int Semantic Web Conf. Berlin: Springer, 2017: 84-93

[8]Liu Ye, Li Hui, Garcia-Duran A, et al. MMKG: Multi-modal knowledge graphs[C] //Proc of the 16th European Semantic Web Conf. Berlin: Springer, 2019: 459-474

[9]Bloem P, Wilcke X, van Berkel L, et al. KgBench: A collection of knowledge graph datasets for evaluating relational and multimodal machine learning[C] //Proc of the 18th European Semantic Web Conf. Berlin: Springer, 2021: 614-630

[10]Wang Meng, Wang Haofen, Qi Guilin, et al. Richpedia: A large-scale, comprehensive multi-modal knowledge graph[J]. Big Data Research, 2020, 22(10): 100159

[11]Zheng Qinghua, Liu Jun, Zeng Hongwei, et al. Knowledge forest: A novel model to organize knowledge fragments[J]. arXiv preprint, arXiv: 1912.06825, 2019

[12]Zheng Qinghua, Liu Jun, Wei Bifan, et al. Knowledge Forest: Theory, Method and Practice[M]. Beijing: Science Press, 2021 (in Chinese)(郑庆华, 刘均, 魏笔凡, 等. 知识森林: 理论、方法与实践[M]. 北京: 科学出版社, 2021)

[13]Naphade M, Smith J R, Tesic J, et al. Large-scale concept ontology for multimedia[J]. IEEE Multimedia, 2006, 13(3): 86-91

[14]Arndt R, Troncy R, Staab S, et al. COMM: Designing a Well-Founded Multimedia Ontology for the Web[M]. Berlin: Springer, 2007

[15]Baltrušaitis T, Ahuja C, Morency L P. Multimodal machine learning: A survey and taxonomy[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 41(2): 423-443

[16]Srivastava N, Salakhutdinov R. Multimodal learning with deep Boltzmann machines[C] //Proc of the 26th Conf on Neural Information Processing Systems. Cambridge, MA: MIT Press, 2012: 2222-2230

[17]Mousselly-Sergieh H, Botschen T, Gurevych I, et al. A multimodal translation-based approach for knowledge graph representation learning[C] //Proc of the 7th Joint Conf on Lexical and Computational Semantics. Stroudsburg, PA: ACL, 2018: 225-234

[18]Li Manling, Zareian A, Lin Ying, et al. GAIA: A fine-grained multimedia knowledge extraction system[C] //Proc of the 58th Annual Meeting of the ACL. Stroudsburg, PA: ACL, 2020: 77-86

[19]Peng Yuxin, Zhu Wenwu, Zhao Yao, et al. Cross-media analysis and reasoning: Advances and directions[J]. Frontiers of Information Technology & Electronic Engineering, 2017, 18(1): 44-57

[20]He Xiangteng, Peng Yuxin, Xie Liu. A new benchmark and approach for fine-grained cross-media retrieval[C] //Proc of the 27th ACM Int Conf on Multimedia. New York: ACM, 2019: 1740-1748

[21]Zhang YingYing, Qian Shengsheng, Fang Quan, et al. Multi-modal knowledge-aware attention network for question answering[J]. Journal of Computer Reserch and Development, 2020, 57(5): 1037-1045 (in Chinese)(张莹莹, 钱胜胜, 方全, 等. 基于多模态知识感知注意力机制的问答方法[J]. 计算机研究与发展, 2020, 57(5): 1037-1045)

[22]Xie Ruobing, Liu Zhiyuan, Luan Huanbo, et al. Image-embodied knowledge representation learning[J]. arXiv preprint, arXiv: 1609.07028, 2016

[23]Wu Zhiwei, Zheng Changmeng, Cai Yi, et al. Multimodal representation with embedded visual guiding objects for named entity recognition in social media posts[C] //Proc of the 28th ACM Int Conf on Multimedia. New York: ACM, 2020: 1038-1046

[24]Chen Liyi, Li Zhi, Wang Yijun, et al. MMEA: Entity alignment for multi-modal knowledge graph[C] //Proc of the Int Conf on Knowledge Science, Engineering and Management. Berlin: Springer, 2020: 134-147

[25]Guo Hao, Tang Jinyang, Zeng Weixin, et al. Multi-modal entity alignment in hyperbolic space[J]. arXiv preprint, arXiv:2106.03619, 2021

[26]Zhu Cunchao, Chen Muhao, Fan Changjun, et al. Learning from history:Modeling temporal knowledge graphs with sequential copy-generation networks[J]. arXiv preprint, arXiv:2012.08492, 2020

[27]Leblay J, Chekol M W. Deriving validity time in knowledge graph[C] //Proc of the 27th World Wide Web Conf. New York: ACM, 2018: 1771-1776

[28]Xu Chengjin, Nayyeri M, Alkhoury F, et al. Temporal knowledge graph embedding model based on additive time series decomposition[J]. arXiv preprint, arXiv:1911.07893, 2019

[29]Tian Manxin, Shou Lidan, Chen Ke, et al. A knowledge representation method based on entity time sensitivity[J]. Journal of Software Engineering, 2020, 23(1): 1-6 (in Chinese)(田满鑫, 寿黎但, 陈珂, 等. 一种基于实体时间敏感度的知识表示方法[J]. 软件工程, 2020, 23(1): 1-6)

[30]Trivedi R, Farajtabar M, Biswal P, et al. Dyrep: Learning representations over dynamic graphs[C/OL] //Proc of the 2019 Int Conf on Learning Representations. [2021-07-15]. https://par.nsf.gov/servlets/purl/10099025

[31]Jin W, Jiang He, Qu Meng, et al. Recurrent event network: Global structure inference over temporal knowledge graph[J]. arXiv preprint, arXiv:1904.05530, 2019

[32]Bian R, Koh Y S, Dobbie G, et al. Network embedding and change modeling in dynamic heterogeneous networks[C] //Proc of the 42nd Int ACM SIGIR Conf on Research and Development in Information Retrieval. New York: ACM, 2019: 861-864

[33]Han Zhen, Chen Peng, Ma Yunpu, et al. xERTE: Explainable reasoning on temporal knowledge graphs for forecasting future links[J]. arXiv preprint, arXiv:2012.15537, 2020

[34]Xie Ruobing, Liu Zhiyuan, Jia Jia, et al. Representation learning of knowledge graphs with entity descriptions[C] //Proc of the 30th AAAI Conf on Artificial Intelligence. Palo Alto, CA: AAAI, 2016: 2659-2665

[35]Shi Baoxu, Weninger T. Open-world knowledge graph completion[C] //Proc of the 32nd AAAI Conf on Artificial Intelligence. Palo Alto, CA: AAAI, 2018: 1957-1964

[36]Shah H, Villmow J, Ulges A, et al. An open-world extension to knowledge graph completion models[C] //Proc of the 33rd AAAI Conf on Artificial Intelligence. Palo Alto, CA: AAAI, 2019: 3044-3051

[37]Wang Yuhan, Xiao Weidong, Tan Zhen, et al. Caps-OWKG: A capsule network model for open-world knowledge graph[J]. Internatioanl Journal of Machine Learning and Cybernetics, 2021, 12(6): 1627-1637

[38]Gaur G, Bhattacharya A, Bedathur S. How and why is an answer (still) correct? Maintaining provenance in dynamic knowledge graphs[C] //Proc of the 29th ACM Int Conf on Information & Knowledge Management.New York: ACM, 2020: 405-414

[39]Das R, Godbole A, Monath N, et al. Probabilistic case-based reasoning for open-world knowledge graph completion[J]. arXiv preprint, arXiv:2010.03548, 2020

[40]Du Zhijuan, Du Zhirong, Wang Lu. Open knowledge graph representation learning based on neighbors and semantic affinity[J]. Journal of Computer Research and Development, 2019, 56(12): 2549-2561 (in Chinese)(杜治娟, 杜治蓉, 王璐. 基于相邻和语义亲和力的开放知识图谱表示学习[J]. 计算机研究与发展, 2019, 56(12): 2549-2561)

[41]Xie Weihao, Wang Shuxin, Wei Yanzhi, et al. Dynamic knowledge graph completion with jointly structural and textual dependency[C] //Proc of the 20th Int Conf on Algorithms and Architectures for Parallel Processing. Berlin: Springer, 2020: 432-448

[42]Zhou Yueyang, Shi Shumin, Huang Heyang. Weighted aggregator for the open-world knowledge graph completion[C] //Proc of the 6th Int Conf of Pioneering Computer Scientists, Engineers and Educators. Berlin: Springer, 2020: 283-291

[43]Niu Lei, Fu Chenpeng, Yang Qiang, et al. Open-world knowledge graph completion with multiple interaction attention[J]. World Wide Web, 2021, 24(1): 419-439

[44]Nguyen D Q, Nguyen T D, Nguyen D Q, et al. A novel embedding model for knowledge base completion based on convolutional neural network[J]. arXiv preprint, arXiv:1712.02121, 2017

[45]Vu T, Nguyen T D, Nguyen D Q, et al. A capsule network-based embedding model for knowledge graph completion and search personalization[C] //Proc of the 17th Conf of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Stroudsburg, PA: ACL, 2019: 2180-2189

[46]Yu Donghan, Zhu Chenguang, Yang Yiming, et al. JAKET: Joint pre-training of knowledge graph and language understanding[J]. arXiv preprint, arXiv:2010.00796, 2020

[47]Zhang Zhengyan, Han Xu, Liu Zhiyuan, et al. ERNIE: Enhanced language representation with informative entities[J]. arXiv preprint, arXiv:1905.07129, 2019

[48]Liu Weijie, Zhou Peng, Zhao Zhe, et al. K-BERT: Enabling language representation with knowledge graph[C] //Proc of the 34th AAAI Conf on Artificial Intelligence. Palo Alto, CA: AAAI, 2020: 2901-2908

[49]Sun Tianxiang, Shao Yunfan, Qiu Xipeng, et al. CoLAKE: Contextualized language and knowledge embedding[J]. arXiv preprint, arXiv:2010.00309, 2020

[50]Wang Xiaozhi, Gao Tianyu, Zhu Zhaocheng, et al. KEPLER: A unified model for knowledge embedding and pre-trained language representation[J]. Transactions of the Association for Computational Linguistics, 2021, 9: 176-194

[51]Wang Ruize, Tang Duyu, Duan Nan, et al. K-ADAPTER: Infusing knowledge into pre-trained models with adapters[J]. arXiv preprint, arXiv:2002.01808, 2020

[52]Zhang Wen, Wong C M, Ye Ganqiang, et al. Billion-scale pre-trained e-commerce product knowledge graph model[C] //Proc of the 37th IEEE Int Conf on Data Engineering. Piscataway, NJ: IEEE, 2021: 2476-2487

[53]Hu Ziniu, Dong Yuxiao, Wang Kuansan, et al. GPT-GNN: Generative pre-training of graph neural networks[C] //Proc of the 26th ACM SIGKDD Int Conf on Knowledge Discovery & Data Mining. New York: ACM, 2020: 1857-1867

[54]Velickovic P, Fedus W, Hamilton W L, et al. Deep graph infomax[J]. arXiv preprint, arXiv:1809.10341, 2018

[55]Hafidi H, Ghogho M, Ciblat P, et al. GraphCL: Contrastive self-supervised learning of graph representations[J]. arXiv preprint, arXiv:2007.08025, 2020

[56]Qiu Jiezhong, Chen Qibin, Dong Yuxiao, et al. GCC: Graph contrastive coding for graph neural network pre-training[C] //Proc of the 26th ACM SIGKDD Int Conf on Knowledge Discovery & Data Mining. New York: ACM, 2020: 1150-1160

[57]Luigi B, Gottlob G, Pieris A, et al. Swift logic for big data and knowledge graphs[C] //Proc of Int Conf on Current Trends in Theory and Practice of Informatics. Switzerland: Springer, Cham, 2018: 3-16

[58]Richardson M, Domingos P. Markov logic networks[J]. Machine Learning, 2006, 62(1/2): 107-136

[59]Wang Quan, Mao Zhendong, Wang Bin, et al. Knowledge graph embedding: A survey of approaches and applications[J]. IEEE Transactions on Knowledge and Data Engineering, 2017, 29(12): 2724-2743

[60]Bordes A, Usunier N, Garcia-Duran A, et al.Translating embeddings for modeling multi-relational data[C] //Proc of the 27th Neural Information Processing Systems. Cambridge, MA: MIT Press, 2013: 2787-2795

[61]Nickel M, Tresp V, Kriegel H P. A three-way model for collective learning on multi-relational data[C] //Proc of the 28th Int Conf on Machine Learning. New York: ACM, 2011: 809-816

[62]Goel R, Kazemi S M, Brubaker M, et al. Diachronic embedding for temporal knowledge graph completion[C] //Proc of the 34th AAAI Conf on Artificial Intelligence. Palo Alto, CA: AAAI, 2020: 3988-3995

[63]Trouillon T, Welbl J, Riedel S, et al. Complex embeddings for simple link prediction[C] //Proc of the 33rd Int Conf on Machine Learning. New York: ACM, 2016: 2071-2080

[64]Dettmers T, Minervini P, Stenetorp P, et al. Convolutional 2D knowledge graph embeddings[C] //Proc of the 32nd AAAI Conf on Artificial Intelligence. Palo Alto, CA: AAAI, 2018: 1811-1818

[65]Zhang Muhan, Chen Yixin. Link prediction based on graph neural networks[C] //Proc of the 32nd Advances in Neural Information Processing Systems. Cambridge, MA: MIT Press, 2018: 5165-5175

[66]Rocktäschel T, Riedel S. End-to-end differentiable proving[C] //Proc of the 31st Advances in Neural Information Processing Systems. Cambridge, MA: MIT Press, 2017: 3788-3800

[67]Socher R, Chen Danqi, Manning C D, et al. Reasoning with neural tensor networks for knowledge base completion[C] //Proc of the 27th Advances in Neural Information Processing Systems. Cambridge, MA: MIT Press, 2013: 926-934

[68]Wang Meng, Wang Ruijie, Liu Jun, et al.Towards empty answers in SPARQL: Approximating querying with RDF embedding[C] //Proc of the 17th Int Semantic Web Conf. Berlin: Springer, 2018: 513-529

[69]Wang Ruijie, Wang Meng, Liu Jun, et al. Leveraging knowledge graph embeddings for natural language question answering[C] //Proc of the 24th Int Conf on Database Systems for Advanced Applications. Berlin: Springer, 2019: 659-675

[70]Wang Meng, Chen Weitong, Wang Sen, et al. Efficient search over incomplete knowledge graphs in binarized embedding space[J]. Future Generation Computer Systems, 2021, 123: 24-34

[71]Sun Zequn, Hu Wei, Zhang Qingheng, et al. Bootstrapping entity alignment with knowledge graph embedding[C] //Proc of the 27th IJCAI. San Francisco, CA: Morgan Kaufmann, 2018: 4396-4402

[72]Sun Zequn, Hu Wei, Li Chengkai. Cross-lingual entity alignment via joint attribute-preserving embedding[C] //Proc of the 16th Int Semantic Web Conf. Berlin: Springer, 2017: 628-644

[73]Li Chengjiang, Cao Yixin, Hou Lei, et al. Semi-supervised entity alignment via joint knowledge embedding model and cross-graph model[C] //Proc of the 24th Conf on Empirical Methods in Natural Language Processing and the 9th Int Joint Conf on Natural Language Processing. Stroudsburg, PA: ACL, 2019: 2723-2732

[74]Sun Zequn, Huang Jiacheng, Hu Wei, et al. Transedge: Translating relation-contextualized embeddings for knowledge graphs[C] //Proc of the 18th Int Semantic Web Conf. Berlin: Springer, 2019: 612-629

[75]Sun Zequn, Zhang Qingheng, Hu Wei, et al. A benchmarking study of embedding-based entity alignment for knowledge graphs[J]. arXiv preprint,arXiv:2003.07743, 2020

[76]Du Jianfeng, Qi Kunxun, Wan Hai, et al. Enhancing knowledge graph embedding from a logical perspective[C] //Proc of the 7th Joint Int Semantic Technology Conf. Berlin: Springer, 2017: 232-247

[77]Zhong Huaping, Zhang Jianwen, Wang Zhen, et al. Aligning knowledge and text embeddings by entity descriptions[C] //Proc of the 20th Conf on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2015: 267-272

[78]Cui Peng, Wang Xiao, Pei Jian, et al. A survey on network embedding[J]. IEEE Transactions on Knowledge and Data Engineering, 2018, 31(5): 833-852

[79]Bo Deyu, Wang Xiao, Shi Chuan, et al. Structural deep clustering network[C] //Proc of the 29th Web Conf. New York: ACM, 2020: 1400-1410

[80]Shi Chuan, Hu Binbin, Zhao Wayne Xin, et al. Heterogeneous information network embedding for recommendation[J]. IEEE Transactions on Knowledge and Data Engineering, 2018, 31(2): 357-370

[81]Hu Linmei, Li Chen, Shi Chuan, et al. Graph neural news recommendation with long-term and short-term interest modeling[J]. Information Processing & Management, 2020, 57(2): 102142

[82]Serafini L, Garcez A D A. Logic tensor networks: Deep learning and logical reasoning from data and knowledge[J]. arXiv preprint, arXiv:1606.04422, 2016

[83]Badreddine S, Garcez A D A, Serafini L, et al. Logic tensor networks[J]. arXiv preprint, arXiv:2012.13635, 2020

[84]Hu Zhiting, Ma Xuezhe, Liu Zhengzhong, et al. Harnessing deep neural networks with logic rules[C] //Proc of the 54th Annual Meeting of the ACL. Stroudsburg, PA: ACL, 2016: 2410-2420

[85]Mintz M, Bills S, Snow R, et al. Distant supervision for relation extraction without labeled data[C] //Proc of the Joint Conf of the 47th Annual Meeting of the ACL and the 4th Int Joint Conf on Natural Language Processing. Stroudsburg, PA: ACL, 2009: 1003-1011

[86]Chang Xiaojun, Zhu Fengda, Bi Xiaoran, et al. Mining knowledge graphs for vision tasks[C] //Proc of the 27th Database Systems for Advanced Applications. Berlin: Springer, 2019: 592-594

[87]Li Du, Xiao Ding, Ting Liu, et al. Learning event graph knowledge for abductive reasoning[C] //Proc of the 59th Annual Meeting of the ACL. Stroudsburg, PA: ACL, 2021: 5181-5190

[88]Liu Kang. A survey on neural relation extraction[J]. Science China Technological Sciences, 2020, 63(10): 1971-1989

[89]Zhou Yang, Chen Yubo, Zhao Jun, et al. What the role is vs What plays the role: Semi-supervised event argument extraction via dual question answering[C] //Proc of the 34th AAAI Conf on Artificial Intelligence. Palo Alto, CA: AAAI, 2021: 14638-14646

[90]Cui Li, Yang Deqing, Cheng Jiayang, et al. Incorporating syntactic information into relation representations for enhanced relation extraction[C] //Proc of the 25th Pacific-Asia Conf on Knowledge Discovery and Data Mining. Berlin: Springer, 2021: 416-428

[91]Dhingra B, Zaheer M, Balachandran V, et al. Differentiable reasoning over a virtual knowledge base[J]. arXiv preprint, arXiv: 2002.10640, 2020

[92]Lamb L C, Garcez A, Gori M, et al. Graph neural networks meet neural-symbolic computing: A survey and perspective[J]. arXiv preprint, arXiv:2003.00330, 2020

[93]Ding Ming, Zhou Chang, Chen Qibin, et al. Cognitive graph for multi-hop reading comprehension at scale[C] //Proc of the 57th Annual Meeting of the ACL. Stroudsburg, PA: ACL, 2019: 2694-2703

[94]Zhang Wen, Paudel B, Zhang Wei, et al. Interaction embeddings for prediction and explanation in knowledge graphs[C] //Proc of the 12th ACM Int Conf on Web Search and Data Mining. New York: ACM, 2019: 96-104

[95]Cui Jiaxu, Yang Bo, Sun Bingyi, et al. Cost-aware graph generation: A deep Bayesian optimization approach[C] //Proc of the 35th AAAI Conf on Artificial Intelligence. Palo Alto, CA: AAAI, 2021: 7142-7150