谷歌公司于2012年提出了知识图谱(knowledge graph)的概念[1].知识图谱为组织、管理和理解海量的互联网数据信息提供了一种更好的手段.知识图谱作为人工智能领域的一个重要的分支,具备重要的作用,在搜索引擎、智能医疗、问答系统[2]等方面应用广泛,得到了学术界和工业界的广泛关注[3].目前,已经涌现出了许多知识图谱,具有代表性的有Freebase[4],DBpedia[5],YAGO[6],NELL[7]等.

知识图谱是由大量的三元组(头实体,关系,尾实体)构成的,也可以简写为(h,r,t),表示头实体h和尾实体t之间通过关系r连接.一个三元组描述一个事实,例如(英国,首都,伦敦)描述的是“英国的首都是伦敦”这一事实.基于符号表示的知识图谱三元组,虽然简洁,但是随着知识图谱规模的不断增加,数据稀疏性等问题更加突出,导致计算效率低下,在大规模知识图谱上很难实现高效推理.基于此,作为符号表示的补充,引入了知识图谱表示学习[8],其目的就是将知识图谱中的实体和关系投影到连续低维的向量空间,可以有效提高计算效率,并大大促进大规模知识图谱上的推理分析.

现有的大多数知识图谱表示学习及推理模型都仅考虑知识图谱中单一的三元组信息[9],然而,实体对之间往往存在大量的关系路径信息,并且每一个实体通常都有相对应的实体描述信息.这些关系路径和实体描述等信息蕴含着丰富的语义,能够为推理提供更确切可靠的辅助信息,从而能够显著提高知识图谱表示学习的能力,提高推理的准确性.目前,已有的引入额外信息的知识图谱表示方法只考虑在基于翻译模型的基础上,融合一种额外的信息,从而提高知识图谱表示学习的能力,例如,DKRL(description-embodied knowledge representation learning)模型[9]和PTransE(path-based TransE)模型[10].为了能够更好地提高知识图谱表示学习的能力,本文综合考虑了知识图谱中的关系路径与实体描述信息.

综上分析,本文提出了一种融合关系路径与实体描述信息的知识图谱表示学习方法(relation path and entity description information based knowledge graph representation learning, PDRL).本文的主要贡献简要描述为:

1) 提出了一个融合多源信息的知识图谱表示学习模型PDRL,包括三元组信息、关系路径信息以及实体描述信息,综合提高知识图谱表示学习的能力,进而进行推理.

2) 考虑实体描述中的语义信息,利用BERT(bidirectional encoder representations from trans-formers)模型[11]对其进行实体描述信息的编码表示;有效利用知识图谱中存在的大量关系路径信息,能够准确推理出实体对之间的直接关系,这里不仅考虑了关系路径上的关系信息,也考虑了关系路径上的实体信息.结合能够处理知识图谱中较为复杂关系的TransR模型,训练一个整合模型以提高知识图谱推理的性能.

3) 本文在FB15K,WN18,FB15K-237,WN18RR数据集上进行实验,在链接预测和三元组分类任务中,与其他基准模型相比,均取得了较好的效果.

1 相关工作

知识图谱表示学习在知识推理中发挥着重要的作用,基于知识图谱表示学习的推理是将知识图谱中包括实体和关系的元素映射到一个连续低维的向量空间中,为每一个元素学习在向量空间中的向量表示.关于知识图谱表示学习的代表性工作不少,接下来将从基于翻译思想和引入额外信息2个方面概述已有模型并分析其优缺点.

1.1 基于翻译思想的知识图谱表示学习模型

结构化嵌入(structured embedding, SE)模型[12]是知识图谱表示学习较早的尝试,它使用2个独立的矩阵为每个关系投影头尾实体,但矩阵的独立性将导致实体之间的协调性较差,并且在大型知识图谱上效果不够好.因此,文献[13]提出了一个最简单有效的知识图谱嵌入TransE模型,该模型将三元组中的关系看作是从头实体向量到尾实体向量的翻译,进而学习知识图谱中实体和关系的向量表示,该模型的灵感主要来源于文献[14].TransE模型假设给定任意一个正确的三元组(h,r,t),头实体的向量表示h*加上关系的向量表示r*应该等于尾实体的向量表示t*,基于此定义TransE模型的能量函数:

E(h,r,t)=‖h*+r*-t*‖,

(1)

当进行推理时,能量值最小的候选实体或关系就是推理出的结果.

尽管TransE模型的方法简单高效,能够较好地处理1对1的简单关系,但难以处理1对多、多对1和多对多等复杂关系.针对该问题,Wang等人[15]提出了TransH模型,该模型假设每一个关系r都有一个超平面,其法向量为wr,然后将实体h和t分别通过![]() 投影到该超平面.如果三元组(h,r,t)成立,则h*TransH+r*=t*TransH.TransH模型的能量函数为

投影到该超平面.如果三元组(h,r,t)成立,则h*TransH+r*=t*TransH.TransH模型的能量函数为

E(h,r,t)=‖h*TransH+r*-t*TransH‖.

(2)

Wen等人[16]在TransH的基础上,提出了m-TransH模型,直接建模多元关系.事实上,每个实体通常可以从多个方面描述,且不同关系可能关注实体的不同方面.因此,实体在不同关系中应具有不同的表示.TransH通过将实体投影到对应关系的超平面,虽然使实体在不同关系中的不同表示已成为可能,但实体、关系以及投影后的实体仍在一个相同的向量空间,这在一定程度上限制了实体和关系的语义表示能力.因此,Lin等人[17]提出了TransR模型,其将实体和关系通过关系矩阵Mr投影到不同的向量空间,即h*TransR=h*Mr,t*TransR=t*Mr,基于此定义TransR模型的能量函数:

E(h,r,t)=‖h*TransR+r*-t*TransR‖.

(3)

TransR模型通过区分实体向量和关系向量表示空间增加了模型的表达能力,并提升了表示学习的效果.然而,TransR模型为每个关系学习一个唯一的向量表示,这可能不足以适合所有与这个关系相关的实体对.因此,Lin等人[17]也提出了CTransR模型,通过将不同的实体对聚类成组,在每个组中学习关系的不同嵌入表示.除此以外,比较典型的嵌入表示模型还有TransD[18],TransM[19],TransA[20],TransG[21]等.

文献[12-21]所提的模型考虑的是在实数向量空间中的表示,最近还有一些模型考虑在复向量空间中进行表示学习.如文献[22]为了能够更好地建模对称和非对称关系,提出了RotatE模型,其将实体表示为复数向量空间中的点,关系表示为从头实体到尾实体的旋转.HAKE(hierarchy-aware knowledge graph embedding)模型[23]在RotatE模型的基础之上进行改进,通过极坐标的方法,结合实体的模信息和相位信息,并结合翻译模型的思想,提出了一种可以建模实体间语义层次关系的模型,进一步提高了知识图谱表示学习的性能.目前绝大多数模型对关系的建模方式是单一的,例如平移或者旋转,限制了底层模型的表达能力.为了包含更丰富的关系信息,文献[24]提出了对偶四元数知识图谱嵌入方法,将平移和旋转操作同时在对偶四元数空间中建模.

1.2 引入额外信息的知识图谱表示学习模型

1.1节所述方法虽然从某些角度解决了TransE的部分问题,但是仅考虑了知识图谱中单个三元组.事实上,除了三元组本身的结构信息之外,知识图谱中往往还包括关系路径、实体描述、属性信息及实体类型等丰富的额外信息,若知识图谱表示学习模型能够更好地利用这些多源信息,将进一步提高模型的语义表示能力,进而实现更好的推理.接下来将从3个方面对现有模型进行综述:

1) 在考虑实体间多步间接路径的语义关系方面.Lin等人[10]提出了PTransE模型,该模型是一种基于路径的模型,首先使用路径约束资源算法(path-constraint resource allocation, PCRA)来度量关系路径的置信度,然后将获取到的关系路径信息通过相加、相乘和循环神经网络的方式进行组合表示,最后将组合表示后的关系路径融入到知识表示学习模型中,取得了一定的成效.RTransE[25]模型也考虑了知识图谱中的关系路径.

2) 在考虑实体描述信息方面.Xie等人[9]将知识图谱中的实体描述信息融入到知识图谱表示学习当中,提出了DKRL模型,该模型分别使用卷积神经网络(convolutional neural network, CNN)和连续词袋模型(continuous bag-of-words, CBOW)对实体描述信息进行编码表示,同时利用事实三元组和实体描述信息进行学习,最后得到较好的推理效果.实际上,在大型的知识图谱中,有很多实体对应的实体描述信息缺失,基于此,Wang等人[26]引入了外部文本语料库,将文本语料库中的实体语义结构作为实体表示的一部分,从而进一步提高实体描述缺失情况下知识推理的准确性.文献[27]提出了一种规则引导的知识图谱联合嵌入学习模型,使用图卷积网络,将上下文信息与文本信息融合到实体与关系的嵌入表示中,进一步提高了实体和关系的表示能力.

3) 在考虑实体属性信息方面.文献[28]提出了一种结合实体属性信息的表示学习方法,使用深度卷积神经网络模型对实体属性信息进行编码,利用属性信息和三元组结构化信息学习知识表示,生成基于属性的实体表示,进一步提高了实体的表示能力.TransE及其扩展模型仅使用知识图谱之间的关系信息作为监督信号对实体嵌入施加约束,但实际上实体层次类也能够为知识表示学习提供重要的信息.Xie等人[29]提出了TKRL(type-embodied knowledge representation learning)模型,该模型融合了层次类型信息.除此之外,Xie等人[30]提出了IKRL(image-embodied knowledge representation learning)模型,将实体图像信息融合到知识表示学习当中.

此外,最近研究发现,之前的方法是对每一个实体或关系进行单一的静态表示,忽略了实体和关系在不同上下文对应的真正含义,也就是说在不同的上下文中,实体和关系的含义经常是不同的,需要根据上下文语义信息来判断采取怎样的表示.文献[31-32]将知识图谱中子图和路径作为某一实体的上下文语义信息,提出了结合语境的动态知识图谱表示学习的方法,在一定程度上取得了较好的效果.

文献[9-10]引入额外信息的知识图谱表示学习方法都仅在基于翻译模型的基础上,考虑知识图谱中的一种额外信息,融合方式单一,对知识图谱中的额外信息融合程度低,未能充分利用知识图谱中的额外信息,因此本文将知识图谱中的关系路径与实体描述信息进一步融合,促进知识图谱表示学习的性能.

2 融合关系路径与实体描述的知识图谱表示学习模型

现有的方法对关系路径进行表示时,绝大多数只考虑路径上的关系信息,没有考虑实体信息.DKRL模型对实体描述信息进行关键词抽取,使用CBOW和CNN对其编码表示,得到的表示没有包含实体描述的全部语义信息.针对该问题,本文提出了一种融合关系路径与实体描述信息的新型知识图谱表示学习方法,不仅考虑关系路径上的实体信息,而且能够表示出实体描述的全部语义信息,解决了实体描述中的一词多义的问题.将关系路径、实体描述与知识图谱三元组很好地结合,不仅提高了知识图谱中实体和关系的语义表示,也很大程度上促进了知识图谱推理的准确性.该方法可以充分利用知识图谱中关系路径与实体描述的信息,来进一步增强知识表示学习的能力,从而进行更好的推理.

2.1 概念及符号定义

为了能够更好地描述本文提出的模型,首先给出相关的符号定义.将一个知识图谱定义为KG=(E,R,T),其中E,R分别表示知识图谱中所有实体、关系的集合,T表示所有三元组(h,r,t)的集合,其中h,t∈E,r∈R.

定义1. 基于结构的表示.h*TransH,t*TransH,r*是头实体、尾实体和关系基于TransH的结构化向量表示;h*TransR,t*TransR,r*是头实体、尾实体和关系基于TransR的结构化向量表示.

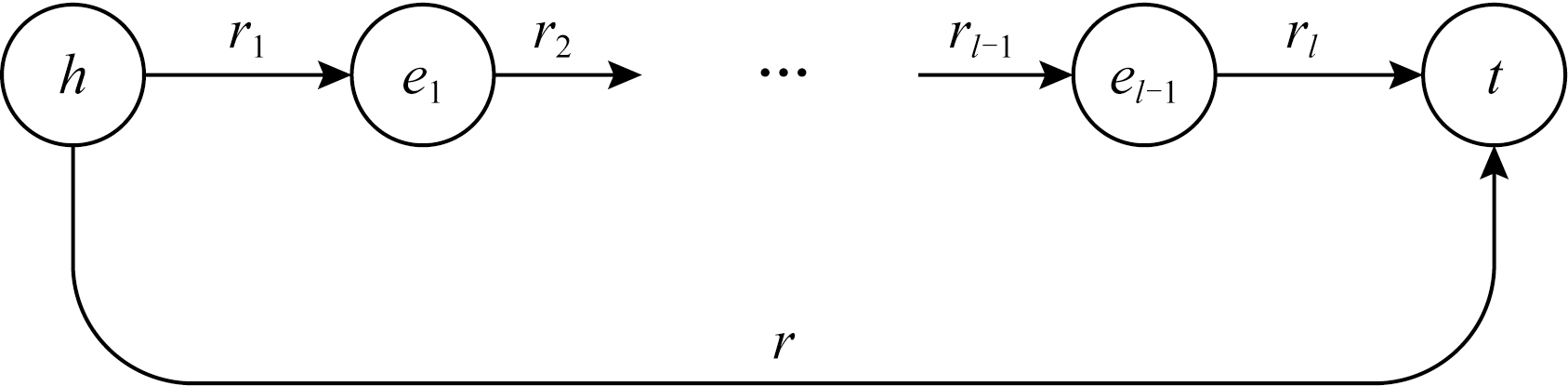

定义2. 基于关系路径的表示.如图1所示,给定一个实体对(h,t)之间的一个关系路径p=(r1,e1,…,el-1,rl),代表这个关系路径上有l个关系、l-1个实体.路径的向量表示p*是通过将关系路径中的实体和关系表示相加得到的.

Fig. 1 The example of relation path

图1 关系路径示例

定义3. 基于实体描述的表示.h*d和t*d是基于实体描述信息的实体向量表示,可以从对应的实体描述信息中建模头实体、尾实体的表示.

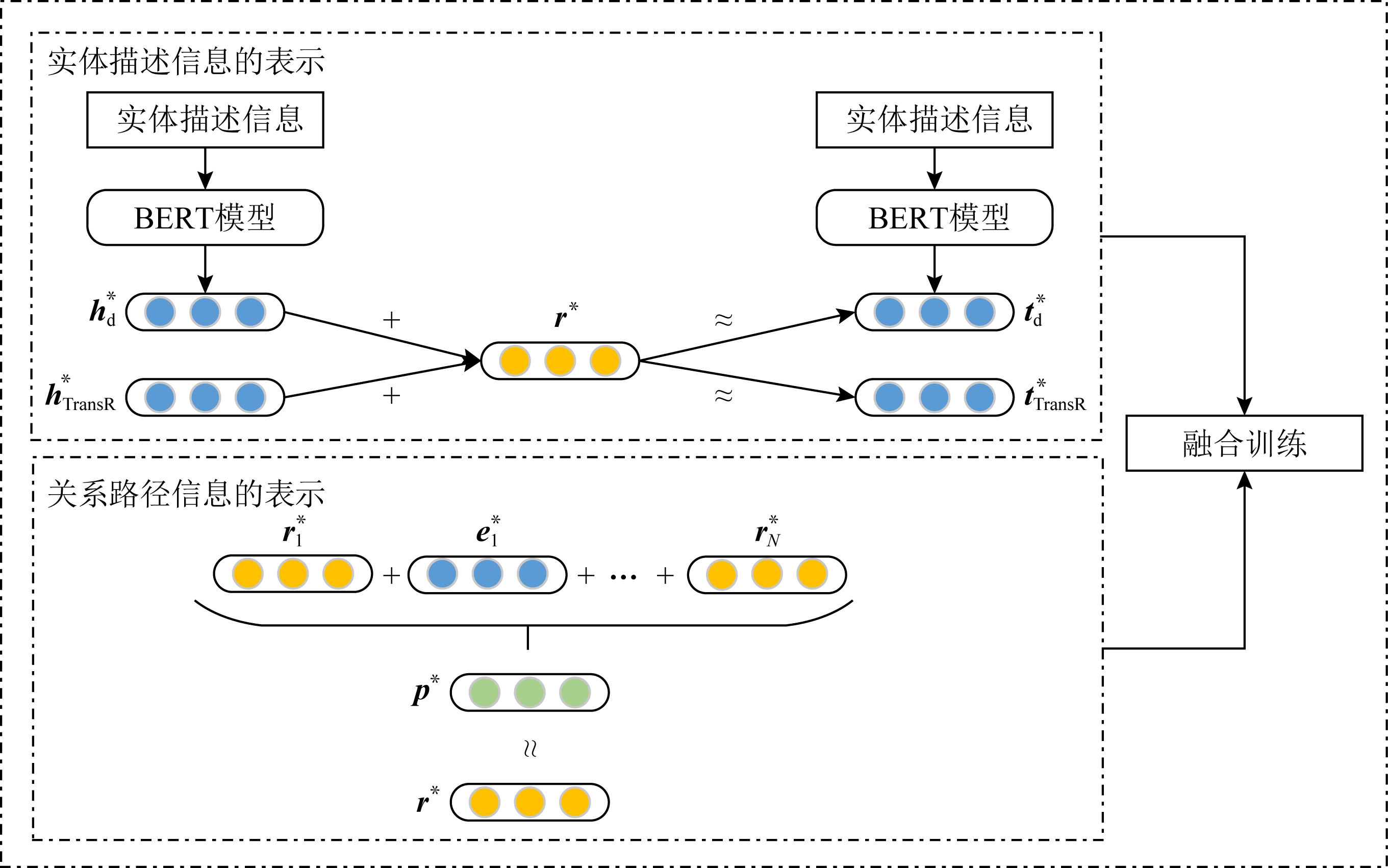

2.2 模型框架

本文综合考虑了关系路径和实体描述等信息,构建了PDRL模型.该模型是一个联合模型,主要由关系路径信息的表示和实体描述信息的表示2个模块组成,模型的总体架构如图2所示.当在不同模块采用不同算法策略时,可获得相应的算法模型,基于此,本文提出了PDRL,DKRL(BERT)+TransR,PTransR这3个算法实现模型.

1) PDRL.该模型是一个联合模型,主要包括2部分:①对知识图谱中实体对之间的多步关系路径进行表示;②考虑知识图谱中实体对之间的直接关系,联合知识图谱中三元组结构化信息以及实体描述信息进行表示.在关系路径信息的表示中,首先通过路径排序算法(path ranking algorithm, PRA)[33]获取知识图谱中实体对之间的关系路径信息,然后对关系路径进行表示得到组合向量,最后与实体对之间的直接关系向量进行相似度计算操作.在实体描述信息的表示中,首先使用BERT预训练模型对实体描述信息进行嵌入,然后得到实体描述的向量表示,最后将得到实体描述的向量表示与实体的向量表示在相同的向量空间中进行学习.最终,将2部分任务的结果进一步综合,共同训练学习,获取模型融合后实体和关系的向量表示,进而提高知识图谱的表示能力及推理性能.PDRL是在TransR的基础之上,融合了关系路径与实体描述进行知识图谱表示学习;PDRL(TransH)是在TransH的基础之上,融合了关系路径与实体描述进行知识图谱表示学习;PDRL(-Entity)是在PDRL的基础之上,对关系路径进行组合表示时,不使用关系路径上的实体信息.

2) DKRL(BERT)+TransR.该模型主要考虑实体描述信息的表示,在DKRL模型的基础之上,使用BERT预训练模型代替CNN对实体描述信息进行处理,得到实体描述的向量表示,然后结合能够解决实体对之间复杂关系的TransR模型,共同训练学习.

3) PTransR.该模型主要考虑关系路径信息的表示,在PTransE模型的基础之上,使用了能够解决实体对之间复杂关系的TransR模型代替TransE模型,进行训练学习.

Fig. 2 The architecture of PDRL model

图2 PDRL模型架构

2.3 关系路径信息的表示

在知识图谱中,多步关系路径可以提供看似不相连的实体对之间的关系,因此,本文在知识图谱表示学习中引入了知识图谱中的关系路径信息.假定2个实体h和t之间存在多条可以相连的关系路径,即P={p1,p2,…,pN},代表实体对h和t之间存在N条路径,一条关系路径示例如图1所示.

本文需要给路径三元组(h,p,t)定义一个类似TransE的能量函数.首先,对实体对之间的关系路径信息进行组合表示操作,在向量空间中表示关系路径p.虽然实体对之间的关系路径的语义信息很大程度上依赖路径上的关系,但是路径上的实体信息也对实体对之间的路径推理起着重要作用,因此,本文考虑关系路径上的关系和实体信息,将更有助于提高知识推理的准确性.

使用加法运算将关系路径的所有向量表示相加得到路径的组合向量表示,定义该路径的组合表示:

p*=r*1+e*1+…+e*l-1+r*l.

(4)

对于多步关系路径三元组(h,p,t),本文参考式(1)TransE模型的能量函数,将单条路径三元组的能量函数定义为E(h,p,t)=‖h*+p*-t*‖,进一步可以进行如下计算分析:

E(h,p,t)=‖h*+p*-t*‖=

‖p*-(t*-h*)‖=‖p*-r*‖=E(p,r),

(5)

由式(5)可以看出,如果关系路径p和实体对之间的关系r的向量的距离越近,即它们的相似度越高,则由路径p推理得出的关系r可能性就越高.

根据已有针对事实三元组(h,r,t)的路径约束资源分配算法[10],本文将考虑多条关系路径时的综合能量函数:

![]()

(6)

(7)

其中,p∈P(h,t)表示依次遍历实体对之间所有可能的关系路径,R(p|h,t)表示给定实体对(h,t)之间存在关系路径p的可靠性,Z是归一化因子,E(h,p,t)表示式(5)单条路径三元组(h,p,t)的能量函数.

并不是所有的关系路径都是可靠且对知识图谱表示学习是有意义的,而且实体对之间的关系路径会有很多,遍历所有的关系路径,计算消耗会很大,因此本文只考虑知识图谱中实体对之间2步和3步的关系路径.

2.4 实体描述信息的表示

DKRL模型[9]是一个经典的模型,该模型通过融合实体描述进行知识图谱表示学习.该模型首先对实体描述进行关键词提取,然后使用CBOW和CNN对其进行编码,得到相对应的表示,由于这些表示没有包含实体描述的全部语义信息,将会造成一定语义信息的损失.因此,本文引入了BERT模型[11],对完整的实体描述信息进行表示.实体描述信息作为BERT模型的直接输入,能够最小化信息的损失,尽可能获取实体描述的全部语义表示.

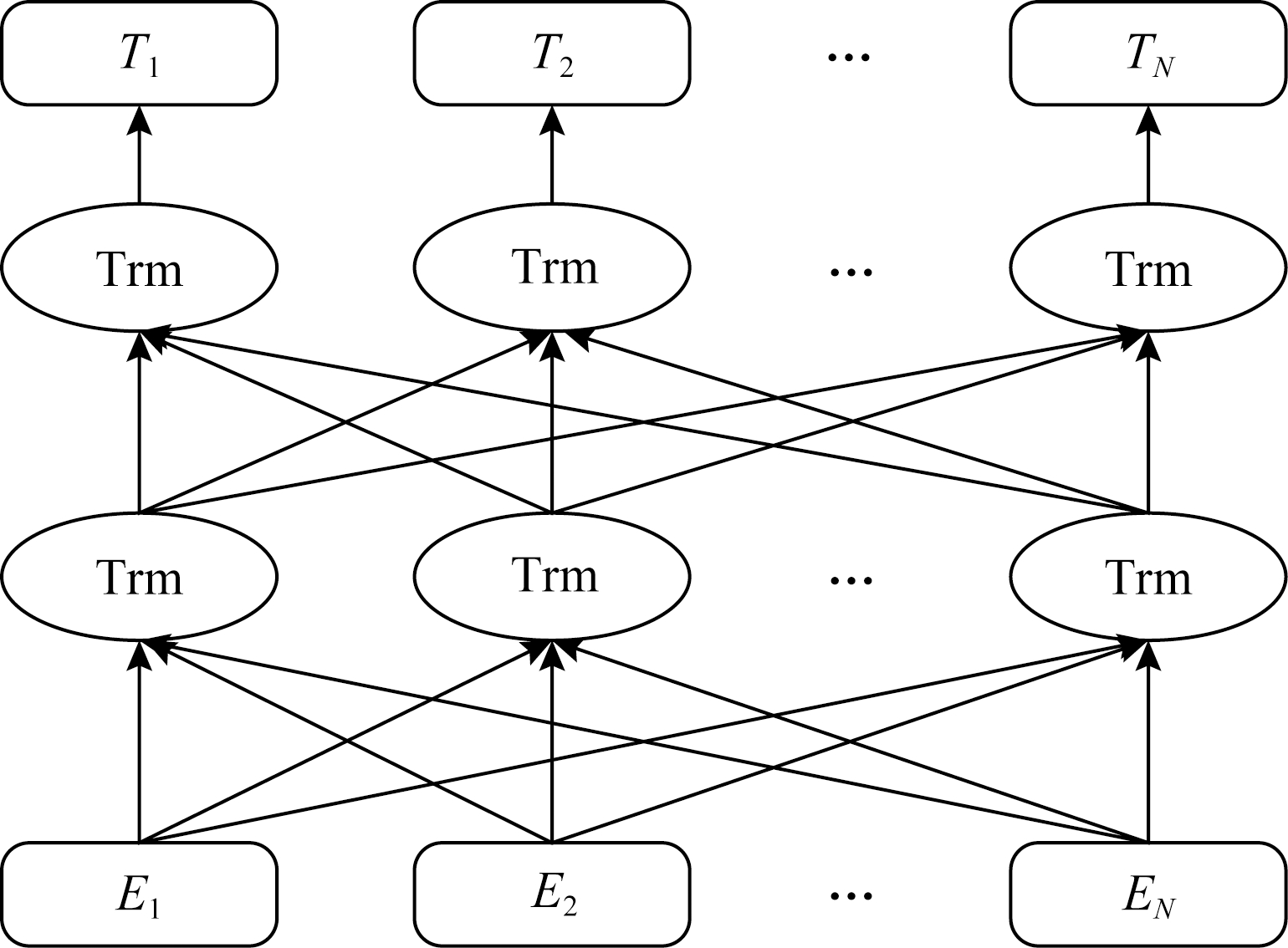

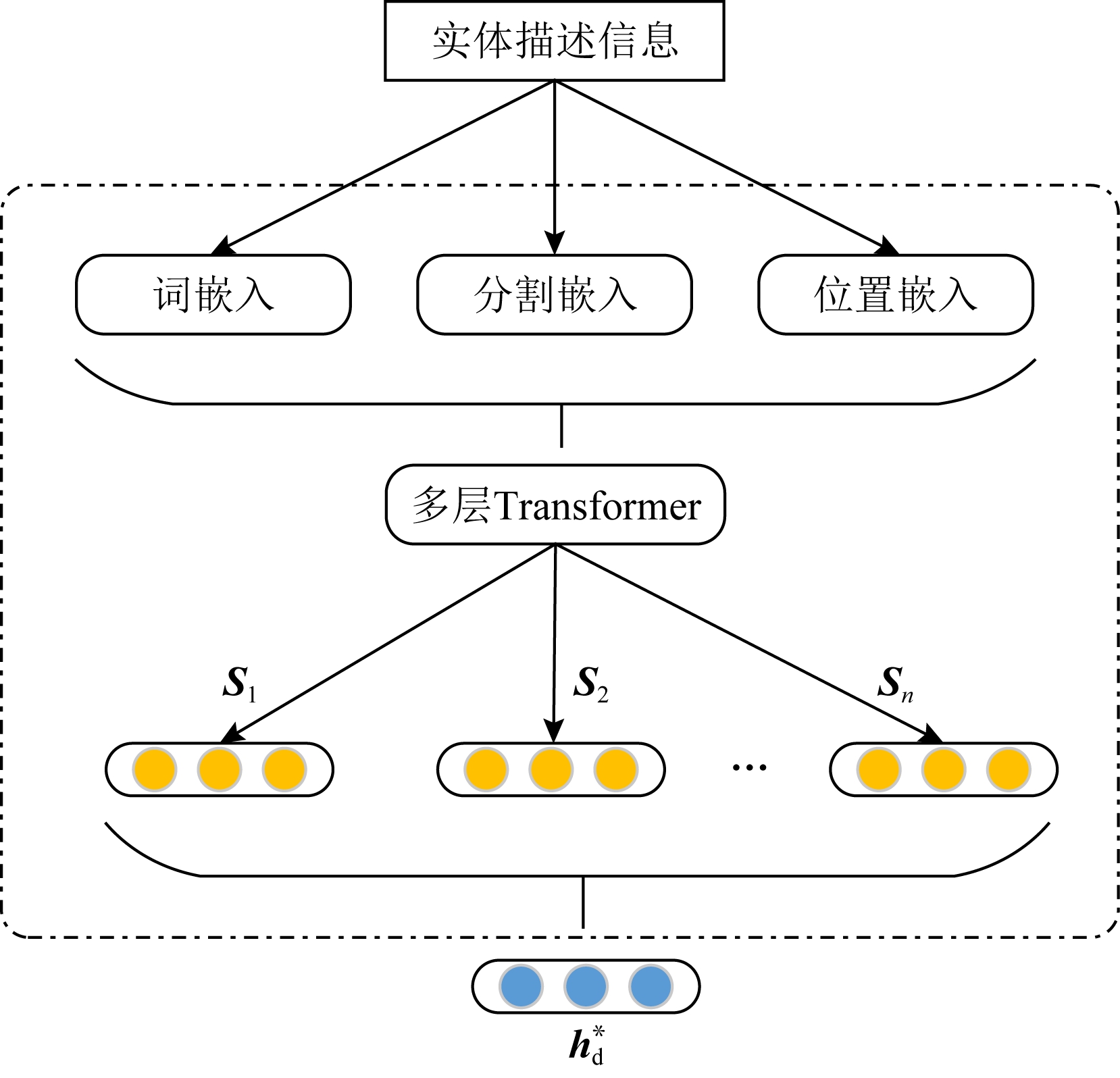

Fig. 3 BERT model structure[11]

图3 BERT模型结构图[11]

BERT模型[11]是谷歌于2018年发布的语言表示模型,在自然语言处理领域多项任务中都达到了最好的结果,是一项重要的突破,模型架构如图3所示.该模型使用了多层Transformer模型结构[34],能够捕捉语句中的双向关系,和循环神经网络(recurrent neural network, RNN)相比更加高效,能捕捉更长距离的依赖,在图3中用Trm表示Transformer模型.对比之前的预训练模型,它能够更好地捕捉文本的双向上下文信息.

本文基于官方给定的BERT语言表征模型[11]对实体描述信息进行编码建模.首先将实体描述信息转换为词嵌入、分割嵌入和位置嵌入;然后将其进行向量拼接,作为BERT模型的输入,通过多层Transformer结构,得到该实体描述信息的句向量;最后对所有的句向量求平均值,得到基于实体描述信息的向量表示,将其作为该实体对应的描述信息的实体表示.实体描述信息的整体建模流程,如图4所示,其中是Si(i=1,2,…,n)表示的是第i句的句向量.定义实体描述信息的向量表示h*d:

(8)

Fig. 4 The representation of entity description information

图4 实体描述信息的表示

通过将知识图谱中的三元组和实体描述信息相结合,能够更好地学习实体和关系的最优向量表示.基于结构的表示能够较好地捕捉知识图谱的事实三元组信息,而基于实体描述的表示能够较好地捕捉文本信息.通常情况下,相似的实体应该有相似的描述信息,并且有相似的关键词.这些关系难以通过结构信息直接得到,但通过关键词的内在联系可能会发现这些关系.在相同的连续低维的向量空间中,对基于结构的表示和基于实体描述信息的表示同时进行学习,将有可能得到更好的表示能力.由此,本文将基于实体描述信息表示的能量函数定义为

Ed=Edd+Eds+Esd,

(9)

其中,Edd=‖h*d+r*-t*d‖,Eds=‖h*d+r*-t*s‖,Esd=‖h*s+r*-t*d‖.h*s和t*s代表基于结构的表示;h*d和t*d代表基于实体描述信息的表示.Edd代表头尾实体都是基于实体描述信息表示的能量函数;Eds代表头实体是基于实体描述的表示、尾实体是基于结构表示的能量函数;Esd代表头实体是基于结构表示、尾实体是基于实体描述表示的能量函数.基于这种方式定义能量函数,能够同时将结构、实体描述等信息应用到训练学习中,从而更好地获取实体和关系的向量表示.

2.5 模型训练

为了更好地学习实体和关系的最优化表示,本文的PDRL模型通过将知识图谱的三元组结构信息、关系路径和实体描述结合起来,综合进行模型的训练.在相同的连续低维的向量空间中,学习实体和关系的向量表示.综合的能量函数定义为

E=Es+Ep+Ed,

(10)

其中,Es是基于结构表示的能量函数,基于具体的实现算法不同可采用TransH或TransR所定义的能量函数,Ep是式(6)定义的基于关系路径表示的能量函数,Ed是式(9)定义的基于实体描述信息表示的能量函数.

基于式(10),可得到基于结构表示和实体描述表示的能量函数,当Es分别采用TransH,TransR的定义时,可得具体的计算表达式,下面具体说明.

1) 在TransH基础上融合实体描述模型的能量函数:

ETransH(h,r,t)=‖h*TransH+r*-t*TransH‖+

‖h*d+r*-t*d‖+‖h*d+r*-t*TransH‖+

‖h*TransH+r*-t*d‖,

(11)

其中,![]()

2) 在TransR基础上融合实体描述模型的能量函数:

ETransR(h,r,t)=‖h*TransR+r*-t*TransR‖+

‖h*d+r*-t*d‖+‖h*d+r*-t*TransR‖+

‖h*TransR+r*-t*d‖,

(12)

其中,h*TransR=h*Mr,t*TransR=t*Mr.

在上述计算分析的基础上,进一步构造出损失函数.定义基于边界的优化方法,并将其作为训练目标,通过最小化损失函数L来优化该模型:

![]()

![]()

(13)

其中

![]()

E(h,r,t)-E(h′,r,t′),0),

(14)

![]()

E(p,r)-E(p,r′),0),

(15)

其中,γ是衡量正确三元组和错误三元组的边界参数.E(h,r,t)是基于结构和实体描述信息的能量函数,当使用基于TransH结构化模型时,E(h,r,t)=ETransH(h,r,t);当使用基于TransR结构化模型时,E(h,r,t)=ETransR(h,r,t).E(p,r)是基于关系路径的能量函数.T是由正确三元组(h,r,t)构成的正例集合,T′是由错误三元组(h′,r′,t′)构成的负例集合.给出T′的定义:

T′={(h′,r,t)|h′∈E,(h′,r,t)∉T}∪

{(h,r′,t)|r′∈R,(h,r′,t)∉T}∪

{(h,r,t′)|t′∈E,(h,r,t′)∉T},

(16)

式(16)中的T′是通过随机替换正例集合中的头实体、尾实体或者关系,得到相对应的负实例集合.在模型训练过程中,使用随机梯度下降法进行优化操作,使其损失函数的值最小化.

3 实验结果及分析

3.1 实验数据集

本文实验采用的数据集是FB15K[13],WN18[35],FB15K-237[36],WN18RR[37]标准数据集,数据集中的实体都有相对应的简短描述信息.其中,FB15K是从大规模知识库FreeBase[4]中提取得到的,FB15K-237是FB15K的一个子集,并删除了FB15K中的反向关系;WN18是从WordNet[38]知识库中提取出来的,WN18RR是WN18的一个子集,并删除了WN18中的反向关系.本文将数据集分别划分为训练数据集、验证数据集和测试数据集.所用数据集的相关情况,如表1所示:

Table 1 Statistics of the Used Datasets

表1 所用数据集统计情况

数据集实体数关系数训练集验证集测试集FB15K1490413414728604899157803WN18409431814144250005000FB15K-237145412372721151753520466WN18RR40943118683530343134

3.2 测试模型和参数设置

3.2.1 测试模型

实验采用的具有代表性的部分基准模型包括:1)TransE[13];2)TransH[15];3)TransR[17];4)DistMult[39];5)ComplEx[40];6)ConvE[37];7)MINERVA[41];8)RotatE[22];9)DKRL(CNN)+TransE[9],该基准模型采用将CNN编码得到的实体描述信息表示与TransE相结合共同训练学习的方法;10)PTransE[10],该基准模型采用将得到的关系路径信息表示与TransE相结合共同训练学习的方法.

基于本文所提出的模型框架,可实现的预测模型包括:

1) DKRL(BERT)+TransR.该模型综合了通过BERT模型编码得到的实体描述向量表示与TransR一起进行训练学习;

2) PTransR.该模型是在PTransE的基础之上,将关系路径与TransR一起进行训练学习;

3) PDRL(TransH).该模型综合了基于关系路径的信息、基于实体描述的信息和基于TransH的结构信息,共同进行训练学习;

4) PDRL.该模型综合了基于关系路径的信息、基于实体描述的信息和基于TransR的结构信息,共同进行训练学习;

5) PDRL(-Entity).在PDRL的基础之上,对关系路径进行表示时,不使用关系路径信息上的实体信息,进行训练学习.

3.2.2 参数设置

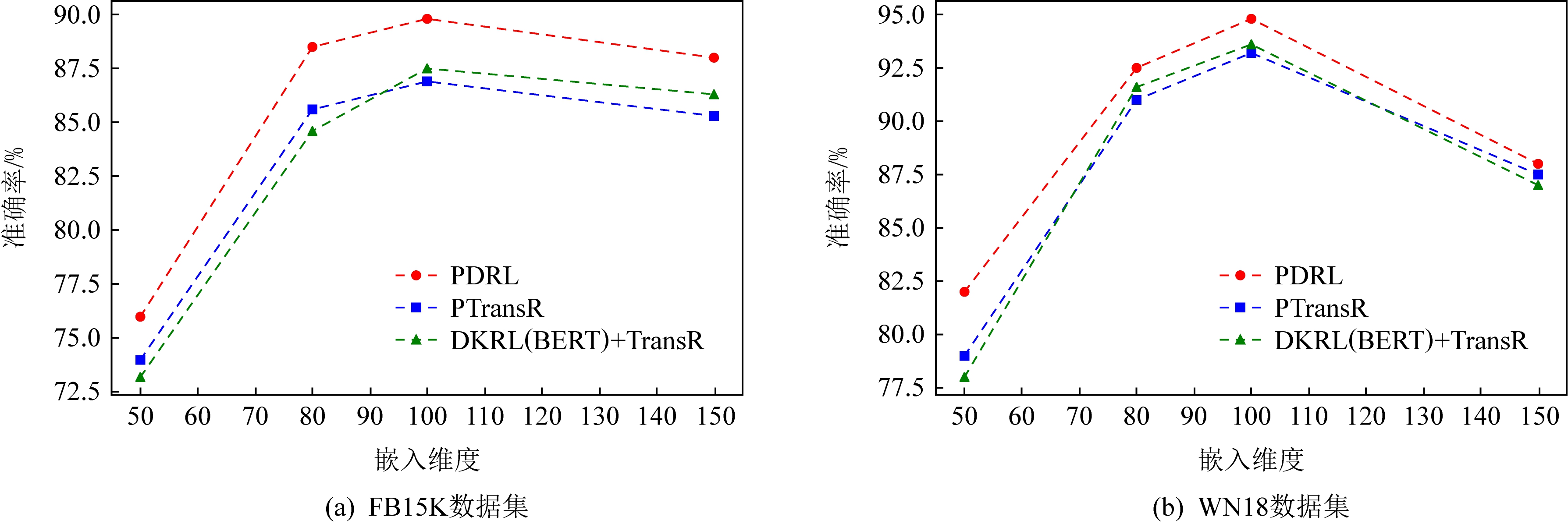

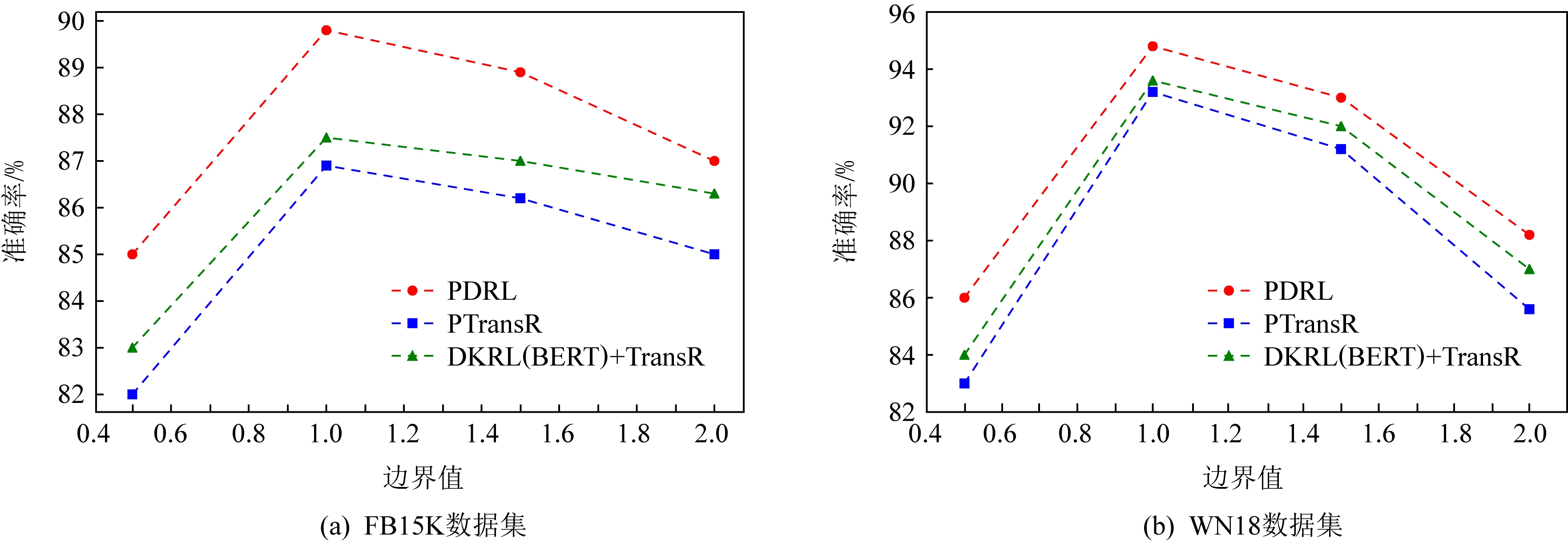

模型调试过程中,如何获取最优的参数是非常重要的.模型训练时,设置参数包括:学习率λ∈{0.0005,0.001,0.002},边界值γ∈{0.5,1.0,1.5,2.0},实体、关系和实体描述向量表示的维度D∈{50,80,100,150},batch的大小B∈{64,128,256,512,640,768}.通过实验,得出本文所提预测模型的最优参数设置为:学习率λ=0.001,边界值γ=1.0,向量维度D=100,采用L1正则化参数优化,并将惩罚因子设置为0.01,batch大小设置为512.

3.3 实验结果和分析

本文实验包括链接预测和三元组分类2个任务.这一部分将给出这2个任务的实验结果并进行相应的分析.由于实体对之间的关系路径会有很多,若遍历所有长度的关系路径,计算消耗将会很大,因此,本文在模型效果验证和分析中重点以知识图谱中实体对之间的2步和3步的关系路径为主.

3.3.1 链接预测

链接预测任务是给定一个三元组(h,r,t)中的任意2项,然后去预测其余一项,即预测知识图谱中三元组缺失的实体或者关系,主要分为实体预测和关系预测2种.实体预测的任务旨在预测知识图谱中三元组缺失的实体,即预测缺失三元组(h,r,?)中的尾实体t或预测缺失三元组(?,r,t)中的头实体h.关系预测旨在预测给定2个实体之间的关系信息,即预测缺失三元组(h,?,t)中的关系r.对于这项任务,现有研究通常根据得分函数对候选实体或关系进行排序,本文同样采用这种方法.

链接预测任务通常采用的评估指标主要有3个:平均倒数排名(mean reciprocal rank, MRR)、平均排名(mean rank, MR)和前n命中率(Hits@n).下面详细介绍:

1) MRR.所有正确三元组的实体或关系的倒数排名的平均值,该指标的值越大,说明模型的性能越好.

2) MR.所有正确三元组的实体或关系的排名的平均值,该指标的值越小,说明模型的性能越好.

3) Hits@n.表示排名前n中的命中率,即所有正确三元组的实体或关系的排名在前n%的比例,该指标的值越大,说明模型的表示学习的能力越强,表示越准确.在本实验中,使用Hits@1和Hits@10对实验结果进行评估.

此外,还存在一个问题,在构造负样本时,替换头实体、尾实体或者关系之后,所构成的新三元组可能在知识图谱中已经存在,这就可能干扰正确三元组的实际排名情况,对评测结果产生一定的影响.因此,本文在进行链接预测实验时,根据是否过滤已经存在的三元组,将其分为“原始(raw)”和“过滤(filter)”两种方式.

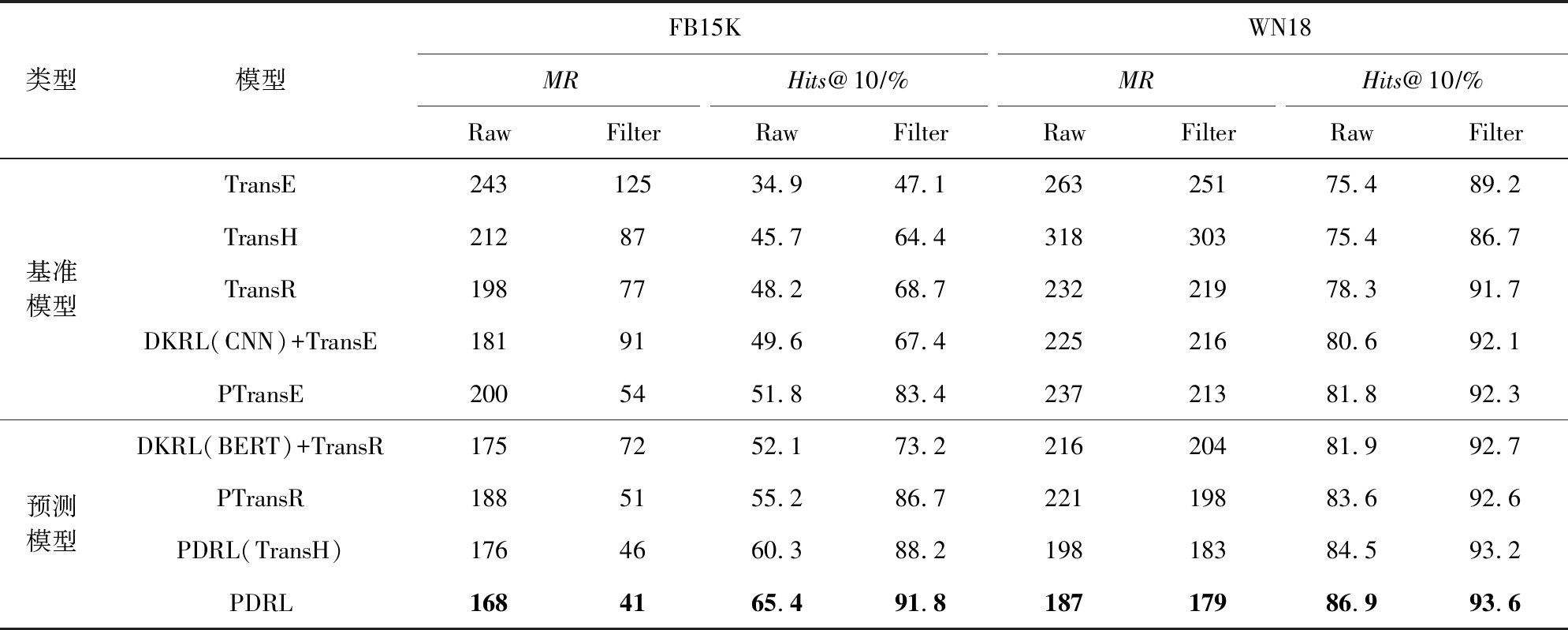

本文实现的多个模型以及基准模型在FB15K和WN18数据集上进行实体预测和关系预测的实验结果,分别如表2和表3所示.在FB15K-237和WN18RR数据集上链接预测的实验结果,如表4所示.

从表2的结果可以观察分析得到:

1) 在FB15K和WN18这2个数据集上,DKRL(BERT)+TransR模型的效果都要比DKRL(CNN)+TransE模型更好,在FB15K数据集上,Hits@10(filter)提升了5.8%.这不仅表明使用BERT模型能够更好地得到实体描述信息的语义表示,也表明了结合基于TransR模型共同训练,能够更好地利用知识图谱的结构信息,处理较为复杂的关系信息,效果更好.

Table 2 Entity Prediction Results on FB15K and WN18 Datasets

表2 在FB15K和WN18数据集上实体预测的评估结果

类型模型FB15KWN18MRHits@10∕%MRHits@10∕%RawFilterRawFilterRawFilterRawFilter基准模型预测模型TransE24312534.947.126325175.489.2TransH2128745.764.431830375.486.7TransR1987748.268.723221978.391.7DKRL(CNN)+TransE1819149.667.422521680.692.1PTransE2005451.883.423721381.892.3DKRL(BERT)+TransR1757252.173.221620481.992.7PTransR1885155.286.722119883.692.6PDRL(TransH)1764660.388.219818384.593.2PDRL1684165.491.818717986.993.6

注:黑体数值表示性能最好的结果.

2) PTransR模型的性能比PTransE模型表现优异,也表明了在对关系路径进行建模训练时,结合基于TransR的效果比基于TransE的效果要好,因为TransR能够解决知识图谱中较为复杂的关系信息.

3) 在FB15K和WN18数据集上,DKRL(BERT)+TransR和PTransR在各个评估指标上都优于TransR,这表明在基于TransR的结构化模型上,不管融合关系路径信息,还是实体描述信息,都能够在一定程度上提高知识图谱中实体和关系的表示能力,进一步促进对实体的预测.这是因为基于结构化的模型只考虑了三元组的结构化信息,当缺失相应的信息时,将无法进行预测,关系路径和实体描述信息可以作为基于结构化模型的有利补充,从而提高知识图谱表示学习的能力和预测的性能.

4) 在2个数据集上,本文提出的PDRL模型在MR和Hits@10的评估指标上均优于所有基准模型.在FB15K数据集上,与基准模型中效果最好的PTransE模型相比,MR(filter)降低了24%,Hits@10(filter)提升了8.4%.这个对比结果表明,PDRL模型比其他的基准模型更具有精确的知识表示能力.综合基于关系路径的信息、基于实体描述的信息和基于TransR的结构信息,能够很好地对知识图谱中的实体和关系进行表示,促进实体预测的推理性能,在一定程度上提高预测的精度.

5) 对比PDRL(TransH)和PDRL的实验结果,可以发现PDRL的效果要比PDRL(TransH)好.这表明在PDRL模型融合关系路径与实体描述的基础上,结合能够更好地处理知识图谱中复杂关系的结构化模型,能够使本文提出的PDRL模型具有更好的表示能力,从而提高实体预测的精度.

6) 对比DKRL(BERT)+TransR,PTransR,PDRL的实验结果,可以发现PDRL的效果比另两个模型的效果都好.在FB15K数据集上,评估指标Hits@10(filter)比DKRL(BERT)+TransR提升了18.6%,比PTransR提升了5.1%,MR(filter)比DKRL(BERT)+TransR降低了31,比PTransR降低了10.这个对比结果表明,同时融合关系路径与实体描述的语义信息比只使用关系路径或者实体描述信息在提高模型的知识图谱表示学习能力方面更加有效.

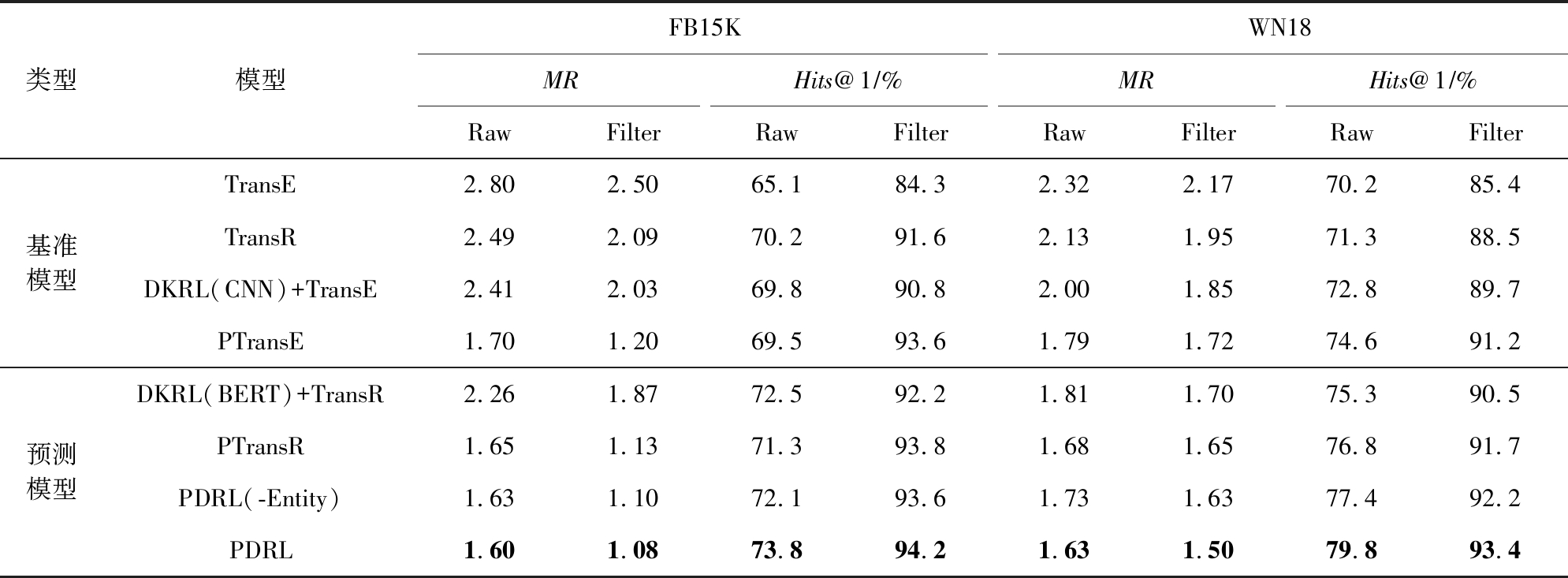

从表3的结果可以观察分析得到:

1) 本文提出的模型DKRL(BERT)+TransR模型和模型PTransR在MR和Hits@1的评估指标上都优于基准模型.这表明,融入实体描述信息和关系路径信息,都能够很好地提高关系预测的准确性.同时,使用BERT模型代替CNN对实体描述信息进行处理,也表明了提高实体描述信息的语义表示能力也能够更好地得到知识图谱中实体和关系的表示,从而提高关系预测的精度.

2) 对比PDRL(-Entity)和PDRL的评估结果,差别不是很明显,但也表明了对关系路径进行表示时引入实体信息,在一定程度上更有助于对实体对之间关系的预测.

3) 本文提出的PDRL模型优于其他模型的效果.这表明,同时融入关系路径与实体描述,可以作为基于结构化模型的补充,能够提高知识图谱表示学习能力,促进关系的预测.

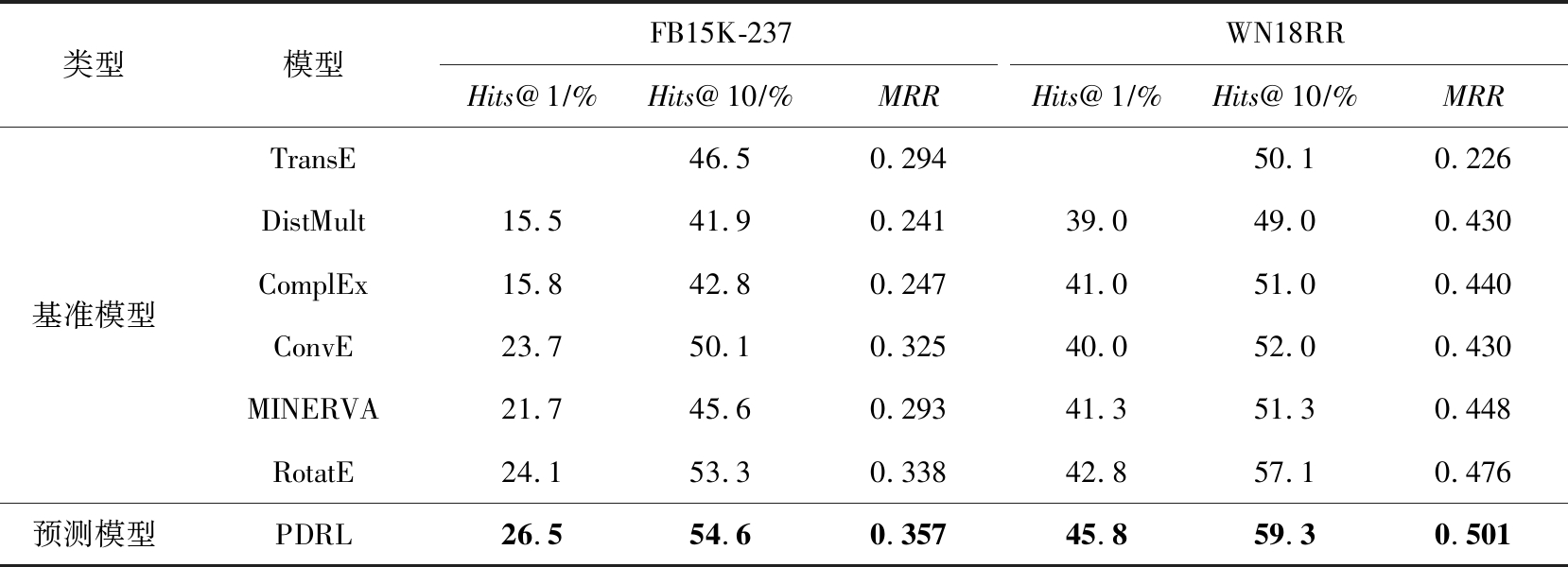

在链接预测实验中,本文还评估了PDRL模型与一些较为先进的基准模型在FB15K-237和WN18RR数据集上的实验效果.从表4可以看出:

1) 本文提出的PDRL模型与其他先进的基准模型相比,达到了更高的水平.在FB15K-237和WN18RR这2个数据集上,与基准模型中最好的结果相比,PDRL模型在评估指标Hits@1上分别提升了2.4%和3%,这表明PDRL模型通过融合关系路径与实体描述信息对基于结构化的TransR模型进行了有利的补充,能够较好地提高知识图谱表示学习的能力,从而提高预测的性能.

2) 对比PDRL模型和MINERVA的实验结果,可以发现PDRL的效果比MINERVA的效果好.这表明,在基于结构化的模型上,引入关系路径与实体描述信息,比单独地使用强化学习通过关系路径对知识图谱中缺失的信息进行预测的性能好.

Table 3 Relation Prediction Results on FB15K and WN18 Datasets

表3 在FB15K和WN18数据集上关系预测的评估结果

类型模型FB15KWN18MRHits@1∕%MRHits@1∕%RawFilterRawFilterRawFilterRawFilter基准模型预测模型TransE2.802.5065.184.32.322.1770.285.4TransR2.492.0970.291.62.131.9571.388.5DKRL(CNN)+TransE2.412.0369.890.82.001.8572.889.7PTransE1.701.2069.593.61.791.7274.691.2DKRL(BERT)+TransR2.261.8772.592.21.811.7075.390.5PTransR1.651.1371.393.81.681.6576.891.7PDRL(-Entity)1.631.1072.193.61.731.6377.492.2PDRL1.601.0873.894.21.631.5079.893.4

注:黑体数值表示性能最好的结果.

Table 4 Link Prediction Results on FB15K-237 and WN18RR

表4 链接预测的评估结果

类型模型FB15K-237WN18RRHits@1∕%Hits@10∕%MRRHits@1∕%Hits@10∕%MRR基准模型预测模型TransE46.50.29450.10.226DistMult15.541.90.24139.049.00.430ComplEx15.842.80.24741.051.00.440ConvE23.750.10.32540.052.00.430MINERVA21.745.60.29341.351.30.448RotatE24.153.30.33842.857.10.476PDRL26.554.60.35745.859.30.501

注:黑体数值表示性能最好的结果.

3.3.2 三元组分类

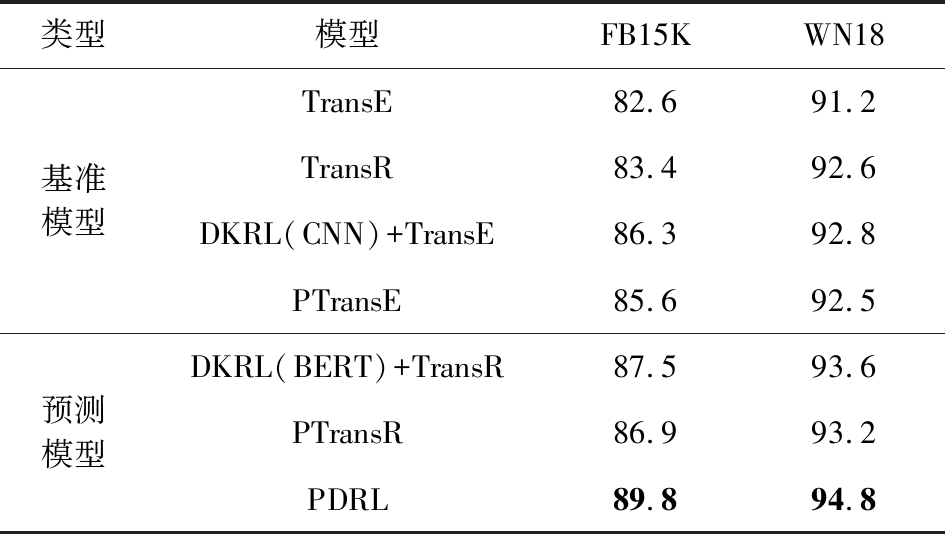

三元组分类任务旨在判断给定的一个三元组(h,r,t)是否正确,可以视为一个二分类任务.为每个关系设置特定的阈值σ,如果三元组(h,r,t)的距离得分小于这个阈值σ,就认为这个三元组是正确的,否则是错误的.实验最终的评估标准为所有关系评估指标的平均值.阈值σ是通过在验证集上训练、最大化分类准确率得到的.本节实验采用与链接预测任务相同的实验设置,构造负样本时,为了平衡数据,使产生的负样本数量与正样本数量一致.各个模型在FB15K和WN18数据集上三元组分类的实验结果,如表5所示.

从表5的结果可以观察分析得到,本文提出的3个模型在三元组分类任务中的表现均优于其他基准模型,其中PDRL模型的效果最好,在FB15K和WN18数据集上,与TransE模型相比,PDRL模型的准确率分别提高了7.2%和3.6%.这表明融合关系路径与实体描述信息,对知识图谱表示学习具有更好的促进作用,能够更准确地判断三元组,进而提高知识推理的性能.

为了能够进一步分析参数的设置对模型的影响,给出了3个预测模型训练的参数调试示意图,如图5和图6所示.设定模型的最优学习率λ=0.001,在FB15K和WN18数据集上分别比较了PDRL,DKRL(BERT)+TransR,PTransR这3个预测模型随着嵌入维度和边界参数的变化,三元组分类任务的准确率的变化情况.从图5和图6中可以直观地观察到:1)即使没有参数的调试,和其余2个模型相比,PDRL模型也具有较高的三元组分类能力;2)在2个数据集上,嵌入维度D=100,边界值γ=1.0时,3个模型三元组分类的准确率都达到最高.

Table 5 Accuracy on Triple Classification

表5 三元组分类的准确率 %

类型模型FB15KWN18基准模型预测模型TransE82.691.2TransR83.492.6DKRL(CNN)+TransE86.392.8PTransE85.692.5DKRL(BERT)+TransR87.593.6PTransR86.993.2PDRL89.894.8

注:黑体数值表示性能最好的结果.

Fig. 5 Tuning of embedding dimensions

图5 嵌入维度的调试

Fig. 6 Tuning of margin

图6 边界参数的调试

4 总 结

本文提出了一种融合关系路径与实体描述的新型知识图谱表示学习模型,即PDRL模型.该模型综合考虑了知识图谱中的关系路径信息和实体描述信息.首先,对实体对之间的关系路径上的实体和关系信息进行组合表示,得到相对应的关系路径向量表示,并与实体对之间的关系进行了相似度计算;然后,通过BERT模型对实体描述信息进行编码表示,得到实体相对应的实体描述信息表示,在此基础上将实体描述信息表示与TransR模型相结合;最后,整合为一个联合模型,共同训练学习.在FB15K,WN18,FB15K-237,WN18RR数据集上的实验结果表明,本文提出的PDRL模型能够很好地提升链接预测和三元组分类任务的性能,从而能够更好地支撑知识推理.

在未来的工作中,我们将进一步研究基于知识图谱表示学习的推理技术,并希望能够在3个方面进行改进:1)在多步关系路径的语义获取中,可以考虑使用强化学习来获取实体对之间的关系路径,提高关系路径表示的质量.2)在实体描述信息的处理中,可以考虑互联网中的文本信息,补充实体对应的实体描述信息缺失的情况,扩充文本信息的来源.同时,也可以使用注意力机制,提升实体描述表示的性能.3)可以考虑融合更多的知识图谱的额外信息,例如属性信息和实体类型信息,综合提高知识图谱表示学习的性能.

作者贡献声明:宁原隆提出研究方法,负责完成实验,撰写论文,并修改与校对论文;周刚负责论文的指导工作,提出修改意见并审核论文;卢记仓负责论文结构的指导,以及内容的修改和校对;杨大伟负责部分实验的指导;张田负责审阅和校对论文.

[1]Chen Xiaojun, Jia Shengbin, Xiang Yang. A review: Knowledge reasoning over knowledge graph[J]. Expert Systems with Applications, 2020, 141: 112948

[2]Bordes A, Weston J, Usunier N. Open question answering with weakly supervised embedding models[C] //Proc of the Joint European Conf on Machine Learning and Knowledge Discovery in Databases. Berlin: Springer, 2014: 165-180

[3]Zou Xiaohan. A survey on application of knowledge graph[G] //Journal of Physics: Conference Series 1487: Proc of the 4th Int Conf on Control Engineering and Artificial Intelligence. Bristol, UK: IOP Publishing, 2020: 012016

[4]Bollacker K, Evans C, Paritosh P, et al. Freebase: A collaboratively created graph database for structuring human knowledge[C] //Proc of the 2008 ACM SIGMOD Int Conf on Management of Data. New York: ACM, 2008: 1247-1250

[5]Auer S, Bizer C, Kobilarov G, et al. DBpedia: A nucleus for a Web of open data[M] //The Semantic Web. Berlin: Springer, 2007: 722-735

[6]Suchanek F M, Kasneci G, Weikum G. YAGO: A large ontology from Wikipedia and WordNet[J]. Journal of Web Semantics, 2008, 6(3): 203-217

[7]Carlson A, Betteridge J, Kisiel B, et al. Toward an architecture for never-ending language learning[C] //Proc of the 24th AAAI Conf on Artificial Intelligence. Palo Alto, CA: AAAI Press, 2010: 1306-1313

[8]Liu Zhiyuan, Sun Maosong, Lin Yankai, et al. Knowledge representation learning: Review[J]. Journal of Computer Research and Development, 2016, 53(2): 247-261 (in Chinese)(刘知远, 孙茂松, 林衍凯, 等. 知识表示学习研究进展[J]. 计算机研究与发展, 2016, 53(2): 247-261)

[9]Xie Ruobing, Liu Zhiyuan, Jia Jia, et al. Representation learning of knowledge graphs with entity descriptions[C] //Proc of the 30th AAAI Conf on Artificial Intelligence. Palo Alto, CA: AAAI Press, 2016: 2659-2665

[10]Lin Yankai, Liu Zhiyuan, Luan Huanbo, et al. Modeling relation paths for representation learning of knowledge bases[C] //Proc of the 2015 Conf on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2015: 705-714

[11]Devlin J, Chang Mingwei, Lee K, et al. BERT: Pre-training of deep bidirectional transformers for language understanding[C] //Proc of the Conf of the North American Chapter of the ACL: Human Language Technologies. Stroudsburg, PA: ACL, 2019: 4171-4186

[12]Bordes A, Weston J, Collobert R, et al. Learning structured embeddings of knowledge bases[C] //Proc of the 25th AAAI Conf on Artificial Intelligence. Palo Alto, CA: AAAI Press, 2011: 301-306

[13]Bordes A, Usunier N, Garcia-Duran A, et al. Translating embeddings for modeling multi-relational data[C] //Proc of Advances in Neural Information Processing Systems(NIPS). Cambridge, MA: MIT Press, 2013: 2787-2795

[14]Mikolov T, Chen Kai, Corrado G, et al. Efficient estimation of word representations in vector space[J]. arXiv preprint, arXiv:1301.3781, 2013

[15]Wang Zhen, Zhang Jianwen, Feng Jianlin, et al. Knowledge graph embedding by translating on hyperplanes[C] //Proc of the 28th AAAI Conf on Artificial Intelligence. Palo Alto, CA: AAAI Press, 2014: 1112-1119

[16]Wen Jianfeng, Li Jianxin, Mao Yongyi, et al. On the representation and embedding of knowledge bases beyond binary relations[C] //Proc of the 25th Int Joint Conf on Artificial Intelligence. Palo Alto, CA: AAAI Press, 2016: 1300-1307

[17]Lin Yankai, Liu Zhiyuan, Sun Maosong, et al. Learning entity and relation embedding for knowledge graph completion[C] //Proc of the 29th AAAI Conf on Artificial Intelligence. Palo Alto, CA: AAAI Press, 2015: 2181-2187

[18]Ji Guoliang, He Shizhu, Xu Liheng, et al. Knowledge graph embedding via dynamic mapping matrix[C] //Proc of the 53rd Annual Meeting of the ACL and the 7th Int Joint Conf on Natural Language Processing, Vol 1. Stroudsburg, PA: ACL, 2015: 687-696

[19]Fan Miao, Zhou Qiang, Chang Emily, et al. Transition-based knowledge graph embedding with relational mapping properties[C] //Proc of the 28th Pacific Asia Conf on Language, Information and Computing. Stroudsburg, PA: ACL, 2014: 328-337

[20]Xiao Han, Huang Minlie, Hao Yu, et al. TransA: An adaptive approach for knowledge graph embedding[J]. arXiv preprint, arXiv:1509.05490, 2015

[21]Xiao Han, Huang Minlie, Hao Yu, et al. TransG: A generative mixture model for knowledge graph embedding[C] //Proc of the 54th Annual Meeting of the ACL, Vol 1. Stroudsburg, PA: ACL, 2016: 2316-2325

[22]Sun Zhiqing, Deng Zhihong, Nie Jianyun, et al. RotatE: Knowledge graph embedding by relational rotation in complex space[J]. arXiv preprint, arXiv:1902.10197, 2019

[23]Zhang Zhanqiu, Cai Jianyu, Zhang Yongdong, et al. Learning hierarchy-aware knowledge graph embeddings for link prediction[C] //Proc of the 34th AAAI Conf on Artificial Intelligence. Palo Alto, CA: AAAI Press, 2020: 3065-3072

[24]Cao Zongsheng, Xu Qiangqian, Yang Zhiyong, et al. Dual quaternion knowledge graph embeddings[C] //Proc of the 35th AAAI Conf on Artificial Intelligence. Palo Alto, CA: AAAI Press, 2021: 6894-6902

[25]Garcia-Duran A, Bordes A, Usunier N. Composing relationships with translations[C] //Proc of the 2015 Conf on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2015: 286-290

[26]Wang Zhigang, Li Juanzi, Liu Zhiyuan, et al. Text-enhanced representation learning for knowledge graph[C] //Proc of the 25th Int Joint Conf on Artificial Intelligent. Palo Alto, CA: AAAI, 2016: 1293-1299

[27]Yao Siyu, Zhao Tianzhe, Wang Ruijie, et al. Rule-guided joint embedding learning of knowledge graphs[J]. Journal of Computer Research and Development, 2020, 57(12): 2514-2522 (in Chinese)(姚思雨, 赵天哲, 王瑞杰, 等. 规则引导的知识图谱联合嵌入方法[J]. 计算机研究与发展, 2020, 57(12): 2514-2522)

[28]Zhang Zhongwei, Cao Lei, Chen Xiliang, et al. Representation learning of knowledge graphs with entity attributes[J]. IEEE Access, 2020, 8: 7435-7441

[29]Xie Ruobing, Liu Zhiyuan, Sun Maosong. Representation learning of knowledge graphs with hierarchical types[C] //Proc of the 25th Int Joint Conf on Artificial Intelligence. Palo Alto, CA: AAAI, 2016: 2965-2971

[30]Xie Ruobing, Liu Zhiyuan, Luan Huanbo, et al. Image-embodied knowledge representation learning[C] //Proc of the 26th Int Joint Conf on Artificial Intelligence. Palo Alto, CA: AAAI, 2017: 3140-3146

[31]Wang Quan, Huang Pingping, Wang Haifeng, et al. Coke: Contextualized knowledge graph embedding[J]. arXiv preprint, arXiv:1911.02168, 2019

[32]Wang Hongwei, Ren Hongyu, Leskovec J. Relational message passing for knowledge graph completion[C] //Proc of the 27th ACM SIGKDD Conf on Knowledge Discovery & Data Mining. New York: ACM, 2021: 1697-1707

[33]Lao N, Mitchell T, Cohen W. Random walk inference and learning in a large scale knowledge base[C] //Proc of the 2011 Conf on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2011: 529-539

[34]Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need[C] //Proc of the 31st Int Conf on Neural Information Processing Systems. Cambridge, MA: MIT Press, 2017: 5998-6008

[35]An Bo, Chen Bo, Han Xianpei, et al. Accurate text-enhanced knowledge graph representation learning[C] //Proc of the 2018 Conf of the North American Chapter of the ACL: Human Language Technologies, Vol 1. Stroudsburg, PA: ACL, 2018: 745-755

[36]Toutanova K, Chen Danqi. Observed versus latent features for knowledge base and text inference[C] //Proc of the 3rd Workshop on Continuous Vector Space Models and Their Compositionality. Stroudsburg, PA: ACL, 2015: 57-66

[37]Dettmers T, Minervini P, Stenetorp P, et al. Convolutional 2D knowledge graph embeddings[C] //Proc of the 32nd AAAI Conf on Artificial Intelligence. Palo Alto, CA: AAAI Press, 2018: 1811-1818

[38]Miller G A. WordNet: A lexical database for English[J]. Communications of the ACM, 1995, 38(11): 39-41

[39]Yang Bishan, Yih W, He Xiaodong, et al. Embedding entities and relations for learning and inference in knowledge bases[J]. arXiv preprint, arXiv:1412.6575, 2014

[40]Trouillon T, Welbl J, Riedel S, et al. Complex embeddings for simple link prediction[C] //Proc of the 33rd Int Conf on Machine Learning. New York: ACM, 2016: 2071-2080

[41]Das R, Dhuliawala S, Zaheer M, et al. Go for a walk and arrive at the answer: Reasoning over paths in knowledge bases using reinforcement learning[J]. arXiv preprint, arXiv:1711.05851, 2017