移动终端设备的普及为互联网用户提供了便捷的互动渠道,大规模用户群体可以针对新闻事件、热门话题、电商产品等对象随时随地发表自己的观点,所产生的海量评论文本中往往蕴藏着丰富的用户情感信息.分析这些评论文本的情感倾向,能够给商家的营销策略调整、政府部门的相关政策制定等领域提供舆情参考.另一方面,消费者也可以根据他人发表的评论观点做出更合理的购买决策.因此,面向评论文本的情感分类方法受到了学界和业界的广泛关注.

早期的情感分类方法包括基于词典的方法和基于传统机器学习的方法.基于词典的方法利用情感词典中的情感词汇作为判断评论情感极性的主要依据,因此需要构建高质量的情感词典[1].此类方法无法处理词典外的词汇且规则无法穷尽所有语境情况,从而极大限制了方法的泛化能力.基于机器学习的情感分类方法最早在Pang等人[2]的研究工作中提出,此类方法更多地依赖人工设计的复杂的特征工程,如n-gram特征[3]、TF-IDF特征等.与基于词典的方法类似,特征工程同样依赖专家知识且人工设计的特征推广能力有限.随着深度学习技术的快速发展,越来越多的研究者开始尝试使用深度学习技术解决文本情感分类问题[4-5].与传统机器学习方法相比,深度神经网络不再需要复杂的特征工程就能够有效捕捉到文本的高层次语义信息,且模型的表达能力指数优于浅层模型.多数基于深度学习的情感分类研究中使用Word2Vec[6],Glove(global vectors for word representation)[7]等无监督算法产生的词向量来编码文本,但这些算法本质上利用词共现关系来学习词向量而忽略了上下文语境信息.Google在2018年提出的BERT(bidirectional encoder representations from transformers)预训练语言模型采用了隐蔽语言模型、双向语言模型和排序语言模型等理论,在更深层次上对自然语言中的语法语义信息进行建模,使得文本语义表示有了质的提升[8].尽管有监督深度学习方法在情感分类任务中有不俗的表现,但模型性能依赖大规模高质量人工标注数据.然而人工标注情感数据耗时费力且标注一致性较低,难以获取大规模高质量标注数据来训练深度模型.针对这种小样本情感分类问题,有研究人员开始考虑利用互联网用户产生的标签信息作为监督信号来训练深度语言模型[9].但用户产生的标注信息并不是严格意义上的强标注信息,其中存在不可忽视的噪声标签,即标签与文本情感语义不一致,如5星商品评论中存在负面描述文字.因此,这种由用户产生的标注信息是一种弱标注信息.直接使用弱标注数据训练深度模型,噪声数据带来的误差会在反向传播过程中逐轮累积从而影响模型性能[9].针对上述问题,本文提出了一种面向小样本情感分类任务的弱监督对比学习(weakly-supervised contrastive learning, WCL)方法.该方法可以有效降低弱标注数据中噪声数据带来的负面影响并充分利用极小规模标注数据(规模小到基本可忽略标注成本)中的正例或负例对比模式.该方法采用知识迁移策略,包括2个关键核心步骤:1)使用海量的弱标注数据对模型进行预训练.预训练采用三元训练策略来削弱噪声影响,同时学习较好的情感特征表达.2)在少量有标注的样本上对预训练模型进行微调.受无监督对比学习的启发[10],我们设计了一种微调模型的有监督对比学习策略.其目的在于充分利用不同极性句子间的差异性和相同极性句子间的相似性,拉近相同标签句子间的距离同时增大不同标签句子间的距离.在编码器的选择方面,考虑到BERT模型在多数自然语言处理任务上的优秀表现,我们选用BERT模型作为WCL框架的文本编码器.

本文的主要贡献包括3个方面:

1) 提出了一种面向小样本情感分类任务的弱监督对比学习(WCL)框架,在模型训练的不同阶段分别提出了抗噪声弱监督预训练策略和用于微调模型的有监督对比学习目标函数.其中弱监督预训练策略可有效降低弱标注数据中噪声数据产生的负面影响,并最大化地挖掘弱标注数据中潜在的情感信息;对比学习训练目标能够充分有效地利用同类数据间的相似性和非同类数据间的差异性,减少模型在有监督微调训练时所使用的人工标注数据数量,并提升模型的分类性能.

2) 该框架具备通用性,可兼容不同结构的深度语言模型.本文选用BERT模型作为基准编码器,很好地解决了词向量存在的一词多义、表示能力欠缺的问题.

3) 在公开亚马逊评论数据集上的实验结果表明,本文所提出的方法在极小样本的情感分类任务中效果显著.在仅使用32个人工标注样本的情况下仍然取得比基线方法更好的分类效果.

1 相关工作

1.1 情感分类

早期情感分类方法主要分为基于词典的方法和基于特征工程的机器学习方法.基于词典方法的关键在于如何构建情感词典[11]和制定情感计算规则[12-13].但此类方法需要构建全面高质量的情感词典,固定的情感极性和计算规则无法跟随上下文语义变化,限制了方法的性能.基于特征工程的机器学习方法抽取文本的词频、n-gram等特征来表征文本并在有标注数据集上训练浅层分类模型.Pang等人[2,14]和Zhang等人[15]分别利用unigrams特征和支持向量机(support vector machine, SVM)、n-gram特征和支持向量机及朴素贝叶斯(NB)进行情感分类.尽管文献[2,14,15]所述的方法在情感分类任务中取得了一定的成果,但是算法性能过分依赖严谨精细的特征设计且特征的泛化能力有限.近年来,深度学习在图像识别[16-19]等领域取得了突破性的进展,深度模型的表达能力显著优于浅层模型,越来越多的研究者更加青睐使用深度学习方法解决情感分类问题[20-23].基于深度学习的文本情感分类方法关键在于文本情感语义的表达学习.文本表达学习经历了长期的研究发展过程.早期文本表示主要使用词袋(bag of words, BOW)模型[24],但此种表征方法存在丢失词汇顺序、忽视词义信息、编码出的特征稀疏、易产生维度灾难等问题.针对该问题,研究人员开始研究分布式的特征表达方法,采用致密的低维向量对单词进行表示[25].Bengio等人[26]提出了神经网络语言模型(neural network language model, NNLM),利用神经网络训练词语的分布式向量表示.Mikolov等人[6]于2013年提出了Word2Vec算法,该算法使用的CBOW(continuous bag-of-words)模型和Skip-gram模型能够学习到高质量的词语分布式向量表示,这是神经概率语言模型研究中的经典工作.Pennington等人[7]提出基于共现矩阵分解生成词向量的Glove模型,该模型通过构建全局词共现矩阵训练词向量.以预训练词向量技术为基础,多数研究工作采用无监督预训练得到的词向量来表征评论文本,并在有标注数据上训练深度模型来获取面向具体场景的高层次情感语义表达[5,27-29].然而,采用上述无监督预训练方法学习得到的词向量存在3个重要缺陷:1)词与向量之间的一一映射关系无法处理一词多义问题;2)静态的表征方式无法适应上下文动态变化的语言环境;3)以词共现为本质的单一语义建模方式无法适应下游复杂的文本任务.基于Transformer的预训练语言模型有效解决了这3个缺陷.BERT预训练语言模型[8]的核心特色在于:1)采用的特征编码器为Transformer的编码器部分,具有并行计算能力且能够捕获长距离的文本语义信息;2)掩码语言模型(masked language model, MLM)随机遮挡或替换句子中15%的字或词,让模型预测被掩盖的单词,进而生成更深层次的双向语言表征;3)预训练模型从不同层次学习复杂的语言结构,底层特征更关注字、词、句法等基础语言信息,而高层次抽象特征则可捕捉到动态变化的上下文语义模式[30].基于这3个优点,本文的WCL框架采用BERT作为文本编码器.

尽管深度学习方法[27-29]摆脱了情感计算规则制定和特征工程等诸多束缚,但是其对于大规模有标注训练数据的依赖性更为强烈.人工标注评论数据不仅耗时费力,而且标注一致性难以保证.因此,有标注训练数据的质量和获取成本问题已成为制约深度学习方法继续深入发展的因素之一.

1.2 弱监督学习

对于文本情感分类任务的研究工作多采用监督学习方法,利用“大尺寸”的自然语言模型来学习海量标注数据中的情感语义.但此类方法严重依赖有标注数据的规模和质量,需要耗费高昂的人工标注成本.与人工标注数据相比,互联网上带有用户标记的评论数据为小样本文本情感分类任务提供了海量成本极低的弱标注数据.但用户产生的标签是一种弱标签,虽然标签与评论的情感倾向存在关联,但也存在标签与文本实际情感语义不一致的情况,如低评分中的正面评论语句.因此,用户产生的弱标注数据并不能直接用于有监督的情感分类任务中.文献[31]对弱监督学习方法进行了较为系统的阐述,现有弱监督学习方法可分为3类:不完全监督、不确切监督和不准确监督.其中,不准确监督方法中给定的标签并不总是真实值.本文采用的弱标签属于不准确监督信息,即数据标签存在噪声,如电商网站评论中的评分、推特和微博中的表情符号等.Qu等人[32]提出将评分作为评论数据的标注信息,根据这种规则生成了弱标注数据,并以此来训练概率模型进而解决情感分类问题.Deriu等人[9]则以表情符号作为弱标注信息,直接将弱标注数据作为监督数据,并使用卷积神经网络进行推特情感分类任务.

以上这些工作并没有考虑弱标注数据中噪声样本带来的负面影响.Guan等人[33]提出了一种基于弱监督的深度学习框架,使用三元组损失函数降低弱标注数据中噪声数据的影响.受该研究启发,本文在模型预训练阶段采用抗噪声弱监督训练方法来充分学习大量弱标注数据的情感语义.

1.3 小样本学习

现有优秀的情感分类方法大都需要在大量人工标注的数据集上进行有监督学习,但是受限于有标注数据的标注成本和标注质量问题,实际上可获得的有标注训练数据的规模有限.因此,如何从规模有限的标注数据中充分学习得到具有良好泛化能力的语义表达成为了情感分类任务需要研究的重要问题之一.人类通过一张猫的图片就能泛化认知出猫这一类动物,受此启发[34],小样本学习(few-shot learning)[35-36]的概念被提出.文献[37]将小样本学习方法分为基于数据增广、基于迁移学习和基于模型微调的3种类型.Howard等人[38]提出了一个迁移式的通用微调语言模型(universal language model fine-tuning, ULMFit),通过在不同层设置不同的学习率来微调该模型,整个过程分3个步骤进行:1)在通用的大型语料库上预训练语言模型;2)在目标数据集上微调语言模型;3)使用目标数据的训练集进行分类器微调.Nakamura等人[39]提出了3种新的微调策略来提高小样本学习的准确率:1)使用低学习率;2)使用自适应的梯度优化器;3)在跨领域任务中当目标数据和源数据之间差异较大时对整个网络参数进行更新.本文所提出的弱监督对比学习方法融合了文献[37-39]所述的3种方法的思想:1)从互联网上收集海量弱标注数据是一种天然的数据增广;2)“弱监督预训练+有监督微调”基于迁移学习思想,目的是充分吸收大量弱标注数据中的情感信息;3)采用在大量语料上预训练得到的BERT模型作为文本编码器并在此基础上执行后续迁移式训练策略,此处借鉴了基于模型微调的策略.

除了吸收海量弱标注数据的情感信息,本文还关注有监督微调阶段如何对规模有限的有标注数据进行充分学习.Gunel等人[40]提出使用有监督对比学习损失和交叉熵损失的加权和作为最终损失,对预训练语言模型RoBERTa-Large进行微调训练.该方法在小样本学习上取得了一定的效果,但其设计的对比目标函数在分母上会采样到与锚点样本情感标签一致的样本集合,因此并未最大化地发挥模型捕获非同类样本间对比模式的能力.对小样本情感分类任务而言,应考虑如何在有限的有标注数据集上学习更大的类间距离.受对比学习方法[10]的启发,本文在有监督微调阶段提出了一个用于小样本情感分类任务的对比损失函数,该损失能够充分捕捉到数据集中同类和非同类样本之间的对比模式.

2 WCL方法

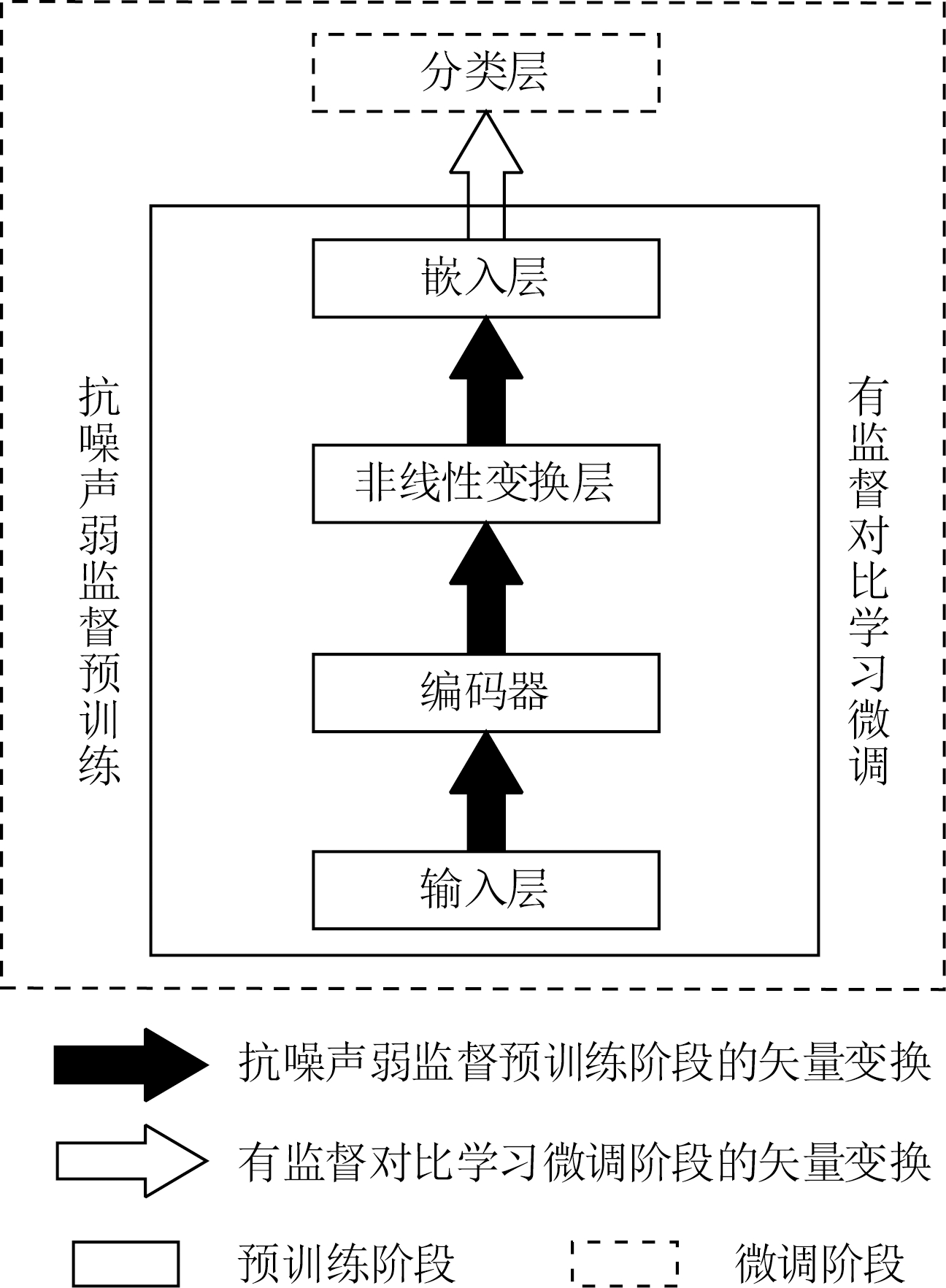

Fig. 1 WCL architecture

图1 WCL框架

本节详细阐述所提出的弱监督对比学习(WCL)方法,其总体框架如图1所示.该框架包括2个部分:1)抗噪声弱监督预训练部分;2)有监督对比学习微调部分.弱监督预训练阶段首先利用编码器对输入文本编码,再经过非线性变换,得到文本的高层次特征表达.在嵌入层引入了抗噪声弱监督预训练策略来削弱噪声数据的影响,同时学习弱标注数据中潜在的情感信息.有监督对比学习微调在预训练得到的模型基础之上进行,在嵌入层后添加一个分类层并设计了一种监督学习方法来微调整个模型的参数.为了充分利用同类或非同类样本之间的对比模式,我们在模型微调阶段设计了一种有监督对比学习目标方法,通过学习同类数据间的相似性和非同类数据间的差异性,进一步减小同类样本间的距离,同时增大非同类样本间的距离.

本节,我们将介绍WCL框架所采用的语言模型结构以及模型训练策略.

2.1 基于BERT编码结构的深度语言模型

2.1.1 整体模型结构

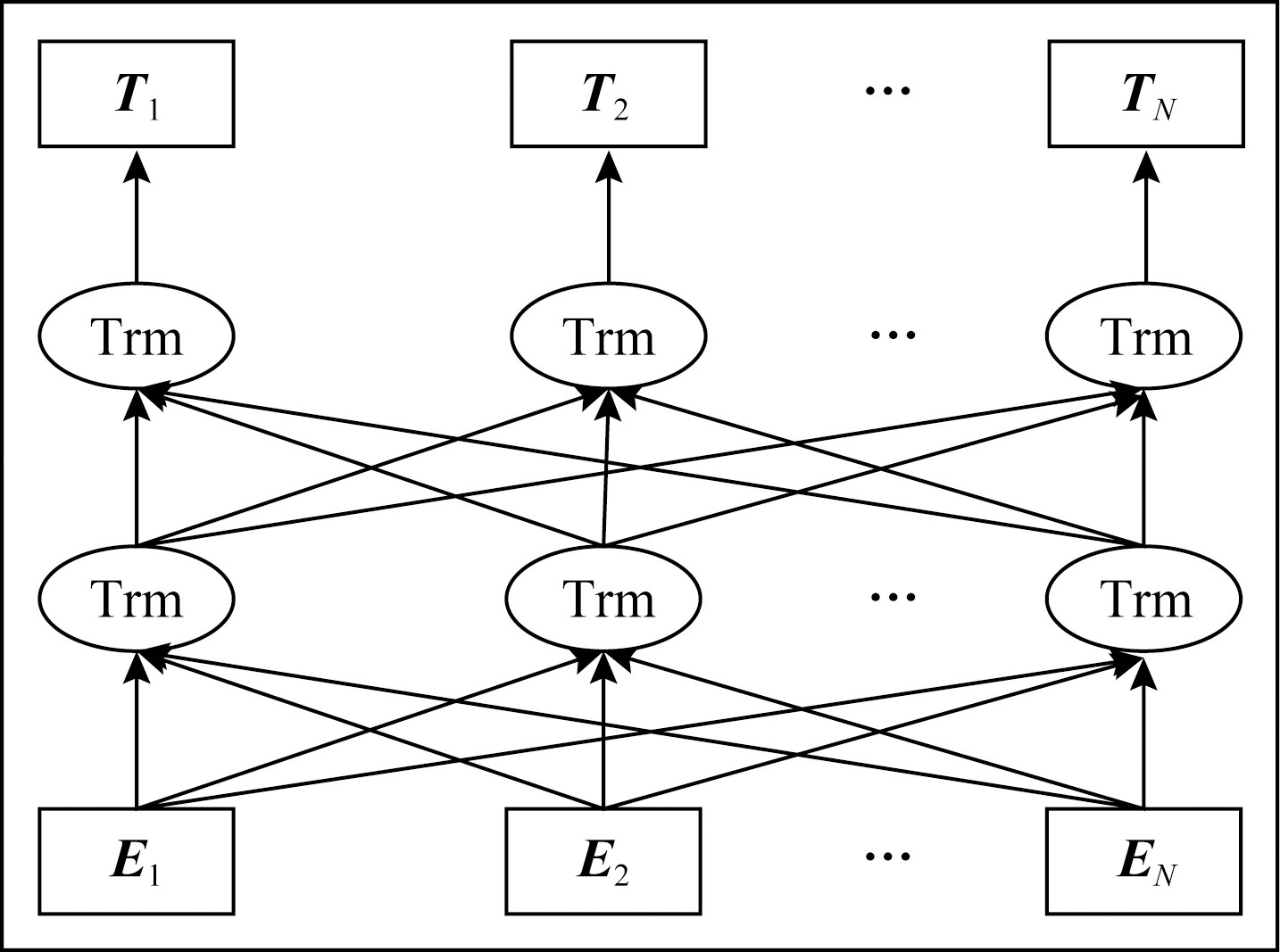

BERT是一种使用多头自注意力机制构建的模型,该模型能够深入挖掘文本数据的语法、句法特征,并充分学习文本中的字级、词级和句级不同层次的特征表达.考虑到有标注数据规模并对比不同版本BERT预训练模型的复杂度,我们采用BERTBASE作为情感分类任务的基准编码器.基于BERTBASE的情感分类语言模型如图2所示,后文简称该模型为WCL-BERT.

Fig. 2 Sentiment classification model based on BERT

图2 基于BERT的情感分类模型

如图2所示,si= [CLS],ω1,ω2,…,ωt,[SEP]

[CLS],ω1,ω2,…,ωt,[SEP] 表示模型BERTBASE的输入,ω1,ω2,…,ωt表示si中的词语,t表示输入序列si中词语的个数,i表示数据集中的第i条样本.本文在以BERT作为特征编码器的下游情感分类任务中,将符号[CLS]和[SEP]分别放于ω1,ω2,…,ωt的首部和尾部,并在编码完成后提取符号[CLS]所对应的特征向量作为输入序列si的语义表示向量.

表示模型BERTBASE的输入,ω1,ω2,…,ωt表示si中的词语,t表示输入序列si中词语的个数,i表示数据集中的第i条样本.本文在以BERT作为特征编码器的下游情感分类任务中,将符号[CLS]和[SEP]分别放于ω1,ω2,…,ωt的首部和尾部,并在编码完成后提取符号[CLS]所对应的特征向量作为输入序列si的语义表示向量.

编码器BERTBASE的计算结构使用fBERT(·)表示,编码输入序列si得到语义特征hi∈![]() d:

d:

hi=fBERT(si),

(1)

此处的hi即为上文所述的编码完成后符号[CLS]所对应的特征向量.

非线性变换层(nonlinear transformation layer)

的输入为hi,经过非线性变换后得到的xi∈![]() m作为输入序列si最终的特征:

m作为输入序列si最终的特征:

xi=W2σ(W1hi),

(2)

其中,σ是tanh函数,W1∈![]() d×d和W2∈

d×d和W2∈![]() m×d为权重矩阵.

m×d为权重矩阵.

嵌入层(embedding layer)没有涉及具体的计算过程,只用来存放上一层得到的输入序列si的最终特征向量xi,本文设置向量xi的维度m=300.

式(1)和式(2)为预训练过程的计算结构.微调步骤中,在预训练模型上添加分类层(classification layer)进行有监督对比训练.分类层的计算式(3)为

![]()

(3)

其中,xi∈![]() m是输入序列si的特征向量,W3∈

m是输入序列si的特征向量,W3∈![]() m是参数矩阵,b是偏置项,

m是参数矩阵,b是偏置项,![]() 表示模型对当前输入文本si的预测值.

表示模型对当前输入文本si的预测值.

2.1.2 BERT编码器简介

2.1.1节采用BERT作为模型的文本编码器,BERT于2018年被提出,该自然语言模型在分类、问答、翻译等11项不同的自然语言处理任务中均达到最优性能[8].本文所采用的BERTBASE模型的结构参数如表1所示:

Table 1 Parameter Settings for BERTBASE Model

表1 BERTBASE模型的结构参数设置

层数隐藏尺寸每一层头数总参数1276812110×106

BERT模型结构如图3所示,其中Ei表示嵌入向量,Ti表示最终编码得到的隐藏层向量,Trm为Transformer的缩写.如图3所示,BERT主要由Transformer[41]的编码器部分构成.Transformer的编码器(encoder)部分主要包括多头自注意力层(multi-head self-attention)和前馈网络层(feed forward)两个部分.其中多头自注意力机制能够有效解决长距离信息丢失的问题,并能充分获取上下文的语义信息.由表1可知,BERTBASE内部是由Transformer的编码器部分堆叠了12层构成,因此其在语义特征提取、长距离信息捕获、句法特征提取等方面都具有一定的优势.

Fig. 3 BERT model architecture

图3 BERT模型结构

BERT结构支持单文本输入和文本对输入.单文本输入需要将符号[CLS]和[SEP]分别放在文本序列的首部和尾部;文本对输入则需要在2个文本序列之间添加符号[SEP]作为分隔符.本文以单文本序列 [CLS],ω1,ω2,…,ωt,[SEP]

[CLS],ω1,ω2,…,ωt,[SEP] 作为BERTBASE的输入.BERT作为一个成熟的语言模型,其内部的具体计算过程见文献[8],本文中不再赘述.

作为BERTBASE的输入.BERT作为一个成熟的语言模型,其内部的具体计算过程见文献[8],本文中不再赘述.

2.2 弱监督对比学习方法

2.2.1 抗噪声弱监督预训练方法

互联网中海量的弱标注数据蕴含了丰富的情感语义信息,但使用弱标注数据需要削弱噪声样本(即标签与文本情感倾向不一致的样本)带来的负面影响.预训练的目标在于充分学习海量弱标注数据的总体情感分布,同时削弱噪声数据的负面影响.为此,我们引入了抗噪声弱监督预训练策略,具体分为2步:1)获取样本弱标签.我们以面向商品评论的情感分类场景为例,根据用户评分信息将评论划分为2个集合POS和NEG,分别代表情感倾向为积极(positive)和消极(negative)的集合.划分规则:给1星和2星评论中的样本分配消极标签l(s)=neg,给4星和5星评论中的样本分配积极标签l(s)=pos,其中l(s)表示样本的弱标注标签.其他场景可根据具体情况设定规则获取弱标签,如社区评论中点赞与点踩等.2)设计抗噪声训练策略来训练网络.训练目标需要保证相同情感倾向的样本靠近而不同情感倾向的样本远离,同时还需要约束噪声不向错误类别靠近.Guan等人[33]对二元训练准则和三元训练准则进行了对比分析,发现三元训练准则能够在一定程度上减弱噪声数据的负面影响.受该工作启发,本文在预训练过程中采用基于三元损失的训练策略.从弱标注数据划分好的集合POS和NEG中一共随机采样3个样本构成三元组,再使用如式(4)所示的训练目标函数L1约束三元组在嵌入空间中的分布:

![]()

![]()

(4)

其中, s1,s2,s3

s1,s2,s3 表示随机采样得到的三元组.其中,样本标签l(s1)=l(s2)≠l(s3),即样本s1和样本s2来自同一集合,样本s3来自另一个集合;λ是间隔超参数;

表示随机采样得到的三元组.其中,样本标签l(s1)=l(s2)≠l(s3),即样本s1和样本s2来自同一集合,样本s3来自另一个集合;λ是间隔超参数;![]() 表示嵌入空间中样本特征xi和xj之间的欧氏距离.该训练函数的目标是让具有相同弱标签的样本对s1与s2之间的距离至少比具有不同弱标签的样本对s1与s3之间的距离小λ.

表示嵌入空间中样本特征xi和xj之间的欧氏距离.该训练函数的目标是让具有相同弱标签的样本对s1与s2之间的距离至少比具有不同弱标签的样本对s1与s3之间的距离小λ.

根据三元组采样规则,以s1,s2采样自集合POS而s3采样自集合NEG为例(反之亦然),我们罗列了所有6种采样情况如表2所示:

Table 2 Sampled Cases

表2 采样示例

采样文本示例1示例2示例3示例4示例5示例6s1P+P+P+P+P-P-s2P+P+P-P-P-P-s3N+N-N+N-N+N-

注:符号“P”表明采样文本来自集合POS,符号“N”表明采样文本来自集合NEG.符号“+”表示文本的真实情感极性为正面,而符号“-”表示文本的真实情感极性为负面.

表2中,s1,s2,s3代表采样的3条评论文本.例如,符号“P+”表示文本弱标签为正面而真实情感极性也为正面,即弱标签可以真实地反映出该文本的实际情感极性是正面.符号“P-”表明文本弱标签为正面而真实情感极性为负面,此时弱标签已不能如实地反映对应文本的实际情感极性,即噪声数据.以下具体说明表2中的6种采样在训练过程中的情形.

1) 示例1中,s1,s2,s3的真实情感极性均为正面.s1与s2间的距离和s1与s3间的距离较为接近.根据目标函数,s1,s2,s3可能会维持其在嵌入空间中的位置不变,也有可能会出现此种情形:s1与s2靠近而s1与s3远离.受间隔参数λ的约束,其移动程度相对较小,在文本对间的距离大于λ时停止移动,从而约束了噪声样本s3不向错误类别靠近.

2) 示例2中,s1与s2的真实情感极性为正面,而s3的真实情感极性为负面.s1与s2间的距离比s1与s3间的距离小.根据目标函数,s1,s2,s3可能会维持其在嵌入空间中的位置不移动,也有可能会出现此种情形:s1与s2靠近而s1与s3远离.受间隔参数λ的约束,这2种情形中样本的移动趋势都对训练有利.

3) 示例3中,s1与s3的真实情感极性为正面,而s2的真实情感极性为负面.s1与s2间的距离大于s1与s3间的距离.根据目标函数,更为普遍的情形是s1与s2靠近而s1与s3远离.受间隔参数λ的约束,其移动程度相对较小,在文本对间的距离大于λ时停止移动,从而约束了噪声样本s2和s3不向错误类别靠近.

4) 示例4中,s2与s3的真实情感极性为负面,而s1的真实情感极性为正面.s1与s2间的距离和s1与s3间的距离较为接近.根据目标函数,s1,s2,s3可能会维持其在嵌入空间中的位置不移动,也有可能会出现此种情形:s1与s2靠近而s1与s3远离. 受间隔参数λ的约束,其移动程度相对较小,当文本对间的距离大于λ时停止移动,从而约束了噪声样本s2不向错误类别靠近.

5) 示例5中,s1与s2的真实情感极性为负面,而s3的真实情感极性为正面.该示例中采样得到的3条样本均是噪声样本,其在嵌入空间中的移动趋势和示例2中的情形一致.受间隔参数λ的约束,该示例中噪声样本的移动趋势都对训练过程有利.

6) 示例6中,s1,s2,s3的真实情感极性均为负面.该示例中采样得到的样本s1与s2是噪声样本,其在嵌入空间中的移动趋势和示例1中的情形一致.受间隔参数λ的约束,文本的移动程度相对较小,在文本对间的距离大于λ时停止移动,从而约束了噪声样本s1与s2不向错误类别靠近.

综合这6种示例,除了示例2中不存在噪声数据外,其他示例中都存在噪声数据.存在噪声数据的所有示例中,三元训练准则通过间隔参数λ对采样文本的移动趋势进行有效的约束,能够有效抑制噪声样本产生错误移动情形下的负面影响.上述分析表明在弱监督预训练过程中使用三元训练准则能够大幅度提升模型在噪声标签下的鲁棒性,同时学习到输入文本的高质量特征表达,进而在嵌入空间形成一个良好的情感语义分布,即同类样本靠近而非同类样本远离.

2.2.2 有监督对比微调

在弱监督预训练阶段,我们通过引入抗噪声弱监督预训练策略,极大地减小了噪声数据对预训练模型的负面影响,最终得到了一个能够较为真实地反映海量弱标注数据总体情感分布的模型.在有监督微调阶段,我们在预训练好的模型上使用少量的有标注数据对其进行有监督微调训练.为了充分学习有限规模标注数据中的同类和非同类样本之间的对比模式,我们设计了一种新颖的基于对比损失[10]的多任务目标函数:

L2=αLSCL+(1-α)LCE,

(5)

(6)

![]()

(7)

![]()

(8)

(9)

式(5)为有监督微调阶段的优化目标函数,它由2部分构成:LSCL表示有监督对比学习(supervised contrastive learning, SCL)损失,LCE表示交叉熵(cross entropy, CE)损失,α为超参数用于调节两者的权重.式(6)~(8)为有监督对比学习损失函数.M表示最小批次的大小,Myi表示每一批次中标签为yi的样本数量;li≠j表示指示函数,只有满足条件i≠j时才取值为1,否则取值为0,同理指示函数lyi=yj和lyi≠yk与上述li≠j函数的用法一致.式(7)(8)中的![]() 表示si与sj之间的余弦相似度;τ表示温度系数,是一个超参数,用于调节对困难样本的关注度.式(9)为交叉熵损失函数,其中yi表示输入数据的真实标签,取值为0或

表示si与sj之间的余弦相似度;τ表示温度系数,是一个超参数,用于调节对困难样本的关注度.式(9)为交叉熵损失函数,其中yi表示输入数据的真实标签,取值为0或![]() 表示模型对当前输入文本的预测值.

表示模型对当前输入文本的预测值.

在有监督微调阶段,模型以多任务目标函数L2为训练目标,能够同时学习有限规模标注数据中多样的对比模式和正确的分类能力.我们在LSCL中引入了样本的标签信息,输入样本经过指示函数的“筛选”被归纳到对应的计算结构当中,进而使得该损失能够更好地扩展到小样本的情感分类任务当中.对于有监督对比学习损失LSCL的直观解释是该损失更为关注同类数据间的相似性与非同类数据间的差异性.式(8)通过对非同类数据的多次采样获得了非同类样本群体,能够从不同“视角”学习到更为丰富的对比模式,从而可以从有限规模数据中学习更丰富的情感信息.

3 实 验

3.1 实验数据

本文在亚马逊评论数据集上进行实验.亚马逊数据集包含数码相机(camera)、手机(cellphone)和笔记本电脑(laptop)三种商品的评论语料,由1 136 251条弱标注评论语句和人工标注的11 754条语句构成.实验中有标注数据集被随机划分成训练集(50%)、验证集(20%)和测试集(30%).表3和表4分别显示了亚马逊弱标注数据集和亚马逊人工标注数据集的统计信息. 此外,为了验证WCL方法在中文数据上的泛化能力,我们分别在豆瓣影评数据集和新浪微博评论数据集上进行了相同的验证实验.其中豆瓣影评数据集包含60万条带评分的弱标注语句和1万条强标注语句;新浪微博评论数据集包含36万条带表情符号的弱标注语句和1万条强标注语句.

Table 3 Statistics of the Weakly Labeled Datasets

表3 弱标注数据集的统计信息

类别数目数码相机553128手机239438笔记本电脑343685

Table 4 Statistics of the Labeled Datasets

表4 标注数据集的统计信息

正例负例总计5610614411754

3.2 超参数设置

我们统计了人工标注数据集中的句子长度,其中句子最长长度为121,为了充分获取句子的全部信息,本文规定句子的最大长度为121.实验中设置batch size值为32,间隔参数λ=5.针对温度系数τ和损失加权超参数α的取值我们进行了多次实验,发现当τ=0.5而损失加权超参数α=0.2时模型的性能表现更为稳定.模型采用Adam优化器,学习率设置为10-5.

3.3 同类方法对比实验

为了评估本文所提出方法的效果,我们对比了9种情感分类方法,涵盖本领域最优和经典的方法.评估指标为准确率(accuracy).9种对照方法简介为:

1) Lexicon.基于词典的方法[13].

2) SVM.使用“支持向量机+ trigrams特征”的方法[2],采用Liblinear分类器.

3) NBSVM.将NB分类器与SVM分类器融合进行情感分类的方法[42].

4) SSWE.通过在弱标注信息上训练神经网络得到词向量.对一条语句中所包含词的词向量求最大、最小和均值,从而得到语句的特征向量表达并进行情感分类[43].

5) SentiWV.通过使用评分信息训练词向量生成语句特征表达的过程与SSWE方法相同,之后再使用线性分类器进行情感分类[44].

6) WSD-CNN.建立多通道的CNN网络[45]模型,利用Word2Vec在谷歌新闻语料库上的训练结果[46]初始化词向量查找表.首先使用三元训练准则在弱标注数据集上对该网络进行弱监督预训练,再使用人工标注数据对模型进行微调[45].为了公平起见,本文的所有方法均不加入主题词信息.

7) BERT.直接在原BERTBASE模型上使用人工标注数据进行训练.

8) WCL-BERT-rand.随机初始化模型参数并在人工标注数据集上使用对比学习策略对BERTBASE模型进行微调训练.该方法用于验证仅使用有监督对比学习策略训练模型的效果,所使用的网络模型如图2所示.

9) WCL-BERT-weak.将弱标注标签视为强标签进行有监督学习.该方法用于验证WCL框架中抗噪声训练策略的影响,所使用的网络模型如图2所示.

10) WCL-BERT.该方法为本文提出的方法.

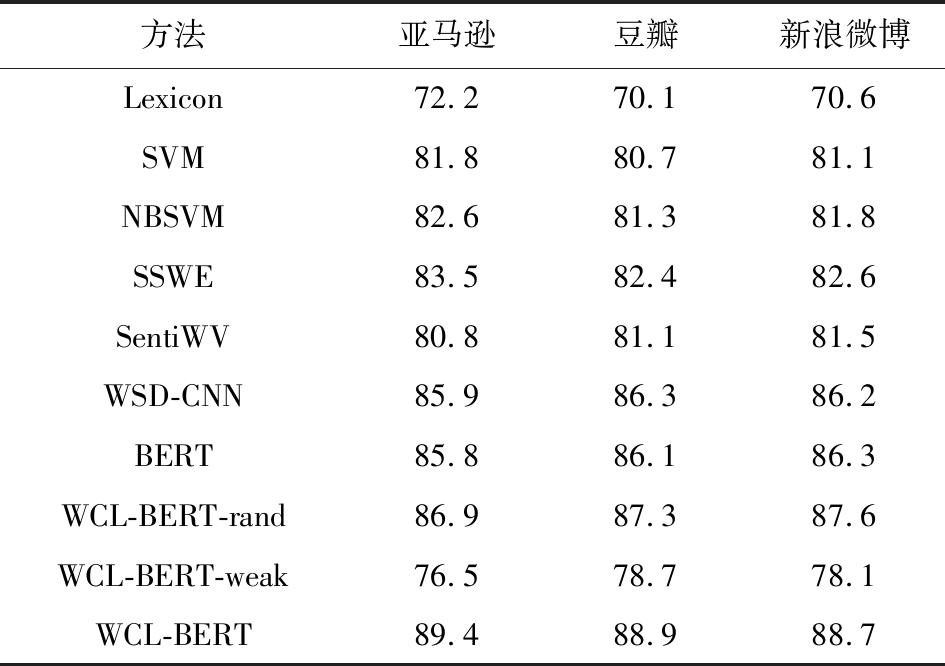

表5展示了不同方法在3个不同数据集上的实验结果.表5中各方法在不同数据上呈现出相似的结果,因此以亚马逊数据集上的数据为例进行分析.首先,Lexicon方法的效果最差,与其他所有方法相比,Lexicon方法无法涵盖电商场景下的所有情感词,且固定的情感极性无法跟随文本描述的改变而变化.2种基于特征工程的机器学习方法SVM和NBSVM显著优于Lexicon方法,但受限于特征的泛化能力,与SSWE方法相比其效果较差.SentiWV与SSWE方法效果较差的原因在于:虽然在弱标注数据集上训练得到词向量,但以捕捉词共现为本质的无监督词向量方法无法获取更丰富的语义信息.与SentiWV和SSWE这2种深度方法对比,WSD-CNN方法的优越性得益于预训练过程中弱标注数据为模型提供的大量先验知识.但该方法在面向具体任务的有监督微调过程中并未充分考虑同类和非同类样本之间的区别,因此性能仍逊色于WCL-BERT.BERT方法作为验证WCL-BERT的基准方法,展现出预训练模型的优越性,取得了与WSD-CNN相当的效果,但未采用WCL中的训练策略因此其无法从弱标注信息和对比学习中受益.在BERT方法基础上,WCL-BERT-rand的实验结果表明对比学习策略能够充分捕获同类或非同类样本之间存在的对比模式,进而提升模型的分类能力,但该方法并未学习海量弱标注信息的情感模式.WCL-BERT-weak方法效果较差的原因在于弱标注数据中存在噪声,直接将其作为强标注数据使用,噪声会对模型的训练过程产生严重干扰.同时,WCL-BERT-weak方法从反面证明了抗噪声预训练方法的必要性.我们所提出的方法WCL-BERT在抗噪声的情况下充分吸收了弱标注数据中的情感语义信息,同时在有监督微调阶段进一步学习了同类和非同类样本之间的对比模式,在3个不同数据集上都取得了最优分类性能,证明了我们所提出方法的优越性和良好的泛化能力.

Table 5 Accuracy of Different Methods

表5 不同方法的准确率 %

方法亚马逊豆瓣新浪微博Lexicon72.270.170.6SVM81.880.781.1NBSVM82.681.381.8SSWE83.582.482.6SentiWV80.881.181.5WSD-CNN85.986.386.2BERT85.886.186.3WCL-BERT-rand86.987.387.6WCL-BERT-weak76.578.778.1WCL-BERT89.488.988.7

3.4 小样本对比实验

3.3节所述的实验使用了全量有标注训练数据.为了评估本文所提出的方法在极小样本场景下的效果,我们验证了方法在不同规模亚马逊有标注数据上的训练效果.从有标注训练集中随机选取n%(n=0.5,1,1.5,2,…,5)的数据作为训练集来训练模型,对比实验结果如图4所示.

Fig. 4 The result of few-shot experiment

图4 小样本实验结果

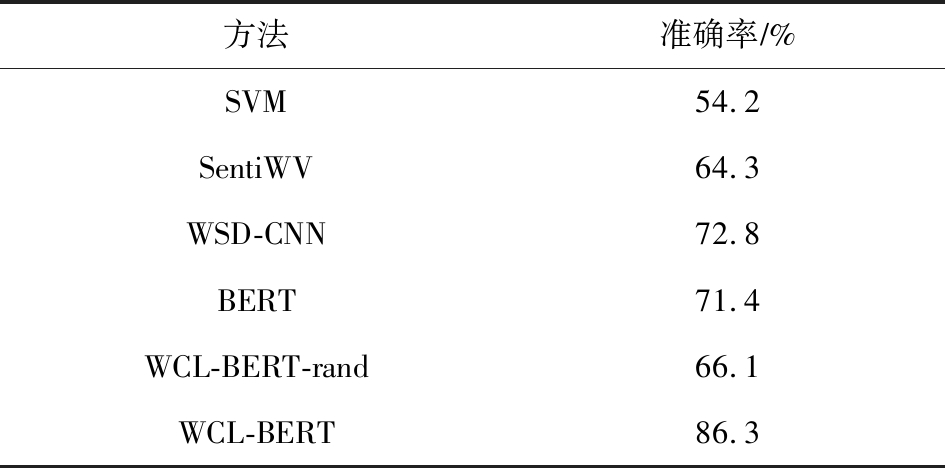

当从原始训练集中随机采样0.5%的数据(即32个样本)对模型进行微调训练时,WCL-BERT方法已达到了86.3%的分类准确率,超出性能第2的WSD-CNN方法13个百分点,同时超过了WSD-CNN使用全部有标注训练数据时的分类性能.该结果有力证明了我们所提出的方法在极小标注数据上的优越性.原因在于有监督微调阶段采用对比学习策略多次采样对比非同类样本与同类样本,充分学习了有限样本中的对比模式.值得注意的是,当采样规模小于原始训练集规模的1.5%时WCL-BERT-rand方法的性能显著下降.这一现象说明:仅依靠有监督对比学习无法应对极小样本场景下的分类问题,需要结合弱监督学习来充分吸收大规模弱标注数据中的情感语义信息.

我们在表6中报告了采样数据占比为0.5%(即32个训练样本)时各情感分类方法的分类准确率.我们的方法在几乎可忽略标注成本的情况下(即仅标注32个样本)取得了显著优于同类方法的分类性能,这充分证明我们所提出方法在极小样本情感分类任务上的有效性和优越性.

Table 6 Few-shot Learning Results on 32 LabeledTraining Examples

表6 使用32个标签样本进行训练时的小样本学习结果

方法准确率∕%SVM54.2SentiWV64.3WSD-CNN72.8BERT71.4WCL-BERT-rand66.1WCL-BERT86.3

3.5 嵌入空间的可视化分析

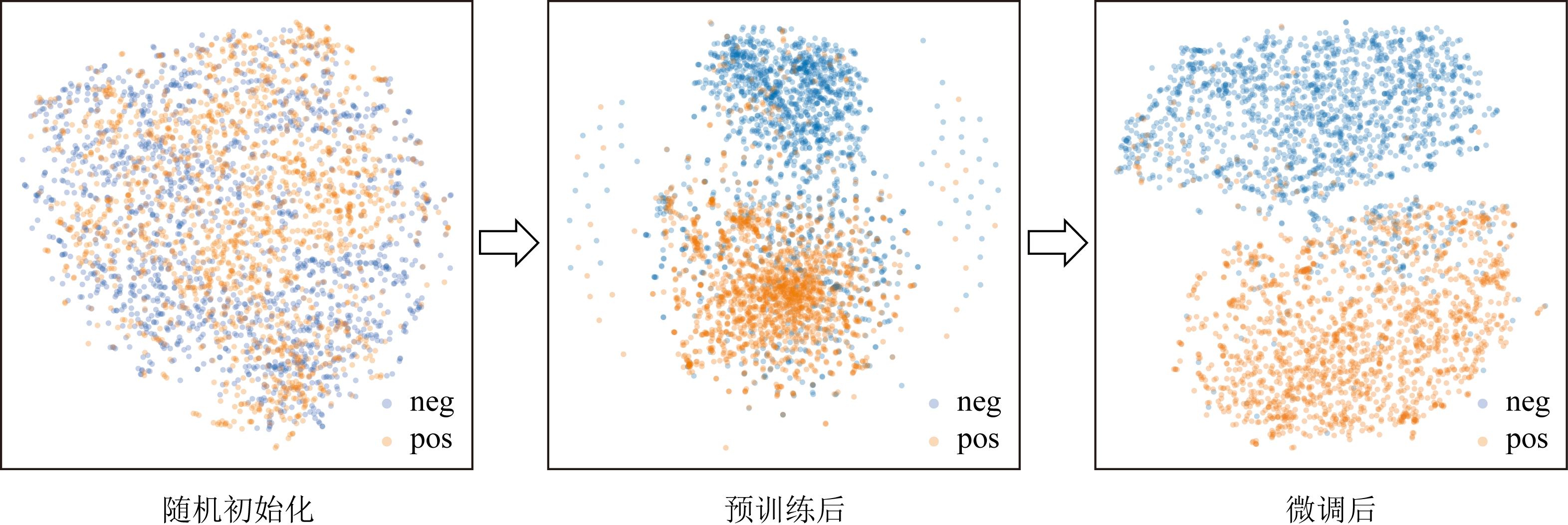

为了直观地展示WCL框架中弱监督预训练和有监督对比微调过程的学习效果,我们使用t-SNE方法[47]对亚马逊测试集数据在嵌入层中的高维特征向量进行了降维可视化处理.如图5所示,我们按照模型训练的步骤报告了测试集数据在嵌入空间中的分布情况,其中蓝色的点表示情感极性标签为“neg”的样本,橙色的点表示情感极性标签为“pos”的样本.

Fig. 5 Visualization of test set data

图5 测试集数据可视化

图5中的“随机初始化”图代表模型参数随机初始化,测试集数据在嵌入空间中的分布较为散乱,模型不具备区分样本情感极性的能力.图5中的“预训练后”图代表使用海量弱标注数据对模型进行了抗噪声弱监督预训练,与“随机初始化”图相比测试集数据在嵌入空间中被分成了极性相反的2簇,说明模型已初步具备了区分句子情感极性的能力,这样的可视化效果与我们所提出的三元训练目标相吻合.需要指出的是,尽管在预训练过程中我们采用三元训练准则约束句子在嵌入空间中的移动趋势,但是部分噪声数据的错误移动依然不可避免,我们只能抑制这种负面趋势而无法完全消除它.正如图5中的“预训练后”图所示,在两大簇数据的周围还存在着零星的离群点,这些离群点是预训练模型不能有效区分的困难样本.图5中的“微调后”图代表有监督对比微调训练后得到的最终情感分类模型,与图5中的“预训练后”图相比测试集数据被分成了更为明显的2簇且离群样本规模减少,这说明有监督微调过程中采用的对比学习策略对预训练模型的参数进行了修正且进一步加强了模型对情感极性的区分能力,同时也说明对非同类样本的多次采样使得对比学习策略也具备了一定的抗噪声能力.因此经过微调后的模型对非同类样本的区分度更加明显,且一定程度上约束了离群点对分类效果的影响.

如图5所示,我们可以观察到测试集数据在模型不同训练阶段中的变化情况,由最初的散乱分布再到具备初步的同类聚合、非同类分离趋势,最后达到被划分为明显的2簇数据的效果.测试集数据的这3种变化情况与模型在不同训练阶段中的预期目标相一致.弱监督预训练更为关注噪声数据产生负面影响的消除工作,而有监督对比微调则侧重于捕获训练样本的对比模式,这2个训练过程在本文的情感分类任务中均发挥了不可替代的作用.

4 总 结

现有的多数有监督深度情感分类方法都需要使用大量的人工标注数据训练分类模型,但人工标注数据获取成本高昂限制了训练数据的规模.有限的标注数据难以充分训练大规模语言模型(如BERT,RoBERTa等),从而制约了深度学习方法的性能.互联网为情感分类任务提供了海量的弱标注文本评论.本文立足于海量的弱标注数据,提出了一种可用于极小样本场景下的弱监督对比学习(WCL)方法.该方法可充分学习弱标注数据的潜在情感信息同时削弱噪声样本带来的负面影响,并充分挖掘小规模标注数据中的类间对比模式.在亚马逊评论数据上的实验结果充分验证了本文所提出方法的有效性和优越性.更为重要的是,我们所提出的方法在标注成本几乎可忽略的极小样本场景下取得了显著优于同类方法的性能,有效解决了缺乏大规模标注数据这一制约深度情感分类方法的瓶颈问题.

作者贡献声明:卢绍帅负责实验设计与结果分析;陈龙负责方法设计与初稿撰写;卢光跃指导课题研究方向的设立;管子玉负责初稿审阅与修改;谢飞负责文献调研.

[1]Nasukawa T, Yi J. Sentiment analysis: Capturing favorability using natural language processing[C] //Proc of the 2nd Int Conf on Knowledge Capture. New York: ACM, 2003: 70-77

[2]Pang Bo, Lee L, Vaithyanathan S. Thumbs up: Sentiment classification using machine learning techniques[C] //Proc of the Conf on Empirical Methods in Natural Language Processing. Cambridge, MA: MIT Press, 2002: 79-86

[3]Dave K, Lawrence S, Pennock D M. Mining the peanut gallery: Opinion extraction and semantic classification of product reviews[C] //Proc of the 12th Int World Wide Web Conf. New York: ACM, 2003: 519-528

[4]Glorot X, Bordes A, Bengio Y. Domain adaptation for large-scale sentiment classification: A deep learning approach[C] //Proc of the 28th Int Conf on Machine Learning. New York: ACM, 2011: 513-520

[5]Kim Y. Convolutional neural networks for sentence classification[J]. arXiv preprint, arXiv: 1408. 5882, 2014

[6]Mikolov T, Chen Kai, Corrado G, et al. Efficient estimation of word representations in vector space[J]. arXiv preprint, arXiv: 1301. 3781, 2013

[7]Pennington J, Socher R, Manning C D. Glove: Global vectors for word representation[C] //Proc of the Conf on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2014: 1532-1543

[8]Devlin J, Chang Mingwei, Lee K, et al. BERT: Pre-training of deep bidirectional transformers for language understanding[J]. arXiv preprint, arXiv: 1801. 0405, 2018

[9]Deriu J, Lucchi A, De Luca V, et al. Leveraging large amounts of weakly supervised data for multi-language sentiment classification[C] //Proc of the 26th Int Conf on World Wide Web. New York: ACM, 2017: 1045-1052

[10]Chen Ting, Kornblith S, Norouzi M, et al. A simple framework for contrastive learning of visual representations[J]. arXiv preprint, arXiv: 2002. 05709, 2020

[11]Hu Mingqi, Liu Bing. Mining and summarizing customer reviews[C] //Proc of the 10th ACM SIGKDD Int Conf on Knowledge Discovery and Data Mining. New York: ACM, 2004: 168-177

[12]Turney P D. Thumbs up or thumbs down: Semantic orientation applied to unsupervised classification of reviews[C] //Proc of the 40th Annual Meeting of the Association for Computational Linguistics. Cambridge, MA: MIT Press, 2002: 417-424

[13]Ding Xiaowen, Liu Bing, Yu P S. A holistic lexicon-based approach to opinion mining[C] //Proc of the Int Conf on Web Search and Web Data Mining. New York: ACM, 2008: 231-240

[14]Pang Bo, Lee L. A sentimental education: Sentiment analysis using subjectivity summarization based on minimum cuts[C] //Proc of the 42nd Meeting on Association for Computational Linguistics. Cambridge, MA: MIT Press, 2004: 271-278

[15]Ye Qiang, Zhang Ziqiong, Law R. Sentiment classification of online reviews to travel destinations by supervised machine learning approaches[J]. Expert Systems with Applications, 2009, 36(3): 6527-6535

[16]Tompson J, Jain A, Lecun Y, et al. Joint training of a convolutional network and a graphical model for human pose estimation[J]. arXiv preprint, arXiv: 1406. 2984, 2014

[17]Szegedy C, Liu Wei, Jia Yangqing, et al. Going deeper with convolutions [J] arXiv preprint, arXiv: 1409. 4842, 2014

[18]Hinton G, Deng Li, Yu Dong, et al. Deep neural networks for acoustic modeling in speech recognition: The shared views of four research groups[J]. IEEE Signal Processing Magazine, 2012, 29(6): 82-97

[19]Sainath T N, Mohamed A R, Kingsbury B, et al. Deep convolutional neural networks for LVCSR[C] //Proc of Int Conf on Acoustics, Speech and Signal Processing(ICASSP). Piscataway, NJ: IEEE, 2013: 8614-8618

[20]Fei Hongliang, Li Ping. Cross-Lingual unsupervised sentiment classification with multi-view transfer learning[C] //Proc of the 58th Annual Meeting of the ACL. Stroudsburg, PA: ACL, 2020: 5759-5771

[21]Choi G, Oh S, Kim H. Improving document-level sentiment classification using importance of sentences[J]. arXiv preprint, arXiv: 2103.05167, 2021

[22]Cheng Yan, Yao Leibo, Zhang Guanghe, et al. Text sentiment orientation analysis of multi-channels CNN and BiGRU based on attention mechanism[J]. Journal of Computer Research and Development, 2020, 57(12): 2583-2595 (in Chinese)(程艳, 尧磊波, 张光河, 等. 基于注意力机制的多通道CNN和BiGRU的文本情感倾向性分析[J]. 计算机研究与发展, 2020, 57(12): 2583-2595)

[23]Sun Xiaowan, Wang Ying, Wang Xin, et al. Aspect-based sentiment analysis model based on dual-attention networks[J]. Journal of Computer Research and Development, 2019, 56(11): 2384-2395 (in Chinese)(孙小婉, 王英, 王鑫, 等. 面向双注意力网络的特定方面情感分析模型[J]. 计算机研究与发展, 2019, 56(11): 2384-2395)

[24]Pang Bo, Lee L. Opinion mining and sentiment analysis[J]. Foundations and Trends in Information Retrieval, 2008, 2(1/2): 1-135

[25]Hinton G E, McClelland J L,Rumelhart D E. Distributed Representations [M]. Pittsburgh, PA: Carnegie Mellon University, 1984

[26]Bengio Y, Ducharme R, Vincent P, et al. A neural probabilistic language model[J]. The Journal of Machine Learning Research, 2003, 3: 1137-1155

[27]Kalchbrenner N, Grefenstette E, Blunsom P. A convolutional neural network for modelling sentences[J]. arXiv preprint, arXiv: 1404. 2188, 2014

[28]Zhu Xiaodan, Sobihani P, Guo Hongyu. Long short-term memory over recursive structures[C] //Proc of the 32nd Int Conf on Machine Learning. New York: ACM, 2015: 1604-1612

[29]Sachin S, Tripathi A, Mahajan N, et al. Sentiment analysis using gated recurrent neural networks[J]. S N Computer Science, 2020, 1(2): 1-13

[30]Jawahar G, Sagot B, Seddah D. What does BERT learn about the structure of language[C] //Proc of the 57th Annual Meeting of the ACL. Stroudsburg, PA: ACL, 2019: 3651-3657

[31]Zhou Zhihua. A brief introduction to weakly supervised learning[J]. National Science Review, 2018, 5(1): 44-53

[32]Qu Lizhen, Gemulla R, Weikum G. A weakly supervised model for sentence-level semantic orientation analysis with multiple experts[C] //Proc of the Joint Conf on Empirical Methods in Natural Language Processing and Computational Natural Language Learning. Stroudsburg, PA: ACL, 2012: 149-159

[33]Guan Ziyu, Chen Long, Zhao Wei, et al. Weakly-supervised deep learning for customer review sentiment classification[C] //Proc of the 25th Int Joint Conf on Artificial Intelligence. New York: IJCAI, 2016: 3719-3725

[34]Li Xinye, Long Shenpeng, Zhu Jing. Survey of few-shot learning based on deep neural network[J]. Application Research of Computers, 2020, 37(8): 2241-2247 (in Chinese)(李新叶, 龙慎鹏, 朱婧. 基于深度神经网络的少样本学习综述[J]. 计算机应用研究, 2020, 37(8): 2241-2247)

[35]Jankowski N,Duch W, Gr![]() bczewski K. Meta-Learning in Computational Intelligence[M]. Berlin: Springer Science and Business Media, 2011

bczewski K. Meta-Learning in Computational Intelligence[M]. Berlin: Springer Science and Business Media, 2011

[36]Lake B M,Salakhutdinov R, Tenenbaum J B. One-shot learning by inverting a compositional causal process[C] //Proc of the 27th Advances in Neural Information Processing Systems. Cambridge, MA: MIT Press, 2013: 2526-2534

[37]Zhao Kailin, Jin Xiaolong, Wang Yuanzhuo. Survey on few-shot learning[J]. Journal of Software, 2021, 32(2): 349-369 (in Chinese)(赵凯琳, 靳小龙, 王元卓. 小样本学习研究综述[J]. 软件学报, 2021, 32(2): 349-369)

[38]Howard J, Ruder S. Universal language model fine-tuning for text classification[J]. arXiv preprint, arXiv: 1801.06146, 2018

[39]Nakamura A, Harada T. Revisiting fine-tuning for few-shot learning[J].arXiv preprint, arXiv: 1910.00216, 2019

[40]Gunel B, Du Jingfei, Conneau A, et al. Supervised contrastive learning for pre-trained language model fine-tuning[J]. arXiv preprint, arXiv: 2011.01403, 2020

[41]Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need[J]. arXiv preprint, arXiv: 1706.03762, 2017

[42]Wang Sida, Manning C D. Baselines and bigrams: Simple, good sentiment and topic classification[C] //Proc of the 50th Annual Meeting of the Association for Computational Linguistics. Cambridge, MA: MIT Press, 2012: 90-94

[43]Tang Duyu, Qin Bing, Liu Ting. Deep learning for sentiment analysis: Successful approaches and future challenges[J]. Wiley Interdisciplinary Reviews: Data Mining and Knowledge Discovery, 2015, 5(6): 292-303

[44]Maas A L, Daly R E, Pham P T, et al. Learning word vectors for sentiment analysis[C] //Proc of the 49th Annual Meeting of the Association for Computational Linguistics. Cambridge, MA: MIT Press, 2011: 142-155

[45]Chen Long, Guan Ziyu, He Jinhong, et al. A survey on sentiment classification[J]. Journal of Computer Research and Development, 2017, 54(6): 1150-1170 (in Chinese)

(陈龙, 管子玉, 何金红, 等. 情感分类研究进展[J]. 计算机研究与发展, 2017, 54(6): 1150-1170)

[46]Mikolov T, Sutskever I, Chen Kai, et al. Distributed repre-sentations of words and phrases and their compositionality[C] //Proc of the 27th Advances in Neural Information Processing Systems. Cambridge, MA: MIT Press, 2013: 3111-3119

[47]Maaten L V D, Hinton G. Visualizing data using t-SNE[J]. Journal of Machine Learning Research, 2008, 9(11): 2579-2605